En el mundo de los modelos de lenguaje LLM, elegir el más adecuado puede parecer complicado por la cantidad de alternativas existentes. Modelos como OpenAI, Gemini de Google, Cloud de Anthropic o Mistral presentan cada uno ventajas específicas en diferentes circunstancias y tareas.

¿Qué son los benchmarks y por qué son importantes para evaluar LLM?

Los benchmarks son pruebas especializadas para medir la eficiencia y precisión de los modelos en diferentes tareas. Al evaluar estos benchmarks puedes decidir objetivamente cuál modelo se adapta mejor a tus necesidades.

Principales benchmarks para matemáticas y lógica

- Aime 2024/2025: Evaluación de matemáticas olímpicas donde, por ejemplo, el modelo O3 mini alcanzó una precisión de 86.3%, superando generalmente el rendimiento humano.

- Frontier Math: Más desafiante, con una dificultad alta que ningún modelo ha superado aún el 20% al momento actual.

Benchmarks enfocados en conocimientos amplios

- Humanity Last Exam aborda múltiples áreas incluyendo biología, química, física y escritura. A la fecha ningún modelo ha superado el 21% en precisión.

- GPQA Diamond: Basado en respuestas expertas humanas en diversas materias, Gemini 2.5 Pro ha sobresalido con una precisión superior al 80%.

Benchmarks para tareas de programación y lógica

Para evaluar habilidades de codificación existen pruebas como: - SWE Bench, que posiciona modelos como Cloud 3.7 Sonet como líderes en programación.

Benchmarks para medición global del razonamiento

- AGI (Astrap Resonant Corpus) examina si un modelo puede razonar como un humano, evaluando además el costo asociado en términos monetarios a dicha precisión.

¿Cómo utilizar el Chatbot Arena para evaluaciones prácticas?

El Chatbot Arena permite a usuarios evaluar subjetivamente y de manera anónima los distintos modelos, evitando sesgos por marketing o preferencias personales. Este método ofrece una perspectiva más equilibrada y práctica sobre su rendimiento real en el día a día.

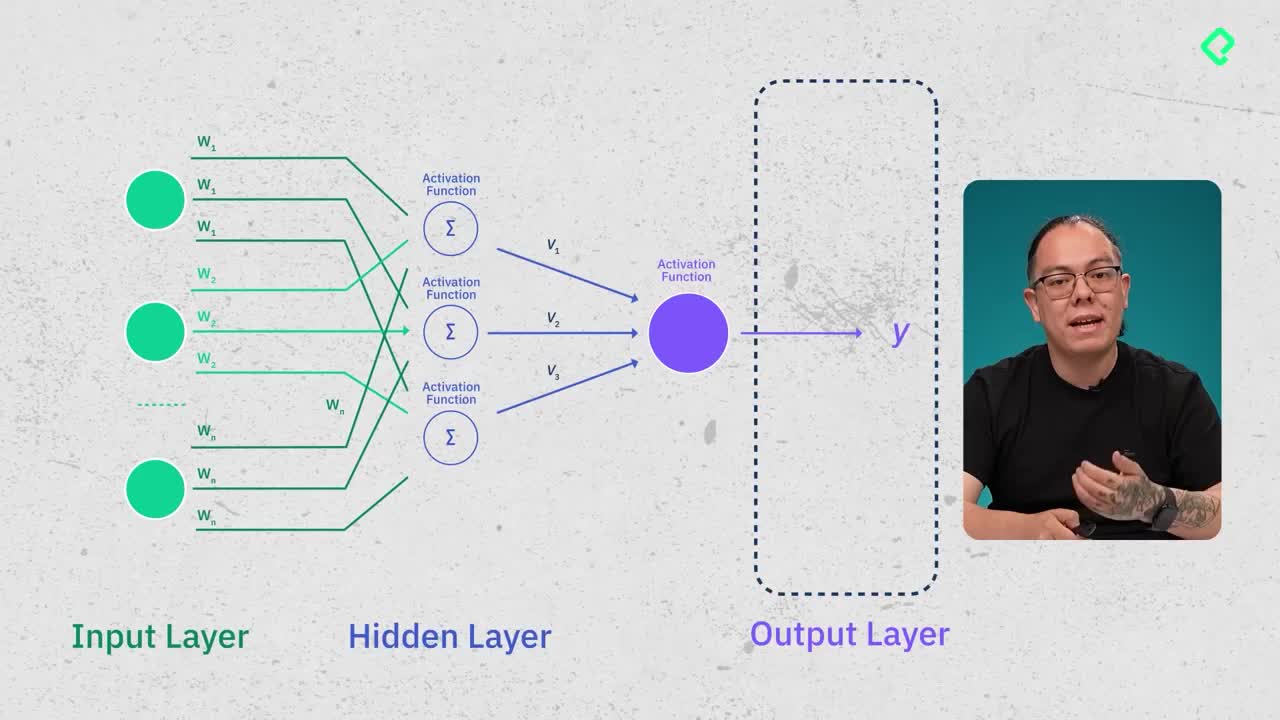

¿Cuándo elegir modelos de razonamiento frente a modelos estándar?

Los modelos de razonamiento, como O1, O3, O4 o Gemini 2.5, simulan nuestro método complejo de razonar, ideales para tareas difíciles y razonamientos extensos, aunque implican mayores costos operativos. Por otro lado, los modelos estándar son menos complejos pero más económicos.

Te invito a que explores continuamente cada modelo y utilices estas herramientas y benchmarks especializados para tomar decisiones informadas acorde con tus proyectos y necesidades profesionales. Recuerda seguir las actualizaciones de los principales laboratorios de desarrollo (OpenAI, Google DeepMind, Anthropic) pues cada actualización puede influir significativamente en tu trabajo.