Crear tu propio modelo GPT-2 desde cero puede parecer complejo, pero usando Python, PyTorch y Google Colab podrás realizarlo de forma práctica. El proceso incluye desde la configuración del entorno hasta la implementación del modelo, siempre enmarcado en la simplicidad de Google Colab con una GPU para mejorar el rendimiento.

¿Cómo configurar el entorno en Google Colab para construir GPT-2?

El primer paso para crear tu GPT-2 es estructurar adecuadamente Google Colab:

- Accede a la sección de recursos y selecciona GPU T4 para aprovechar su capacidad de procesamiento gráfico.

- Instala librerías esenciales como Einops, Xformers y NumPy (NP), además de PyTorch.

Esta configuración acelerará significativamente el desarrollo y la ejecución de tu proyecto.

¿Cuáles son los componentes clave del GPT-2?

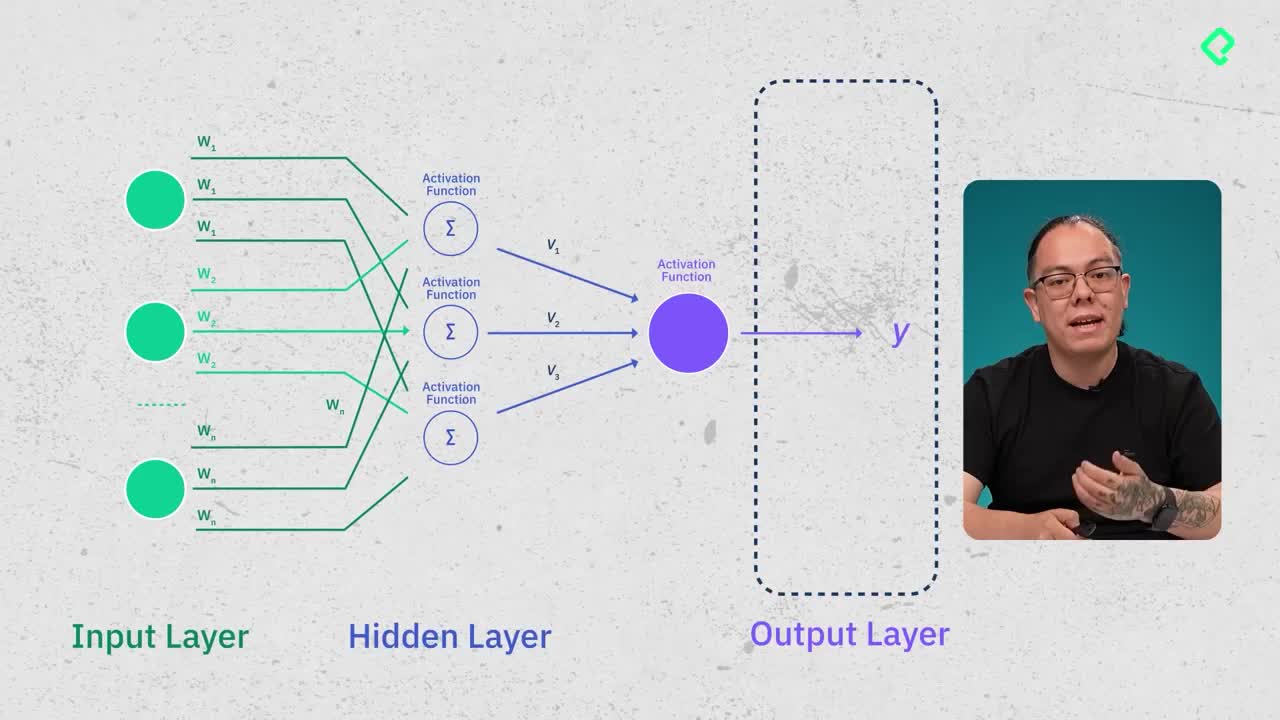

GPT-2 integra varios módulos fundamentales que trabajarás en columnas separadas para claridad y organización:

- Atención multi-cabezal (multi-head attention): biblioteca NN de PyTorch permite implementar consultas (queries), claves (keys) y valores (values) que permiten al modelo entender el contexto.

- Feed Forward Network: red neuronal básica que incluye capas convolucionales, activaciones (function hello) y dropout para evitar sobreaprendizaje.

- Normalización de capas (layer norm): proporciona estabilidad al entrenamiento del modelo.

En la práctica, PyTorch automatiza procesos complejos, facilitando tareas de programación como el cálculo de gradientes (backward function).

¿Cómo ejecutar y validar tu modelo GPT-2?

Una vez construido el GPT-2, verifica:

- La carga y ejecución de los parámetros pre-entrenados.

- Validación del ambiente GPU (CUDA).

- Uso de funciones auxiliares para duplicar módulos y realizar operaciones específicas como split heads y merge heads.

Puedes probar tu modelo dando textos básicos en inglés al tokenizer. El modelo generará nuevos tokens próximos, validando así tu implementación. Ten presente que GPT-2 fue entrenado para un contexto máximo de mil veinticuatro tokens y opera principalmente en inglés.

Anímate a explorar estas herramientas de inteligencia artificial y comparte en los comentarios tus experiencias o inquietudes en el proceso de construir tu propio GPT-2.