Imagina poder optimizar el rendimiento de los modelos de lenguaje, reduciendo significativamente el tiempo y dinero invertidos en su entrenamiento. Esto es posible gracias al enfoque conocido como Mixture of Experts (MOE), una técnica innovadora que permite crear modelos especializados en tareas concretas, tal como sucede en nuestro cerebro con el aprendizaje especializado.

¿qué es exactamente un modelo Mixture of Experts (MOE)?

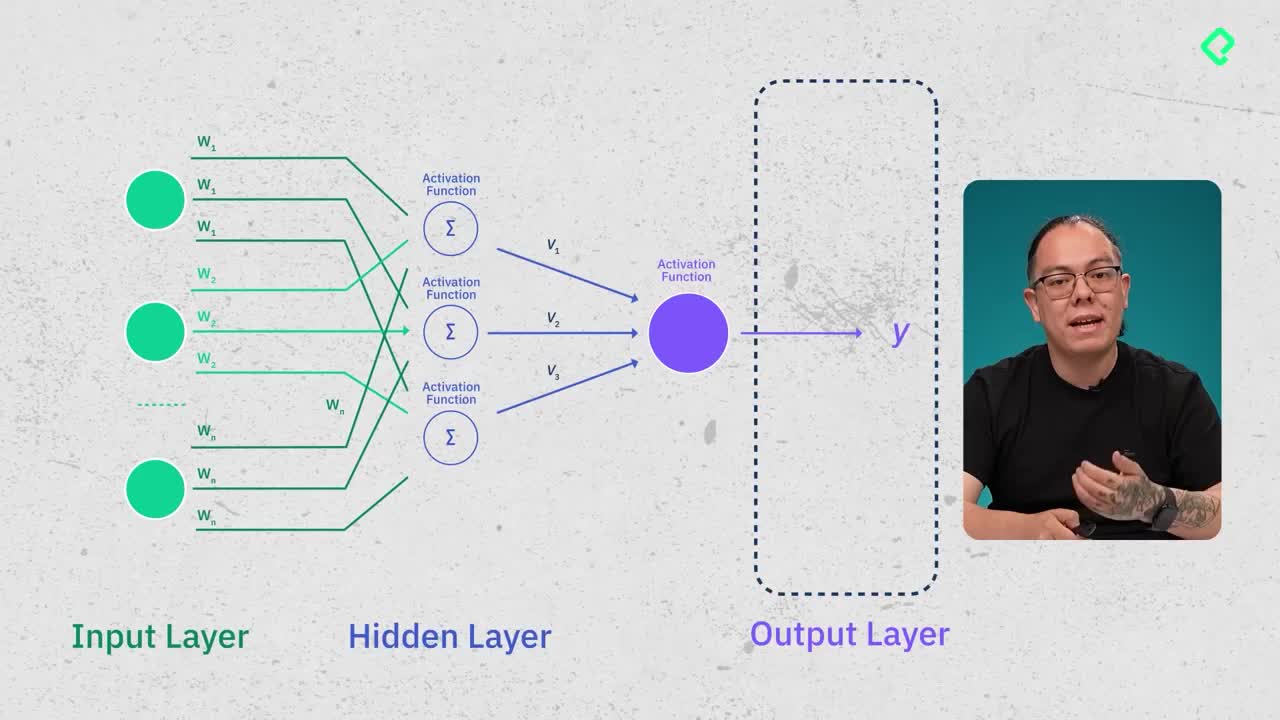

Los modelos Mixture of Experts (MOE) son versiones optimizadas de los conocidos transformadores, cuya principal característica es dividir el aprendizaje en diversas especializaciones pequeñas (expertos). En vez de entrenar una inmensa red general que responda todo tipo de preguntas, se entrenan múltiples modelos más pequeños, cada uno especializándose en áreas específicas como programación, matemáticas o idiomas.

Cada uno de estos expertos actúa de forma independiente durante el entrenamiento inicial y posteriormente se combinan. El resultado es una arquitectura eficiente que utiliza solo una pequeña porción de parámetros durante la inferencia.

¿cuáles son los beneficios clave de usar MOE?

El principal beneficio de utilizar una estructura MOE radica en la eficiencia en cómputo. Mientras que los modelos convencionales requieren activar toda su enorme red neuronal para responder cada consulta, los modelos MOE solo activan un grupo limitado de expertos especializados. Esto permite:

- Menor uso de recursos: Los MOE ejecutan un cómputo significativamente menor, requiriendo menos GPUs y menos energía, logrando hasta 30 veces de ahorro computacional en comparación con los modelos densos tradicionales.

- Reducción del tiempo de entrenamiento: Gracias al entrenamiento paralelo de los expertos, el tiempo requerido baja considerablemente, pasando de meses a semanas y reduciendo así los costos operativos.

- Democratización tecnológica: Al reducir la necesidad de grandes infraestructuras y costosos chips, estos modelos hacen más accesible la tecnología de vanguardia a laboratorios y empresas más pequeñas, fomentando una distribución más equitativa del conocimiento tecnológico.

¿cómo selecciona el modelo qué expertos usar?

Aquí entra en juego otra pieza fundamental del enfoque MOE: la denominada gate network. Esta "red gate" funciona como un guía intuitivo, reconocido por identificar rápidamente qué expertos deben activarse según la consulta específica realizada por el usuario. Para compararlo con un ejemplo sencillo: la gate network es como ese vigilante en un parque temático que nos orienta hacia la atracción que buscamos rápidamente.

Adicionalmente, es importante mencionar dos términos relevantes:

- Sparsity (esparcidad): técnica que asegura que la gate network dirija únicamente hacia expertos relevantes, evitando activar innecesariamente áreas de la red no útiles.

- Load balancing: en entrenamiento e inferencia asegura que los expertos se activen adecuadamente en función de la tarea requerida.

¿cuáles son los retos actuales del uso de modelos MOE?

Aunque los modelos MOE presentan grandes ventajas, también implican consideraciones prácticas importantes. Una de ellas es que, aunque la inferencia activa sólo ciertos expertos, todos los parámetros del modelo deben estar previamente cargados en la memoria VRAM de las GPUs, demandando significativamente más memoria video incluso de la que usan en ejecución.

Por otra parte, asegurar que la red distribuya tareas equitativamente entre expertos para evitar sobrecargas (load balancing) y optimizar la respuesta es uno de los retos actuales más importantes en esta tecnología. Además, la investigación actual explora cómo los modelos pueden utilizar simultáneamente varios expertos para resolver preguntas complejas, optimizando así la calidad de las respuestas.

¿cuál es el impacto potencial de los modelos MOE?

En definitiva, los modelos MOE ofrecen una solución atractiva y eficiente en términos de costos y rendimiento. No solo permiten desarrollar modelos potentes utilizando menos recursos, sino que además abren la puerta a nuevas oportunidades para laboratorios e investigadores independientes alrededor del mundo, incluidos aquellos de Latinoamérica. Estos modelos facilitan la participación competitiva a nivel global, sin depender obligatoriamente del acceso a la última tecnología del mercado.

¿Tienes preguntas o comentarios sobre cómo implementar o trabajar con los modelos MOE? ¡Comparte tus ideas y experiencias a continuación, estaremos encantados de conversar contigo!