Flujo de comunicación entre aplicaciones y sistemas RAG

Clase 3 de 22 • Curso de RAG con Microsoft Azure

Contenido del curso

Etapas de RAG

- 5

Embeddings y bases de datos vectoriales para documentos digitales

03:35 min - 6

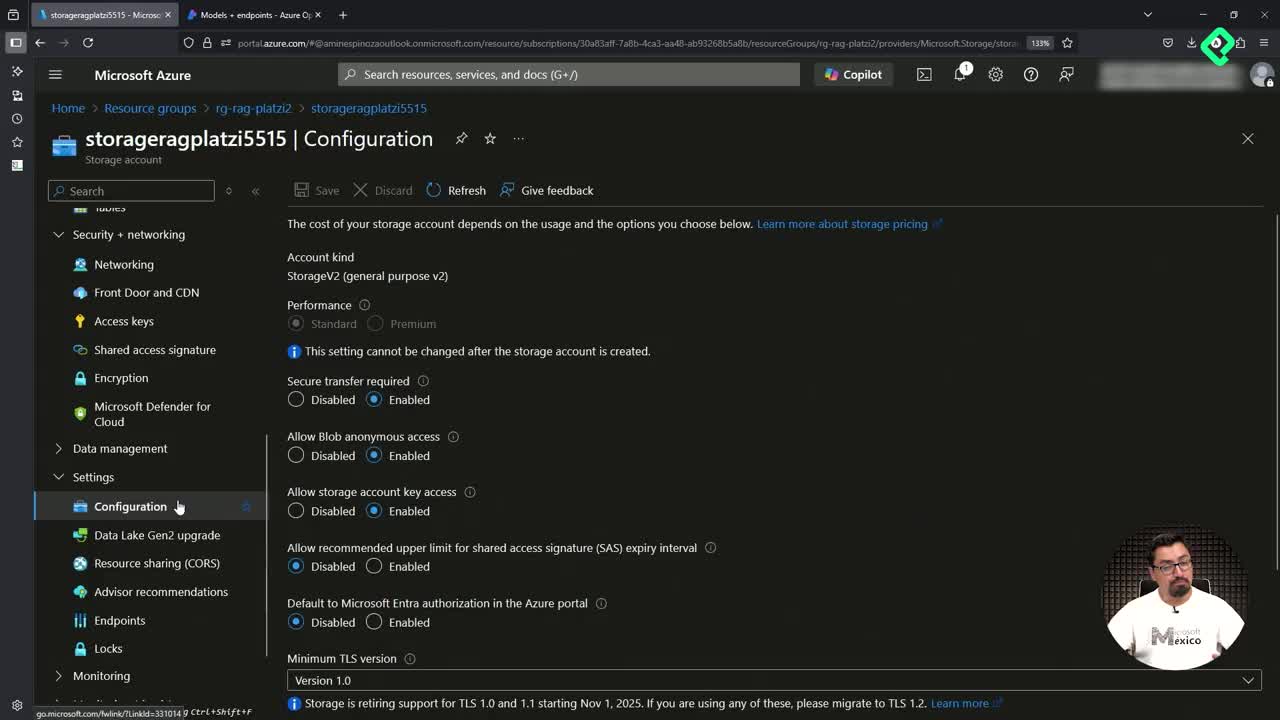

Configuración de Azure para RAG: preparativos y gestión de costos

03:51 min - 7

Qué son las bases de datos vectoriales y sus aplicaciones

04:50 min - 8

Despliegue de recursos de IA en Azure con scripts de Bash

05:15 min - 9

Despliegue de modelos GPT-4 y embeddings en Azure OpenAI

03:01 min - 10

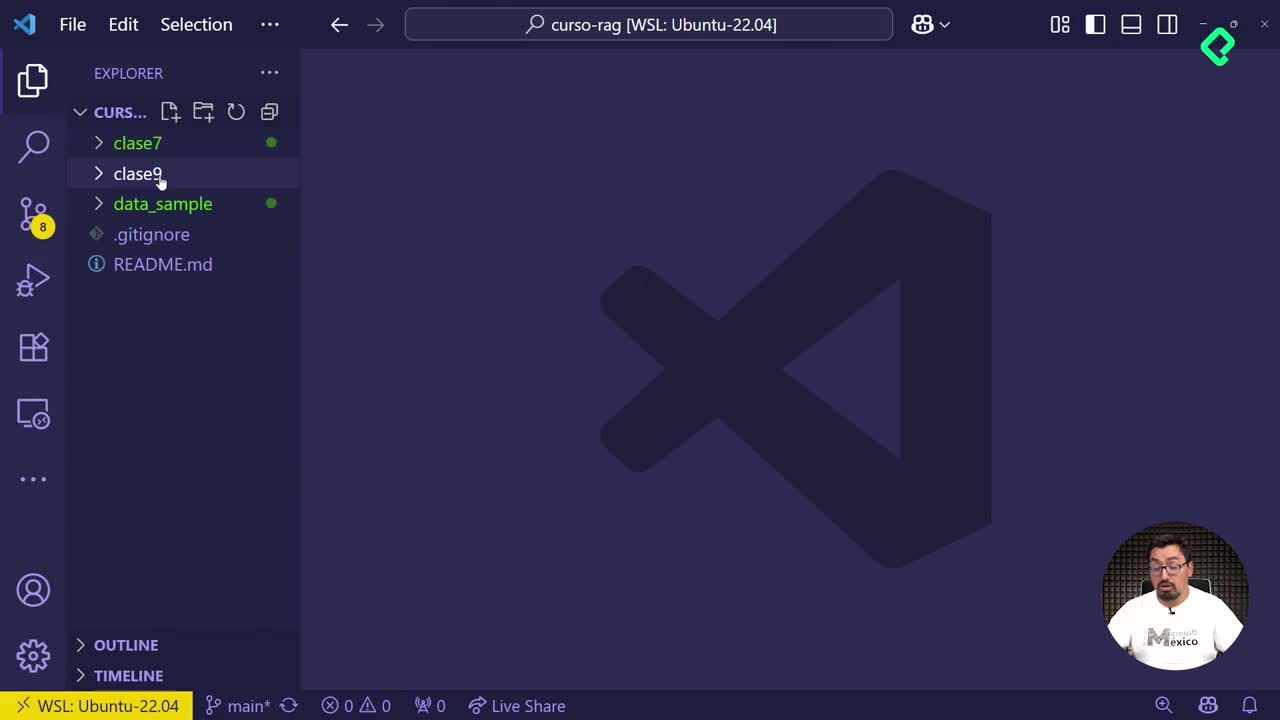

Configuración de Jupyter Notebook y ambientes virtuales en Python

03:37 min

Tecnicas de RAG

- 11

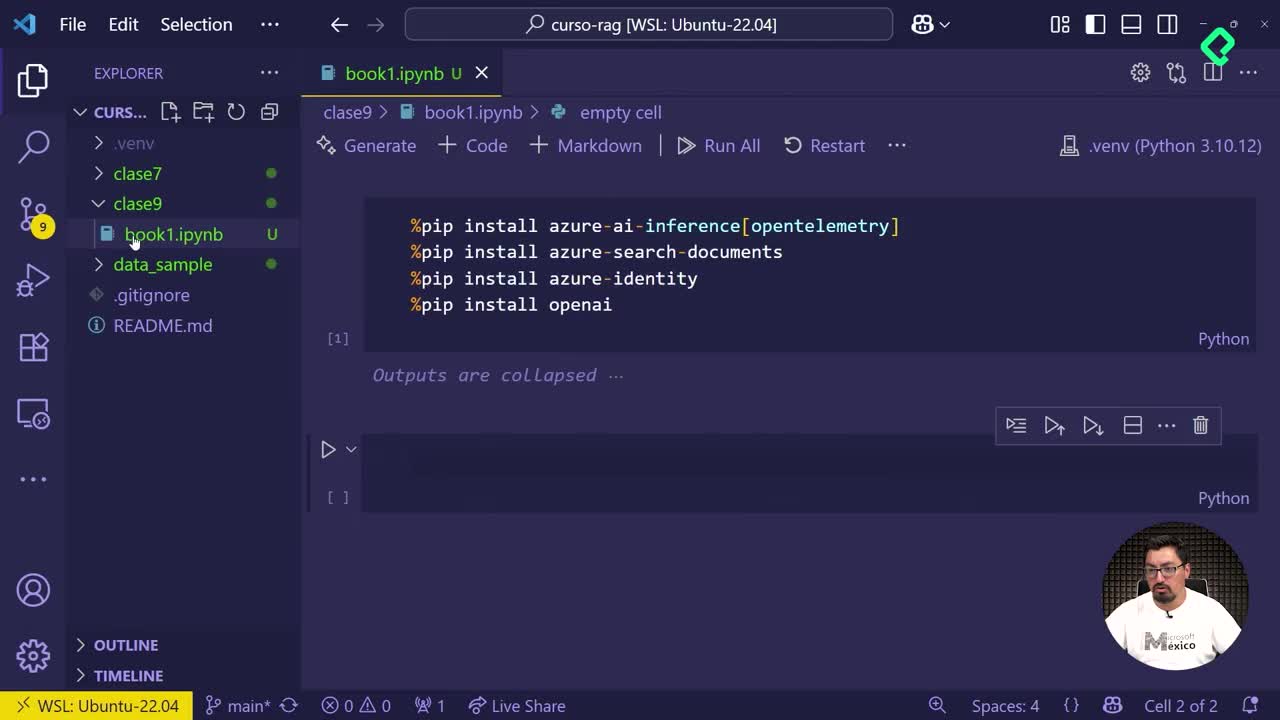

Vectorización de documentos con Azure Search y OpenAI

06:15 min - 12

Configuración de Azure OpenAI y AI Search en Jupyter Notebook

06:56 min - 13

Integración de LLM para optimizar respuestas en Jupyter Notebook

03:09 min - 14

Actualización manual de índices con nuevos documentos PDF

03:17 min - 15

Búsqueda tradicional, vectorial e híbrida en Azure AI Search

06:05 min

RAG avanzado

- 16

Creación de múltiples índices en Azure AI Search con Jupyter

09:40 min - 17

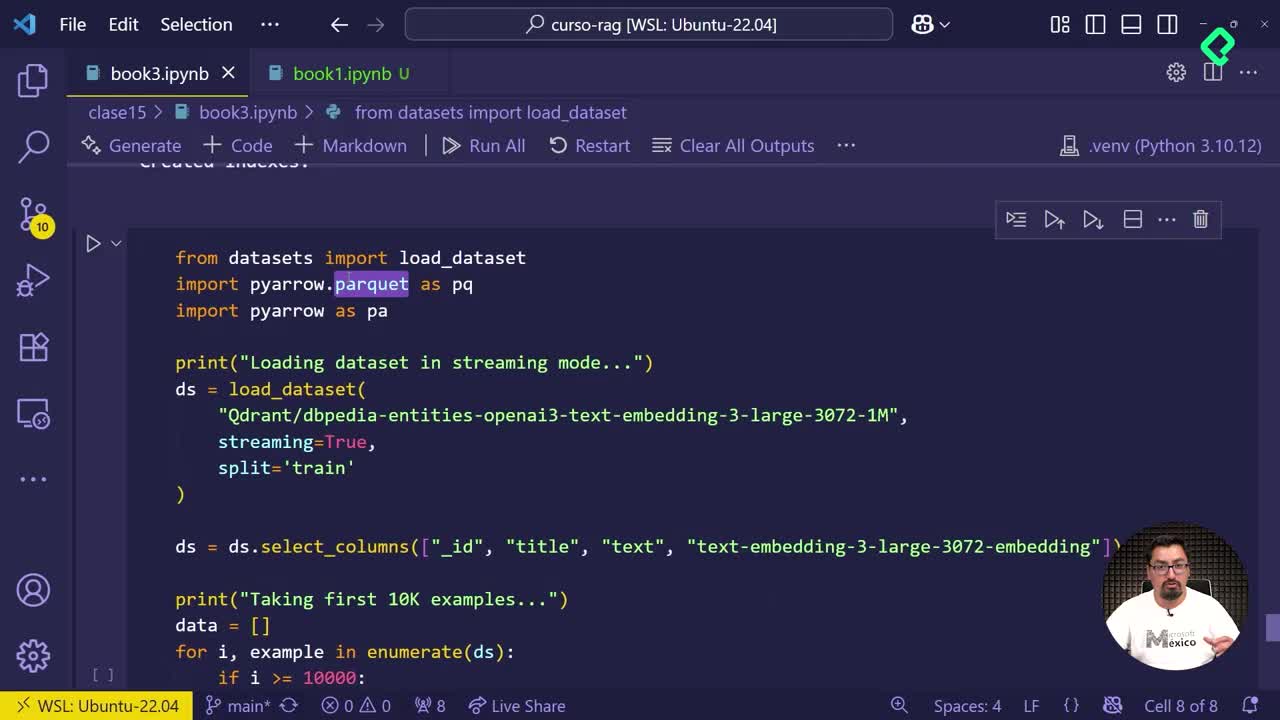

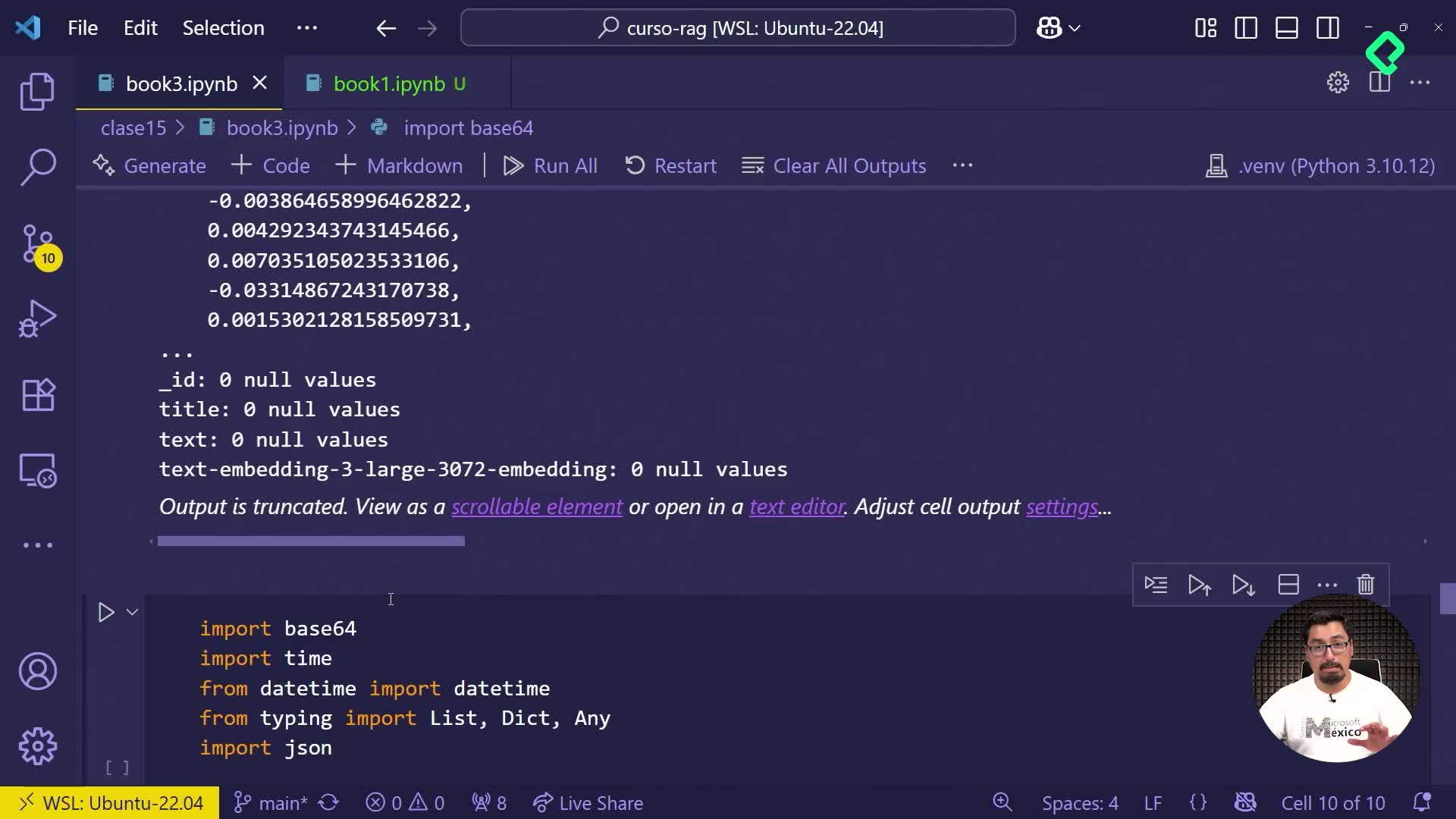

Generación de información ficticia con archivos Parquet

03:14 min - 18

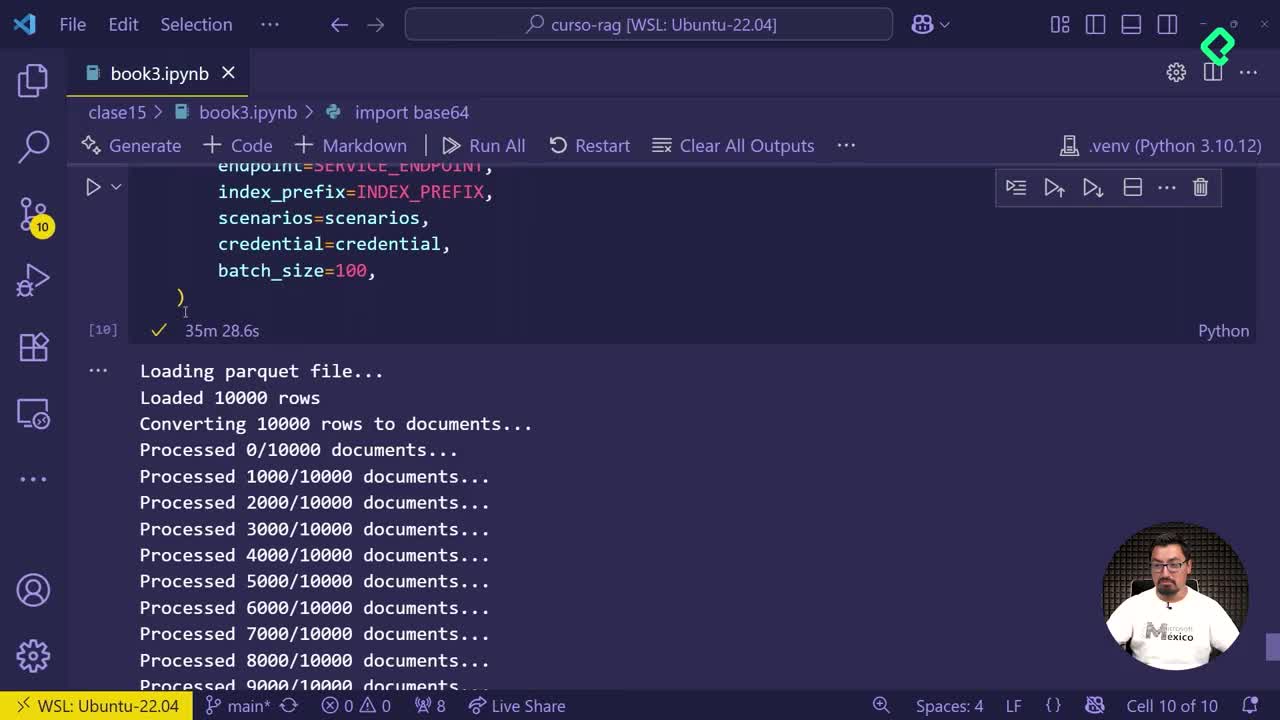

Subida automática de documentos fragmentados a Azure AI Search

02:53 min - 19

Comparación de índices en Azure para optimizar almacenamiento

03:59 min - 20

Creación de aplicación demo con Azure Search Service

03:39 min

Fusionando RAG con un agente

¿Sabes cómo funciona realmente un sistema inteligente integrado con RAG y modelos LLM? Contrario a lo comúnmente asumido, una aplicación no se conecta directamente con modelos como GPT-4, Gemini o cualquier LLM. El elemento clave en este flujo es un agente de orquestación, fundamental para gestionar eficazmente la comunicación entre aplicaciones, modelos y bases de datos.

¿Por qué es esencial el agente de orquestación?

Al construir sistemas basados en Recuperación Aumentada por Generación (RAG, por sus siglas en inglés), es habitual pensar que integrar datos adicionales en un agente o guardar información en bases de datos es sencillo. Sin embargo, muchas veces la práctica difiere de la teoría. Aquí entra en juego el valor del agente de orquestación:

- Evita conexiones directas entre aplicaciones y modelos LLM.

- Proporciona una intermediación eficiente que reduce errores.

- Gestiona la recuperación efectiva de información desde múltiples bases de datos, ya sean estructuradas, no estructuradas o vectoriales.

La relevancia de este agente implica que cualquier adaptación o cambio de modelo requiere ajustes menores, simplificando así todo el proceso.

¿Cómo interactúan entre sí la aplicación, agente y sistemas RAG?

La ejecución efectiva del flujo implica ciertos pasos esenciales:

- La aplicación se comunica primero con el agente de orquestación.

- El agente consulta al sistema RAG en búsqueda de información relevante.

- Una vez obtenida la información desde RAG, el agente utiliza un modelo LLM para presentarla de manera clara y comprensible.

Este flujo demuestra que ningún elemento opera en aislamiento. Siempre es necesario contar con la intermediaría efectiva del agente para combinar el potencial de ambos sistemas (RAG y LLM).

¿Cuál es el papel específico de RAG en este flujo?

El sistema RAG es la figura central en cuanto a almacenamiento y recuperación de información:

- Se vincula directamente con diversas fuentes de información.

- Filtra y entrega información relevante al agente de orquestación.

- Actúa antes de involucrar a los modelos LLM, optimizando respuestas y minimizando errores.

¿Por qué practicar el flujo de información continuamente?

Entender y dominar este proceso es crucial para desarrollar sistemas inteligentes efectivos. Por ello, practicar y reiterar el flujo frecuentemente permite:

- Interiorizar cómo se interconectan aplicaciones, agentes y sistemas.

- Reducir significativamente los errores durante el desarrollo.

- Optimizar eficientemente la ejecución y adaptación de modelos y bases de datos.

Comparte cómo aplicas tú estos conceptos en tus proyectos, estaré encantado de leerte en los comentarios.