Generación de información ficticia con archivos Parquet

Clase 17 de 22 • Curso de RAG con Microsoft Azure

Contenido del curso

Etapas de RAG

- 5

Embeddings y bases de datos vectoriales para documentos digitales

03:35 min - 6

Configuración de Azure para RAG: preparativos y gestión de costos

03:51 min - 7

Qué son las bases de datos vectoriales y sus aplicaciones

04:50 min - 8

Despliegue de recursos de IA en Azure con scripts de Bash

05:15 min - 9

Despliegue de modelos GPT-4 y embeddings en Azure OpenAI

03:01 min - 10

Configuración de Jupyter Notebook y ambientes virtuales en Python

03:37 min

Tecnicas de RAG

- 11

Vectorización de documentos con Azure Search y OpenAI

06:15 min - 12

Configuración de Azure OpenAI y AI Search en Jupyter Notebook

06:56 min - 13

Integración de LLM para optimizar respuestas en Jupyter Notebook

03:09 min - 14

Actualización manual de índices con nuevos documentos PDF

03:17 min - 15

Búsqueda tradicional, vectorial e híbrida en Azure AI Search

06:05 min

RAG avanzado

- 16

Creación de múltiples índices en Azure AI Search con Jupyter

09:40 min - 17

Generación de información ficticia con archivos Parquet

Viendo ahora - 18

Subida automática de documentos fragmentados a Azure AI Search

02:53 min - 19

Comparación de índices en Azure para optimizar almacenamiento

03:59 min - 20

Creación de aplicación demo con Azure Search Service

03:39 min

Fusionando RAG con un agente

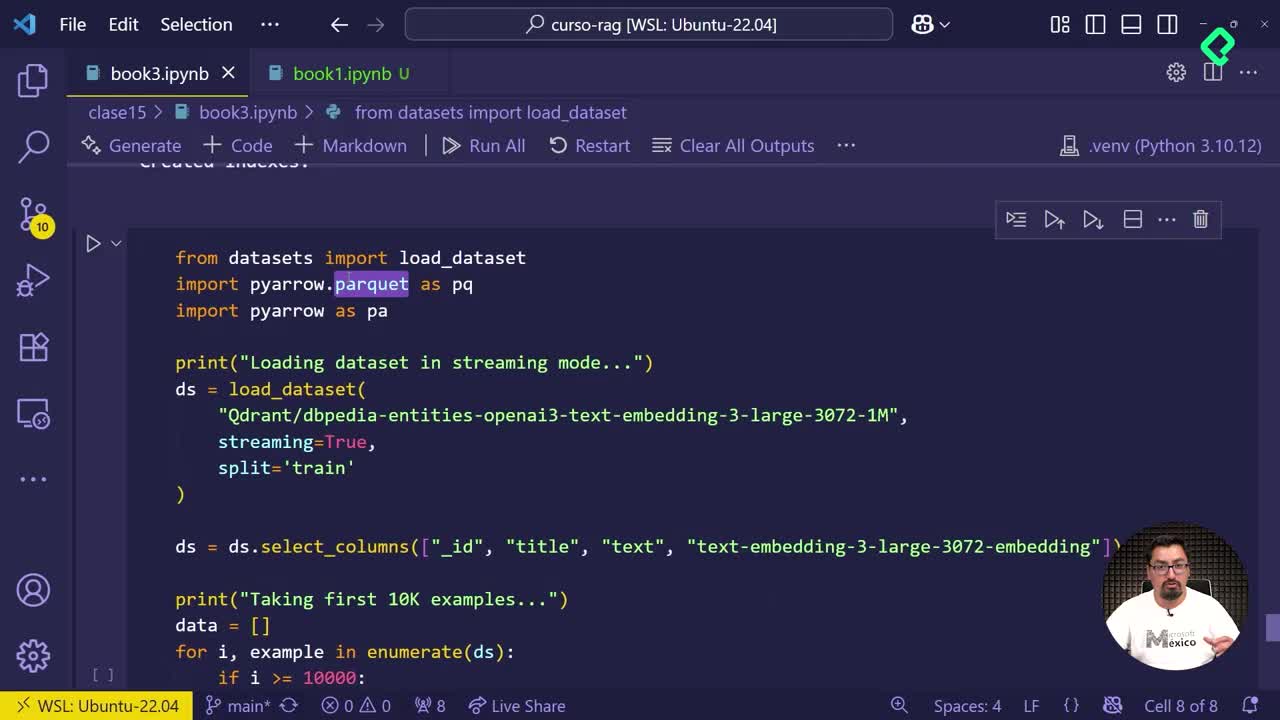

Gestionar y analizar grandes volúmenes de información se vuelve más sencillo empleando archivos en formato Parquet, especialmente diseñados para la ciencia de datos. Al usar modelos large, puedes manejar eficazmente grandes cantidades de registros, garantizando análisis más precisos y completos.

¿Por qué utilizar archivos Parquet en ciencia de datos?

Los archivos Parquet destacan por su eficiencia al gestionar datos en grandes volúmenes. Entre sus ventajas principales están:

- Capacidad para manejar datos con estructura compleja.

- Adecuados para analítica intensa.

- Rapidez en ejecución y menor consumo de recursos.

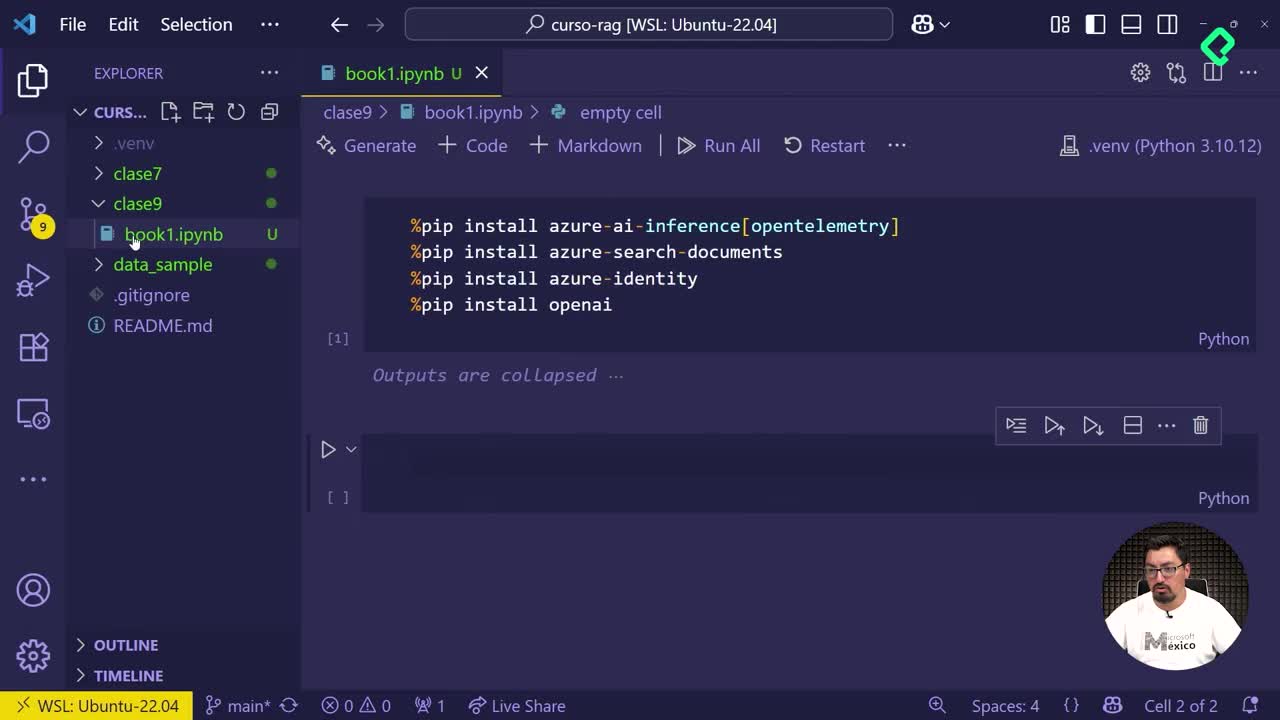

¿Cómo generar información ficticia para análisis de datos?

Para realizar ejercicios prácticos en análisis de datos, puedes generar información ficticia (dummy data). Usar un modelo configurado con gran cantidad de muestras te permite:

- Evaluar el impacto de modelos amplios.

- Mejorar la precisión del análisis trabajando con tamaños de muestra significativos.

- Ahorrar tiempo, usando resultados generados automáticamente.

En la práctica, es factible trabajar con ejemplos en diferentes escalas según tu disponibilidad de tiempo, lo más recomendado es utilizar muestras grandes que muestren claramente el impacto del procesamiento.

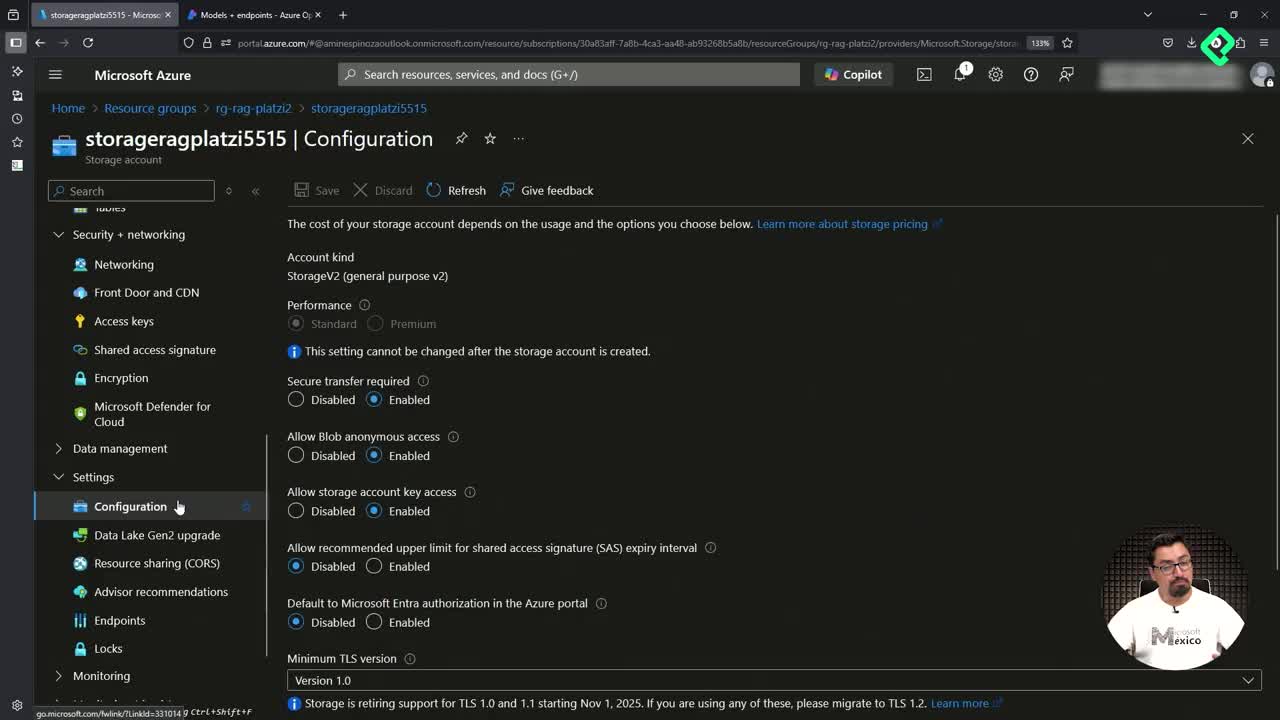

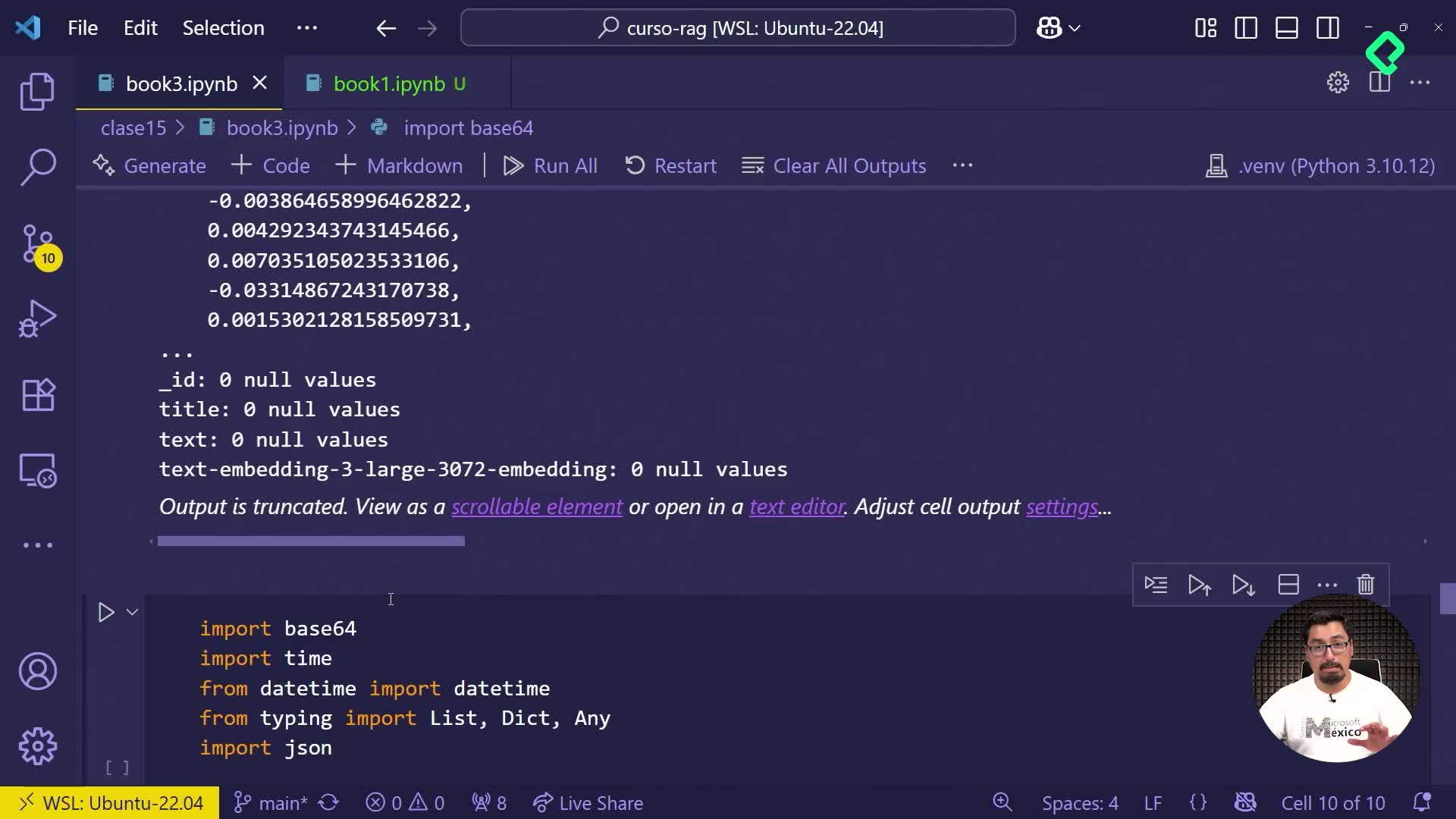

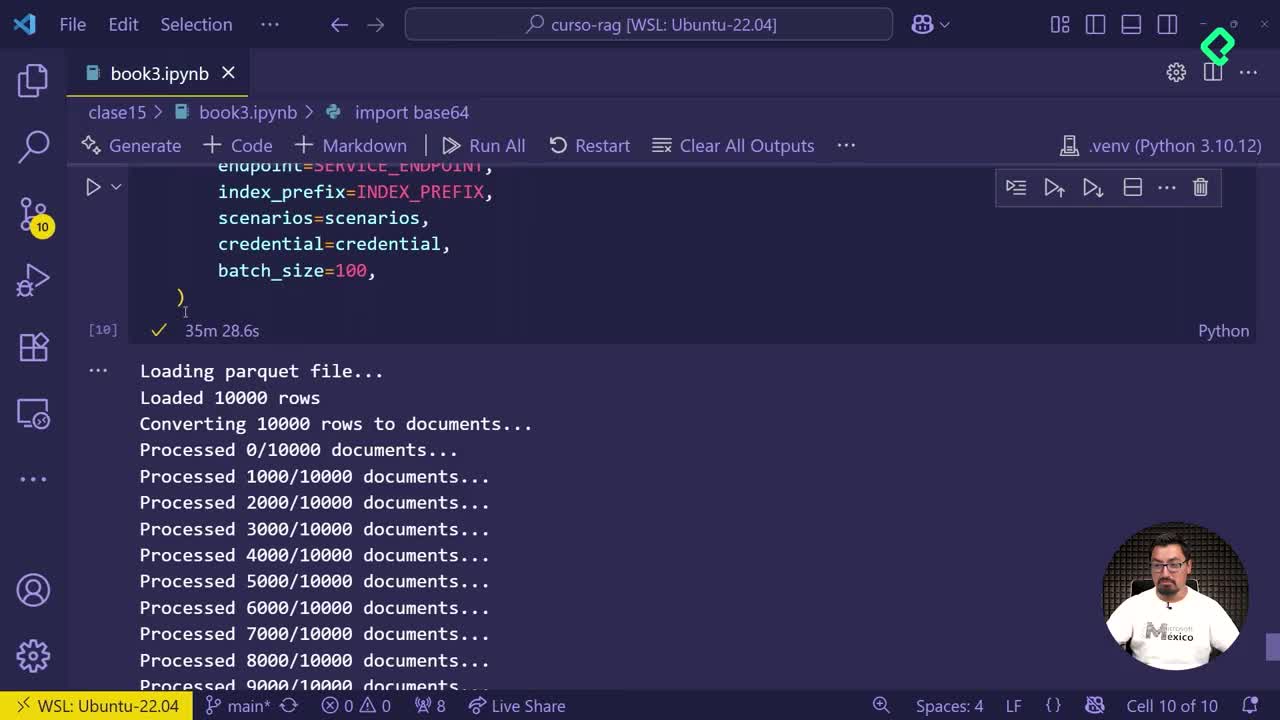

¿Cómo subir y gestionar datos en la nube?

Subir datos estructurados en la nube facilita el acceso y la gestión posterior. Los pasos principales para subir tu tabla generada a partir del archivo en formato Parquet incluyen:

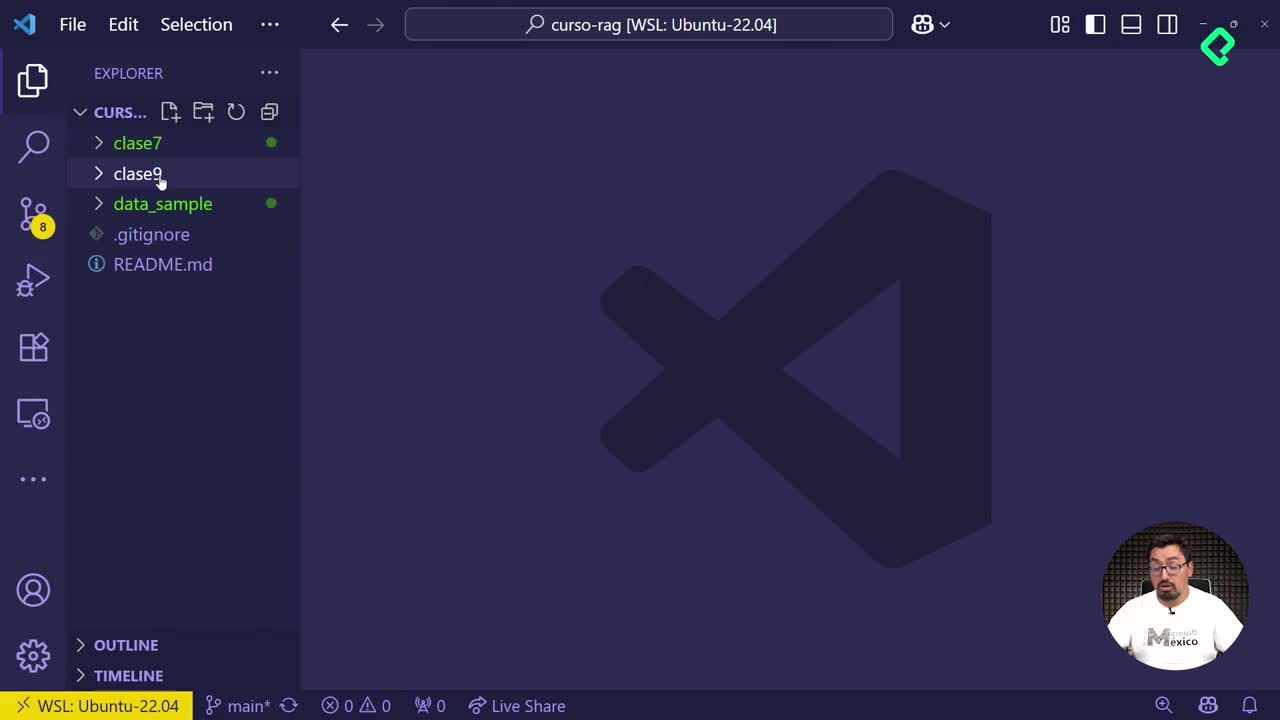

- Crear y guardar tu dataset localmente con estructura de índices adecuada.

- Subir la tabla estructurada a la nube para almacenamiento y posterior análisis.

Este procedimiento optimiza tu proceso de análisis al contar con la información disponible, organizada y fácilmente accesible desde cualquier ubicación.

¡Si tienes dudas sobre el manejo de archivos Parquet o sobre almacenamiento en la nube, compártelas en los comentarios y sigamos aprendiendo juntos!