Configuración de modelos TensorFlow Lite en Flutter

Clase 4 de 29 • Curso de Integración Módulos Nativos iOS/Android para Flutter

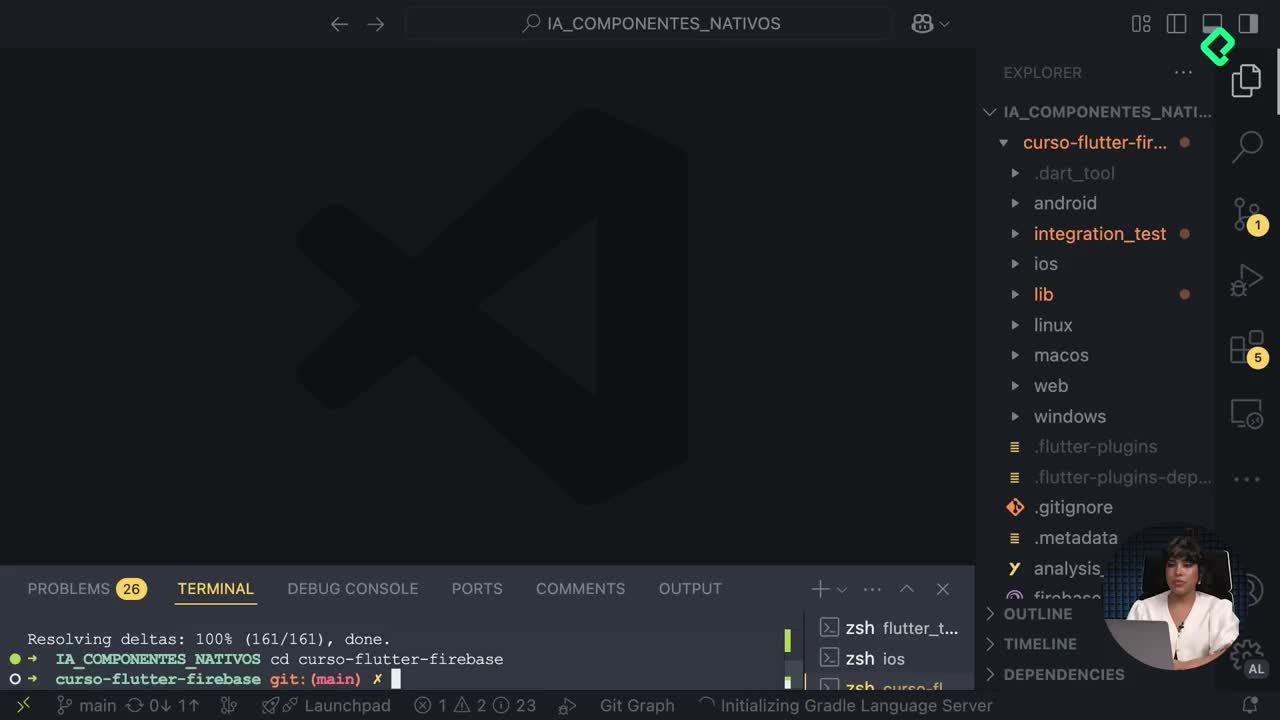

Contenido del curso

Introducción a TensorFlow Lite

Integración de modelos y clasificación de imágenes

Reconocimiento de voz con Whisper

MethodChannel

Acceso a sensores y cámara

- 16

Configuración de Method Channel para cámara en Android desde Flutter

10:54 min - 17

Configuración de AppDelegate para acceso a la cámara en Flutter iOS

12:37 min - 18

Configuración de permisos y provider para cámara en Android

10:13 min - 19

Configuración de permisos de cámara en iOS para Flutter

06:39 min - 20

Integración de cámara nativa iOS en Flutter con Method Channels

13:52 min - 21

Controladores de imagen en iOS con Flutter

12:31 min - 22

Implementación de cámara nativa en apps Android con Flutter

12:22 min

Gestión de estado con BLoC

Reconocimiento de texto en imágenes

- 25

Extracción de montos numéricos con expresiones regulares

07:09 min - 26

Integración de UI con cámara para captura de fotos en Flutter

06:20 min - 27

Integración de widget de fotografía con patrón Bloc en Flutter

09:00 min - 28

Actualización de dependencias y corrección de errores en Flutter iOS

15:44 min - 29

Diferencias entre Flutter y React Native para desarrollo móvil

11:55 min

Si estás interesado en integrar modelos avanzados en tus aplicaciones móviles, aprender a utilizar TensorFlow Lite es fundamental. La implementación práctica de este tipo de herramienta permite aprovechar modelos preentrenados para reconocimiento o clasificación desde tu propio proyecto móvil. A continuación, se describen claramente cada uno de los pasos importantes para cumplir este propósito.

¿Cómo descargar y organizar los modelos en el proyecto?

El primer paso fundamental consiste en descargar los archivos necesarios, específicamente el archivo del modelo y los labels que lo acompañan. Ambos documentos deben guardarse en una carpeta específica llamada models, que estará dentro del directorio assets de tu proyecto. Es importante mantener los nombres originales de los archivos para facilitar su uso posterior.

Luego, se debe realizar una configuración en tu archivo YAML para asegurar que la aplicación pueda acceder correctamente a estos recursos desde la carpeta especificada. Esto implica descomentar la sección de assets y colocar las direcciones precisas a los archivos descargados, asegurando que la ruta exacta corresponda con tu estructura.

¿Qué pasos seguir para usar la librería de TensorFlow Lite?

Al integrar esta librería en tu proyecto móvil, debes hacer lo siguiente:

- Crear una nueva clase denominada TensorFlow service, donde se importará la librería TensorFlow Lite específica para tu proyecto.

- Definir un intérprete usando la sintaxis recomendada:

Interpreter interpreter;

- Crear una función asíncrona llamada load model, responsable de cargar el archivo modelo mediante un sistema de etiquetado de errores tipo try-catch, lo cual permite gestionar potentes respuestas sobre la carga del modelo seleccionado.

En esta función, asegúrate de especificar claramente la ubicación exacta del archivo modelo:

await interpreter.fromAsset('assets/models/model.tflite');

Además, se recomienda realizar pruebas usando comandos sencillos como print para verificar paso a paso la correcta implementación.

¿Cómo verificar las entradas y salidas del modelo?

Una parte crucial del uso efectivo del modelo es confirmar claramente qué datos está recibiendo (inputs) y qué datos proporciona como respuesta (outputs). Para esto, se debe utilizar:

var inputShape = interpreter.getInputTensor(0).shape; var outputShape = interpreter.getOutputTensor(0).shape;

Esto se revisa mediante instrucciones condicionales que permiten capturar posibles errores fácilmente:

- Si el intérprete está activo, los datos de entrada y salida serán impresos mediante funciones específicas.

- Si hay errores, estos serán reportados inmediatamente a través de la consola.

¿Cómo ejecutar el modelo y entregar datos personalizados?

Para hacer uso del modelo cargado anteriormente, debes crear una función adicional nombrada runModel, también de forma asíncrona:

- La función deberá verificar nuevamente el estado cargado o no del modelo y retornar un valor vacío adecuado en caso de error.

- Generar un arreglo o listado representativo que actuará como una imagen manual para fines prácticos de demostración, definiendo características como número de imagen, altura, ancho y canales RGB.

- El resultado final proporcionado por el modelo se obtendrá por medio de la ejecución del intérprete utilizando las variables mencionadas:

var output = List.filled(outputShape.reduce((a, b) => a * b), 0).reshape(outputShape); interpreter.run(input, output);

Esta práctica ayuda a traducir claramente los resultados obtenidos de la clasificación o reconocimiento realizado por TensorFlow Lite y refleja la importancia del correcto formato de los datos procesados.

Te invitamos a explorar y aplicar estas recomendaciones en tus próximos proyectos, compartiendo tus dudas o experiencias en la sección de comentarios.