Bag of Words y TF-IDF para representación vectorial de texto

Clase 6 de 16 • Curso de NLP con Python

Contenido del curso

Técnicas Tradicionales de NLP para Documentos Empresariales

- 4

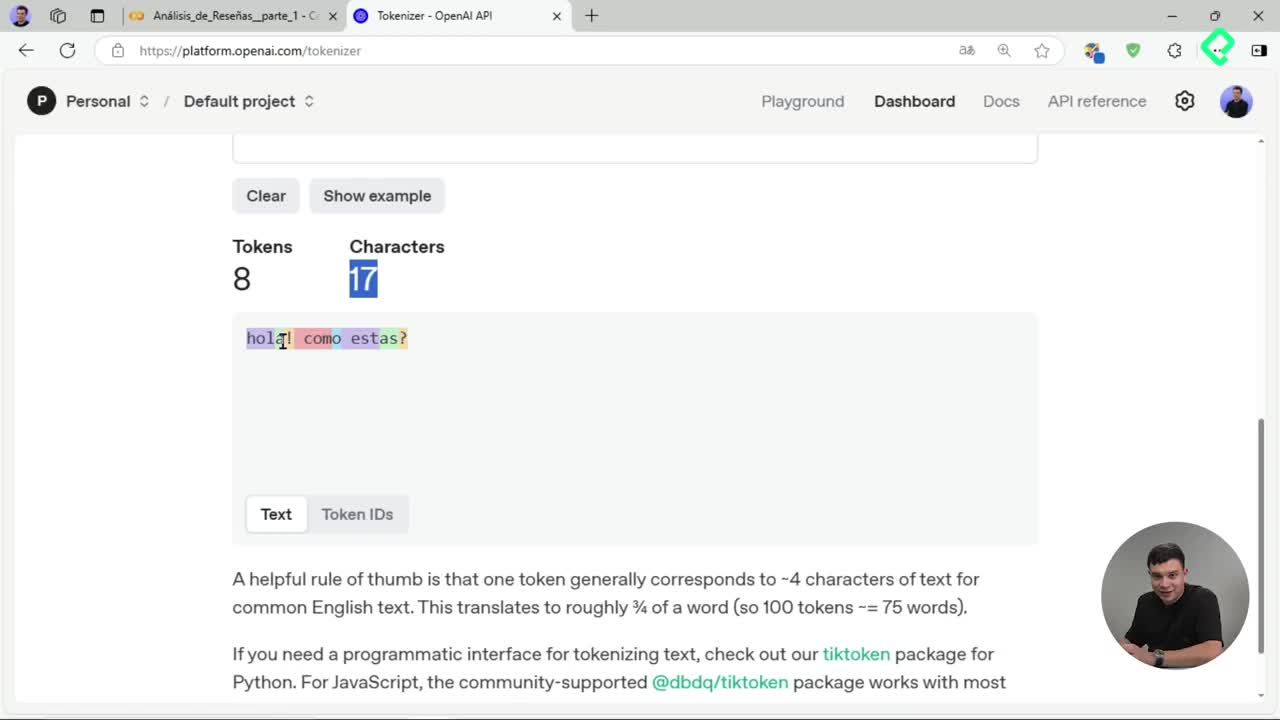

Tokenización de texto: división en unidades procesables para IA

06:52 min - 5

Creación de nubes de palabras con stemming y lematización

05:08 min - 6

Bag of Words y TF-IDF para representación vectorial de texto

Viendo ahora - 7

Análisis LDA para detectar temas ocultos en reseñas de texto

03:08 min - 8

Entrenamiento de clasificador Naive Bayes para reseñas de productos

07:42 min

Introducción y Profundización en Transformers para Aplicaciones Empresariales

- 9

Arquitectura Transformers en procesamiento de lenguaje natural

07:16 min - 10

Tokenización avanzada con Hugging Face y Transformers

04:22 min - 11

Análisis de sentimiento con modelos preentrenados de Hugging Face

04:00 min - 12

Reconocimiento de entidades con BERT y Transformers en español

05:46 min - 13

Fine tuning de modelos Transformer para análisis de sentimientos

10:18 min

Proyecto Final y Estrategia Comercial B2B

¿Te interesa aprender cómo se procesan y analizan los comentarios de usuarios para identificar opiniones positivas o negativas? Con herramientas como Google Colab y técnicas avanzadas como Bag of Words (BoW) y el método TF-IDF, puedes clasificar reseñas de manera eficiente, precisa y rápida.

¿Cómo configurar Google Colab con GPU para acelerar el entrenamiento?

El primer paso clave para clasificar reseñas es configurar correctamente tu entorno en Google Colab. Una GPU mejora significativamente el rendimiento al entrenar modelos. Para ello:

- Conecta tu cuaderno a una GPU dirigiéndote a la opción "editar", luego "configuración del cuaderno" y selecciona GPU.

- Al verificar tu conexión correcta, busca la indicación "GPU t cuatro".

- Ten presente subir archivos comprimidos (.zip o .rar) para agilizar la carga del dataset.

¿Cómo preparar y validar los datos antes del modelado?

Luego de conectar el entorno, debes cargar y validar tu dataset. Esto se realiza fácilmente usando pandas, una librería eficiente:

- Carga tu dataset previamente limpio, llamado aquí "review-clean-advance".

- Visualiza unas filas (mínimo tres) para validar la carga.

- Verifica y maneja adecuadamente valores nulos para mantener la calidad de tus datos; elimina aquellas filas con pocas incidencias nulas para mejorar tu análisis.

¿Qué son y cómo funcionan Bag of Words y TF-IDF para la representación numérica del texto?

Ahora es esencial convertir tus reseñas procesadas en vectores numéricos utilizando técnicas de representación textual como Bag of Words y TF-IDF:

¿Qué es Bag of Words (BoW)?

El método Bag of Words convierte cada fila de texto (documento) en un vector numérico basado en la frecuencia de aparición de cada palabra. Sus características son:

- Cuenta la frecuencia de cada palabra ignorando el orden lingüístico.

- Genera vectores donde cada palabra única es una dimensión.

¿Cuál es la función y ventaja del método TF-IDF?

TF-IDF (Term Frequency-Inverse Document Frequency) es una mejora sobre BoW, y se utiliza para identificar palabras relevantes al compensar palabras muy comunes:

- Calcula la frecuencia (term frequency, TF) en combinación con el peso inverso de la frecuencia del documento (Inverse Document Frequency, IDF).

- Da preferencia informativa a palabras menos comunes pero más relevantes.

Ambos métodos pueden implementarse fácilmente con la librería de scikit-learn (sklearn), y permiten representar numéricamente y eficientemente el texto para su posterior clasificación.

¿Has experimentado antes con estos métodos de representación de texto? Cuéntanos tus experiencias o dudas en los comentarios.