Integración de LLM para optimizar respuestas en Jupyter Notebook

Clase 13 de 22 • Curso de RAG con Microsoft Azure

Contenido del curso

Etapas de RAG

- 5

Embeddings y bases de datos vectoriales para documentos digitales

03:35 min - 6

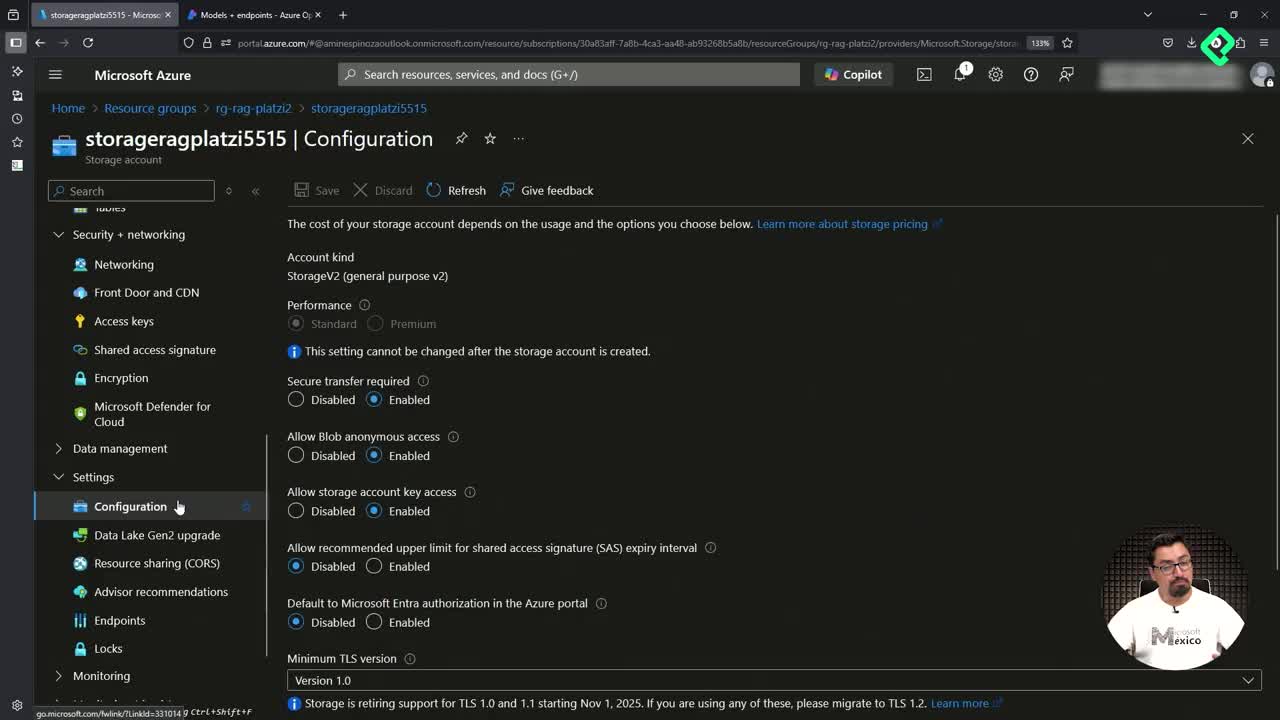

Configuración de Azure para RAG: preparativos y gestión de costos

03:51 min - 7

Qué son las bases de datos vectoriales y sus aplicaciones

04:50 min - 8

Despliegue de recursos de IA en Azure con scripts de Bash

05:15 min - 9

Despliegue de modelos GPT-4 y embeddings en Azure OpenAI

03:01 min - 10

Configuración de Jupyter Notebook y ambientes virtuales en Python

03:37 min

Tecnicas de RAG

- 11

Vectorización de documentos con Azure Search y OpenAI

06:15 min - 12

Configuración de Azure OpenAI y AI Search en Jupyter Notebook

06:56 min - 13

Integración de LLM para optimizar respuestas en Jupyter Notebook

Viendo ahora - 14

Actualización manual de índices con nuevos documentos PDF

03:17 min - 15

Búsqueda tradicional, vectorial e híbrida en Azure AI Search

06:05 min

RAG avanzado

- 16

Creación de múltiples índices en Azure AI Search con Jupyter

09:40 min - 17

Generación de información ficticia con archivos Parquet

03:14 min - 18

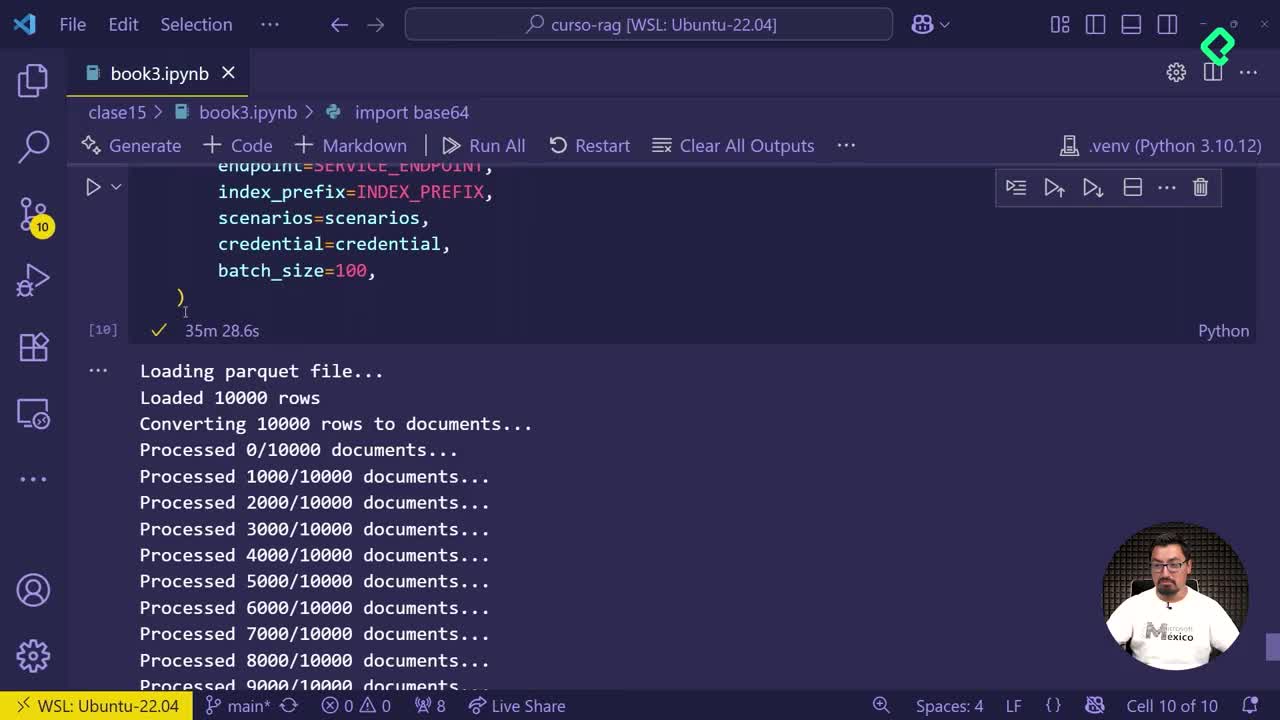

Subida automática de documentos fragmentados a Azure AI Search

02:53 min - 19

Comparación de índices en Azure para optimizar almacenamiento

03:59 min - 20

Creación de aplicación demo con Azure Search Service

03:39 min

Fusionando RAG con un agente

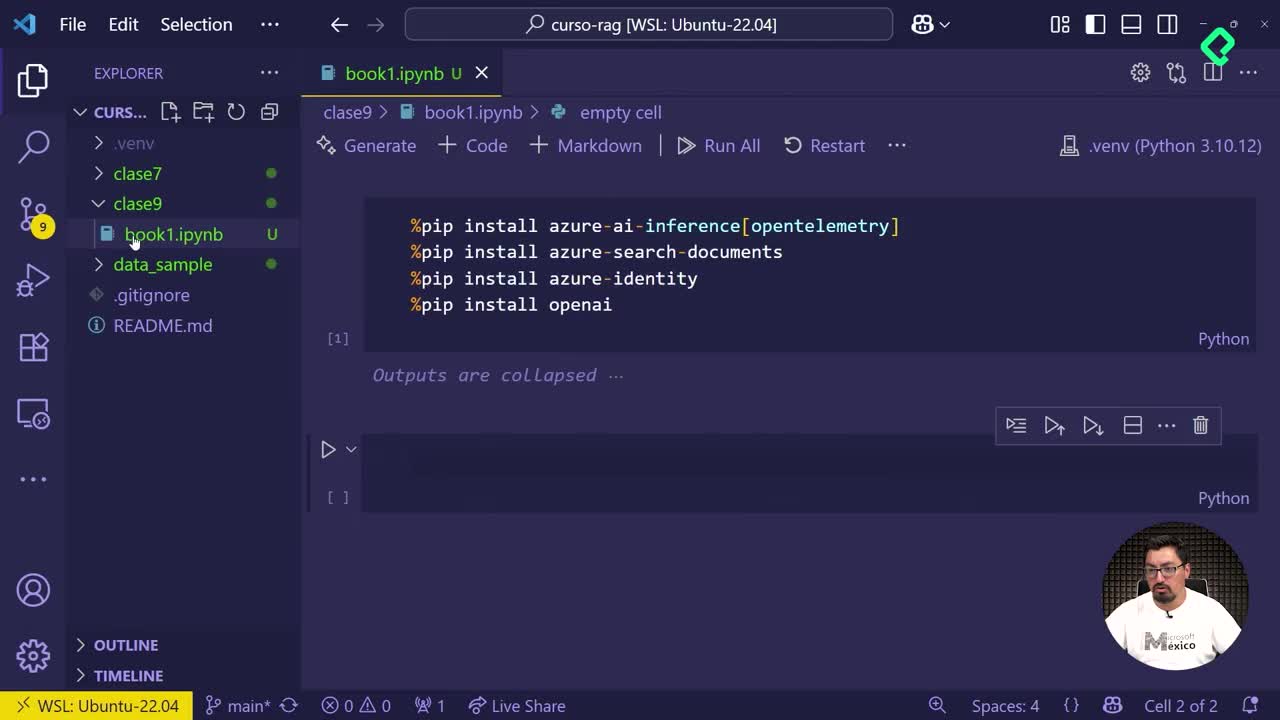

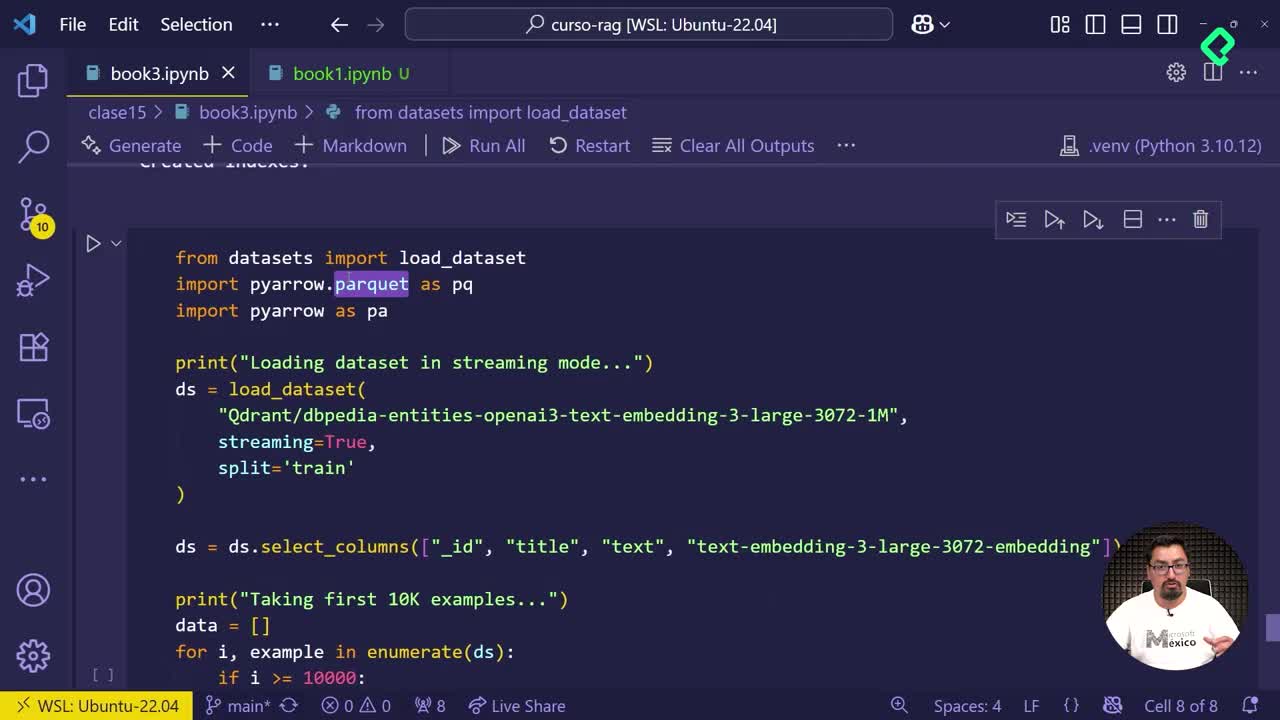

La integración del LLM (Large Language Model) en Jupyter Notebook optimiza la interpretación de datos vectorizados e indexados. Con esta técnica, pasamos de enormes cantidades de información numérica y textual a respuestas precisas que satisfacen necesidades específicas del usuario.

¿Qué beneficios ofrece integrar un LLM en proyectos con Jupyter Notebook?

Los modelos LLM permiten transformar grandes volúmenes de datos complejos en respuestas breves y relevantes. Al combinar embeddings de información obtenida previamente con el modelo GPT_-4_ de OpenAI, logramos eficiencia al ofrecer respuestas cortas sin necesidad de revisar manualmente toda la información original.

¿Cómo funciona la aplicación del LLM en este contexto?

El proceso sigue estos pasos cruciales:

- Desplegar dos modelos, uno dedicado a crear embeddings numéricos y otro específico para generar texto.

- Crear un contexto que guía al modelo para mezclar resultados obtenidos previamente junto con instrucciones claras como generar respuestas breves y directas.

- Utilizar el cliente de OpenAI con la funcionalidad de chat completion para resumir e interpretar la información.

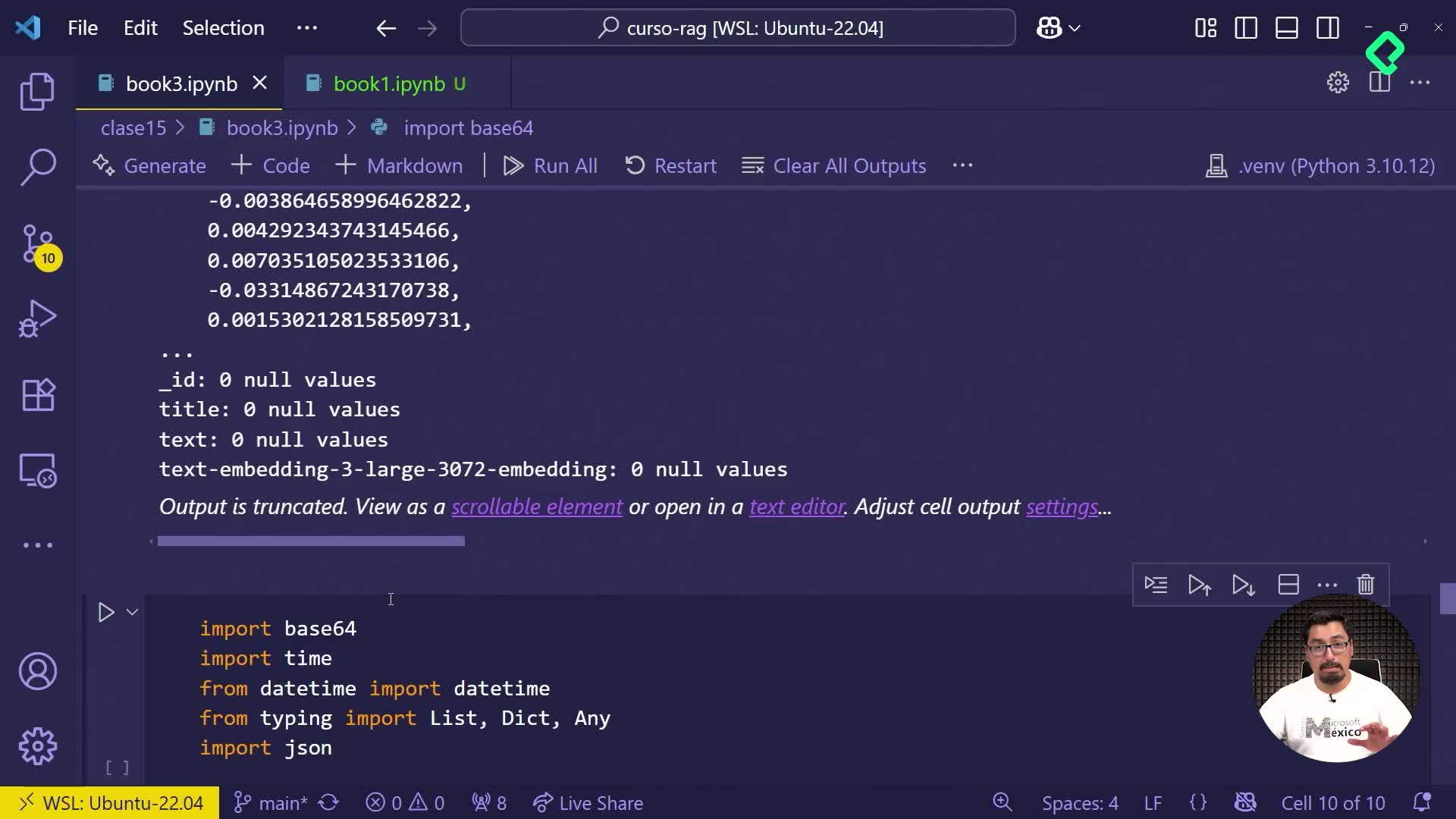

¿Qué es chat completion y cuál es su configuración?

Esta técnica permite al agente virtual:

- Interpretar preguntas específicas del usuario.

- Utilizar datos vectorizados y textuales como referencia para respuestas.

- Generar resultados breves y relevantes gracias a parámetros como temperatura y prompt configurado previamente.

Los resultados aparecen en mensajes concisos que evitan la revisión innecesaria de gran cantidad de texto, mostrando claramente lo realmente importante desde el punto de vista humano.

Te invito a compartir tu experiencia y dudas respecto a la implementación de modelos LLM en tus proyectos con Jupyter Notebook.