Crear videos con inteligencia artificial ya no es un misterio: con un flujo claro, herramientas correctas y prompts bien escritos, puedes producir tutoriales, comerciales, avatars o contenidos virales con alta calidad. Aquí encontrarás un método práctico en 5 pasos, comparativas reales entre modelos como Veo 3.1 y Sora 2, y trucos de postproducción que elevan el resultado final.

¿Cómo diseñar el flujo de creación con IA?

Empezar por el concepto evita gastos y retrabajo. Define el formato, el objetivo y el destino del contenido antes de abrir cualquier herramienta.

¿Qué formato y plataforma objetivo?

- Define si harás tutoriales, comerciales, blogs, avatars o versus comparativos de herramientas.

- Elige si necesitas video con audio o solo imagen en movimiento.

- Decide la plataforma: YouTube (horizontal), Instagram y TikTok (vertical), Shorts de YouTube, LinkedIn.

- Verifica si el modelo permite vertical u horizontal para no limitarte después.

¿Qué recursos y prompts necesitas?

- Reúne imágenes de referencia, fotografías de producto y capturas propias.

- Usa LLMs (ChatGPT, Gemini) para co-crear prompts o crear GPTs/gems que los generen por ti.

- Considera limitaciones: contenido sensible y personas famosas en Gemini/ChatGPT; Grok es más permisivo con figuras públicas.

- Documenta tus mejores prompts y el número de seed para replicar estética y estilo.

- Construye una biblioteca de referentes visuales; incluso errores pueden servir como B-roll.

¿Qué modos de trabajo usar?

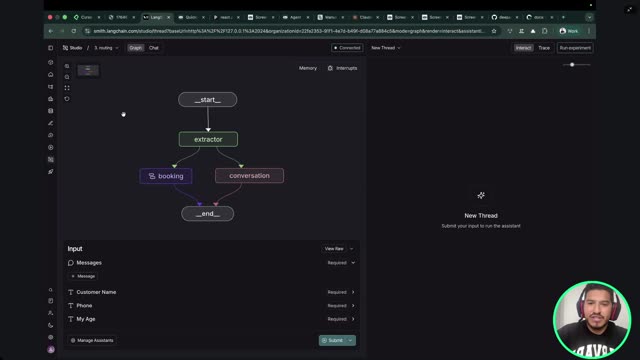

- Text to video: del prompt al video, con o sin audio.

- Image to video: animas un first frame estático (ideal para personajes o productos).

- Video to video: avatar/deepfake o estilización (blanco y negro, anime, etc.).

- Sketch to video y elements: boceto/storyboard con acciones; combinación de personaje, locación y producto.

¿Qué herramientas elegir según el proyecto?

Selecciona conforme al caso de uso: consistencia, audio integrado, restricciones y costos de créditos. Evita pagar de más probando primero las versiones gratuitas.

¿Cuándo usar Veo 3.1, Sora 2, ONE/Kling, Runway o HitFilm?

- Veo 3.1 (Google): muy consistente y con buenas primeras tomas. Tiene opción rápida para gastar menos créditos.

- Sora 2 (OpenAI): alta calidad y audio, pero solo permite cambios autorizados. Con cameos mantiene continuidad del personaje.

- ONE 2.5/2.6 y Kling 2.5/2.6: video y audio sin la restricción humana de Sora. Algunas variantes limitan el aspect ratio o solo horizontal.

- Minimax: buen resultado, pero sin audio.

- Runway: ideal para estilización, avatars y deepfakes. Más económico y con suficientes créditos para un proyecto viable.

- Hixfield/Hixfilm: hub de modelos y apps integradas: Relight (iluminación), Face Swap, Topaz (reescalado), Cinema Studio, lip sync. En imágenes: Nano Banana, Seadream, ChatGPT Image, Flux. Se actualiza rápido.

¿Qué ofrece Hixfield en precios y uso?

- Plan Basic aprox. 9 dólares con ~150 créditos.

- Nano Banana Pro ilimitado y modo “sin censura” para mayor libertad creativa.

- Actualización prorrateada: si subes a Pro a mitad de mes, pagas la diferencia (~8 dólares).

- Pago anual más barato que mensual. También permite pruebas con créditos iniciales.

¿Cómo mejorar audio y voces con IA?

- Adobe Podcast (Enhance Audio) para limpiar grabaciones no profesionales. El audio es el 50 % del resultado.

- Eleven Labs para clonar voz, crear acentos y hacer voice over o doblajes. Tiene versión gratuita para pruebas.

¿Cómo ejecutar, iterar, editar y publicar?

La clave está en iterar: pocas veces el primer render es el final. Ajusta prompts, controla duración y cuida el audio.

¿Cómo iterar hasta lograr el resultado?

- Ejecuta el prompt, revisa y anota desajustes.

- Modifica prompt e inputs (imágenes, audio) y regenera.

- Documenta prompts y seeds efectivos para reutilizar estilo.

- Usa resultados fallidos como B-roll.

- Controla duración/estilo/seed: impactan créditos y consistencia.

¿Cómo fue el caso del pódcast de perros y el avatar?

- Podcast de perros: foto del perro + referencia de Instagram + diálogo; con image to video logró >50 mil seguidores y marcas interesadas en anuncios.

- Avatar tipo Vecna: foto del personaje + foto/video propio; en Hixfield (modelo 1 2.2, Animate) se generó avatar con lip sync y posible cambio de voz.

- ASMR navideño con monito: first frame en Nano Banana + prompt con “close up”, acciones, diálogo en español, acento mexicano y lip sync. Comparativa: Veo 3.1 dio el mejor primer resultado; 1 2.5 requirió dos intentos; Sora 2 necesitó más iteraciones.

¿Cómo postproducir y publicar en cada plataforma?

- Descarga, organiza y edita. Ajusta color cuando mezclas transiciones IA con material original.

- Mejora el audio y exporta.

- Publica según formato: YouTube horizontal; Instagram, TikTok y Shorts vertical; LinkedIn acepta ambos.

- CapCut o editores nativos ayudan a pegar clips. Veo ofrece edición y unión de clips.

- Si necesitas escala, usa APIs y automatización con N8N (por ejemplo, con Veo 3.1).

¿Te quedó alguna duda o quieres compartir tu flujo favorito, herramientas o automatizaciones con N8N? Escribe tus preguntas y ejemplos para retroalimentar a la comunidad.