La creación de agentes avanzados exige patrones claros, control de costos y orquestación confiable. Aquí encontrarás cómo LangGraph, LangChain y la librería Deep Agents simplifican arquitecturas complejas con loop ReAct, multimodelo y técnicas de context engineering para tareas de minutos u horas, sin perder foco ni presupuesto.

¿Por qué los patrones de agentes importan en LangGraph y LangChain?

Diseñar agentes hoy es diseñar arquitecturas. Con LangGraph puedes modelar routing, chaining, parallelization, orchestrator y evaluator. La clave: escoger el patrón correcto y, cuando conviene, usar implementaciones ya probadas que ahorran tiempo y errores.

¿Qué es el patrón chaining y cuándo usarlo?

- Encadena pasos: la salida de un agente es la entrada del siguiente.

- Ejemplo práctico: generar un post en Twitter, crear una imagen y producir un pódcast con ese material.

- Ideal para flujos lineales y controlados.

- Recomendado cuando cada etapa agrega valor concreto.

¿Cómo funciona un ReAct agent y su loop?

- El ReAct Agent combina tools y observaciones en un loop hasta cumplir el objetivo.

- Pide más datos si faltan para completar la tarea.

- En LangChain, createAgent ya configura un reactAgent sin armar el grafo a mano.

- Caso visto: saludo simple sin tools; consulta de productos dispara la tool de API y lista resultados en tiempo real.

- Ventaja: sencillez y eficacia en la mayoría de casos.

- Límite: en tareas largas puede quedarse corto.

¿Qué ventajas trae la arquitectura multimodelo?

- Usa el modelo óptimo según tarea: uno mejor para tools y otro para redacción.

- Equilibra calidad y costos: combina opciones open source y modelos de pago.

- Escenarios típicos: Mistral o Lama para texto; Gemini, Anthropic u otros para thinking y tareas complejas.

¿Qué resuelven los Deep Agents en tareas largas?

Cuando un agente trabaja 30, 60 minutos o más, el historial se vuelve caro y difuso. Deep Agents incorporan cuatro pilares: planning tool, subagents, system prompt y file system. Así mantienen foco, persisten el plan y evitan inflar la ventana de contexto.

¿Cómo operan el file system y los store backends?

- El file system guarda entradas, planes y resultados como archivos planos.

- Beneficio: no sobrecarga la ventana de contexto del language model.

- Lectura bajo demanda: si se necesita un resultado, se abre el archivo específico (por ejemplo, response.md).

- Store backends: persistencia escalable en base de datos o S3 sin depender de un disco local.

¿Qué papel juegan planning tool y to-do list?

- El planning tool crea un plan en un to-do list (p. ej., Markdown) y lo actualiza.

- Mantiene el propósito inicial visible para evitar desvíos en procesos largos.

- Inspiración de ingeniería: prácticas de Manus (adquirida por Meta) y Cloud Code con planes persistidos.

- Beneficio clave: alineación continua del agente a su objetivo.

¿Cómo orquestan subagents y reducen costos de tokens?

- Los subagents tienen su propio system prompt y contexto. Ejecutan partes especializadas del plan.

- La librería ya trae orquestación por defecto: decide qué subagent activar sin que armes el patrón a mano.

- Estrategias de context engineering:

- Mover salidas de tools a archivos en lugar de dejarlas en el historial.

- Cargar solo lo necesario según la consulta.

- Aplicar summarization dinámico cuando los tokens superan un umbral.

- Resultado: mejor performance y menos costo por tokens.

¿Cómo empezar, monitorear y pagar por estos agentes?

Configurar un reactAgent o un Deep Agent puede ser tan simple como una llamada: createAgent o create-deep-agent. Luego eliges tools, defines el system prompt y, si aplica, declaras subagents y almacenamiento.

¿Qué pasos dar para crear y deployar un deep agent?

- Importar la librería Deep Agents en Python o TypeScript.

- Crear el agente con su system prompt y tools.

- Definir subagents y el file system con su backend.

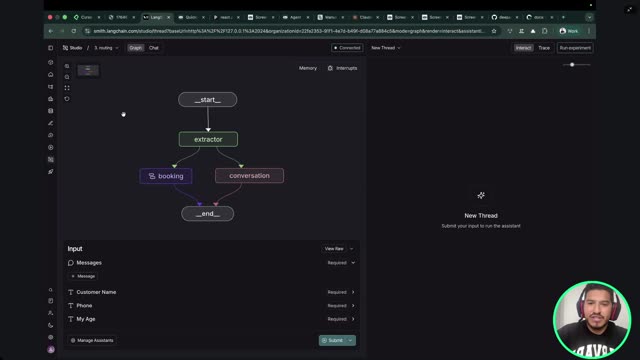

- Probar en local con el monitoreo gráfico de LangChain/LangGraph.

- Deployar como API con FastAPI para uso en producción.

- Ajustar middleware de summarization y limpieza de historial.

¿Cómo medir observabilidad, costos y tokens?

- Usar trazas para ver cuántos tokens consume cada paso.

- Monitorear llamadas a Internet y tools dentro del grafo.

- Evaluar costo por proveedor: ejemplo mencionado, Anthropic cobra por tokens.

- Optimizar con reglas de summarization y carga selectiva de contexto.

- Objetivo: resultado óptimo sin gastos innecesarios.

¿Qué herramientas pagas y ecosistemas se usan a diario?

- Desarrollo: Cursor y GitHub Copilot para code review y asistencia.

- Redacción e investigación: Gemini y su integración en Google Workspace (Notebook LM, Google Docs, Google Slides, creación de slides con Nano Banana).

- Consumo por tokens: Anthropic con billetera prepagada.

- Ecosistema Microsoft: integrar con Microsoft 365 Copilot y considerar Semantic Kernel para agentes en su stack.

- Nota práctica: elegir ReAct para casos simples y Deep Agents para procesos largos. Evitar sobreingeniería.

¿Te quedaste con dudas o tienes un caso de uso específico? Cuéntalo en los comentarios y conversemos cómo ajustar patrones, tools y contexto a tu escenario.