Comprende con claridad qué es la inteligencia artificial y cómo operan los LLMs: desde espacios n-dimensionales y el perceptrón hasta la atención con queries, keys y values. Con una ruta de estudio enfocada en álgebra lineal, cálculo, probabilidad y estadística, podrás usar mejor los modelos y, sobre todo, construirlos para avanzar hacia la soberanía tecnológica.

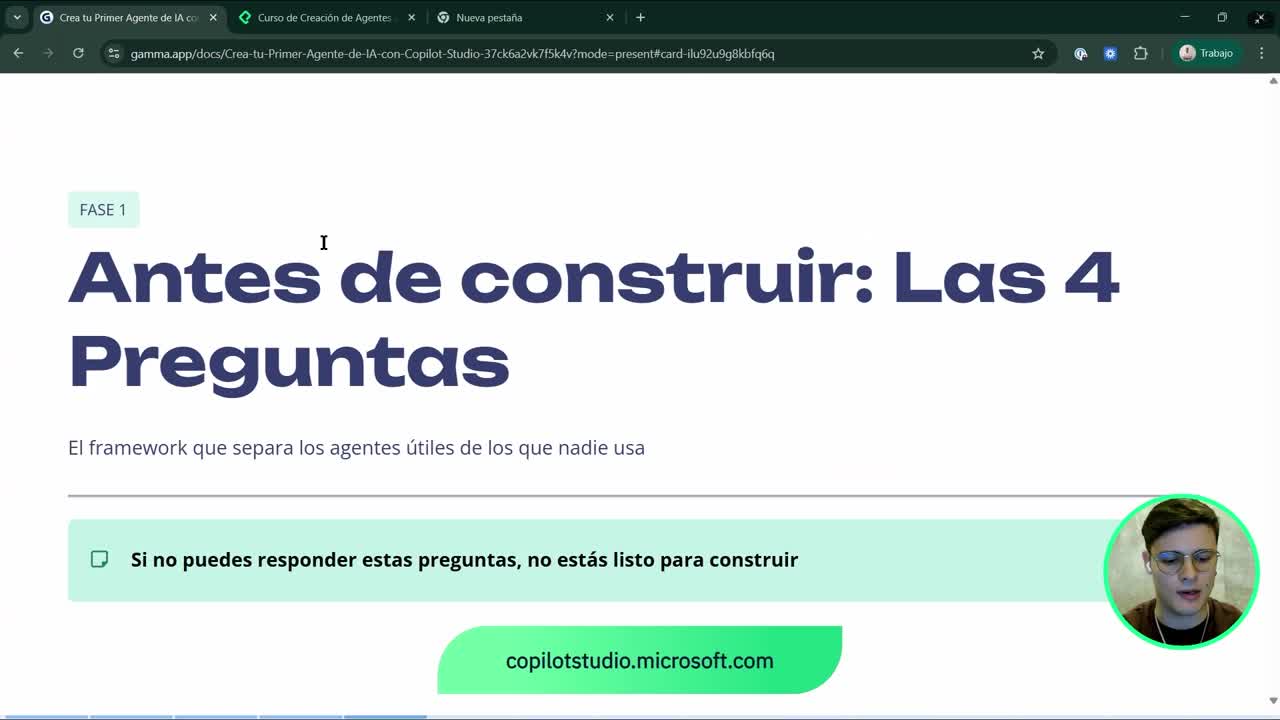

¿Por qué la inteligencia artificial importa hoy?

La IA no es solo hype: está transformando el trabajo y la interacción con Internet, incluso ya integrada en celulares. No es un fenómeno reciente; desde la máquina de Babbage y Ada Lovelace y las intuiciones de Leibniz sobre “calcular” ideas, la ambición ha sido modelar procesos mentales con matemáticas.

- IA no es igual a LLM: IA > machine learning > deep learning > supervised y unsupervised; los LLMs viven en la intersección de ambos.

- Dos caminos: usar modelos con criterio o entenderlos por dentro para construirlos.

- Soberanía tecnológica: conocer matemáticas y arquitectura permite crear modelos y, con infraestructura como data centers, ser dueños de la tecnología que se usa.

¿Qué es IA, machine learning y LLM?

- IA es el conjunto mayor de algoritmos.

- Machine learning y deep learning son subconjuntos.

- Los LLMs son un tipo específico dentro de deep learning con aprendizaje supervisado y no supervisado.

- Hay otras ramas como reinforcement learning con enfoques distintos.

¿Qué ruta de aprendizaje acelera tu soberanía tecnológica?

- Álgebra lineal: matrices y operaciones como Gauss-Jordan.

- Cálculo diferencial e integral: derivadas, gradientes y áreas bajo curvas.

- Probabilidad y estadística: Bayes, esperanza y razonamiento con datos.

- Lectura disciplinada de libros y cursos, con constancia y repetición.

¿Cómo aprovechar mejor los LLMs con lenguaje y prompts?

- El lenguaje refleja la mente, como recuerda Chomsky.

- Un prompt con vocabulario del dominio mejora resultados.

- Evita muletillas y “filling words” que no agregan información.

¿Cómo funcionan los LLMs por dentro?

La intuición inicia en espacios n-dimensionales: como una hoja de cálculo, pero con muchas dimensiones. Los LLMs llevan el lenguaje a vectores donde palabras relacionadas quedan “cerca” (por ejemplo, “papá” y “mamá”).

¿Qué es un espacio n-dimensional y un perceptrón?

- Un dato puede tener múltiples dimensiones; el lenguaje se embebe en ese espacio.

- El perceptrón es la neurona artificial: entradas x1…xn, pesos w que almacenan el conocimiento y una salida.

- Las redes apilan capas (layers) de perceptrones y operan con matrices.

- Tokenización: “papá” es un token; “papás” separa “papá” + “s”.

¿Cómo aprenden: pérdida, derivadas y stochastic gradient descent?

- Se define una función de pérdida que mide el error entre salida y dato real.

- Con derivadas se calcula la pendiente para moverse hacia errores menores (negativo del gradiente).

- En alta dimensión, el Stochastic Gradient Descent (SGD) hace el proceso eficiente; aparece el gradiente y conceptos como la hessiana.

- El entrenamiento actualiza los pesos W iterativamente capa por capa.

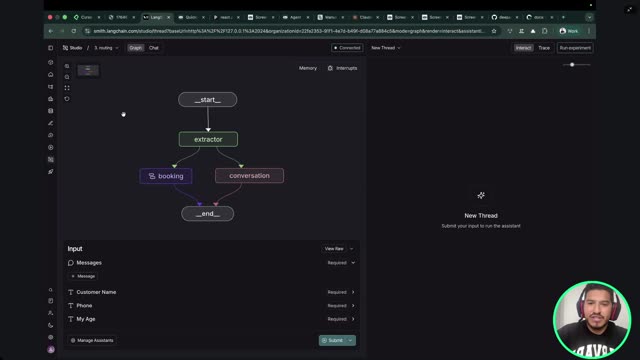

¿Qué resuelve la atención con queries, keys, values y softmax?

- Antes, las RNN/LSTM limitaban el contexto (≈ 64² tokens); la atención permitió escalar el contexto masivo.

- El modelo formula queries (qué preguntar), compara con keys (pistas relevantes) y combina con values (contenido) para enfocar lo útil.

- Softmax normaliza puntajes y, junto con la división por √dk, mejora la estabilidad numérica.

- La transpuesta en Kᵀ y la dimensión dk son nociones de álgebra lineal.

- En la arquitectura, el bloque feedforward es un “perceptrón gigante” repetido en cada capa.

¿Qué matemáticas y probabilidades necesitas dominar?

Los modelos generan la siguiente palabra como la más probable; por eso pueden errar y deben verificarse. Para construir criterio, la probabilidad y la estadística son clave.

¿Cómo te ayudan álgebra lineal y cálculo en modelos?

- Álgebra lineal: matrices, vectores, transpuestas y descomposiciones.

- Cálculo: gradientes para optimizar la pérdida y navegar “valles” de error.

- Integral: otras tareas complementarias del análisis continuo.

¿Por qué probabilidad, Bayes y estadística guían las respuestas?

- Probabilidad simple: eventos equiprobables como una moneda.

- Bayes: manejar eventos complejos encadenados (carga del móvil, Internet, servicio activo, receptor disponible).

- Esperanza: promedio ponderado de resultados posibles cuando la distribución no es conocida con certeza.

- Estadística: inferir comportamientos cuando la probabilidad no es conocida y se necesitan muchos datos.

¿Qué arquitectura y recursos prácticos se mencionan?

- Arquitectura LLM: bloques de atención, feedforward y normalizaciones.

- La capa de salida aplica SoftMax para mapear a probabilidades entre 0 y 1.

- Benchmarks en Artificial Analysis para comparar modelos por “inteligencia”, velocidad y precio.

- Lectura técnica asistida con herramientas que integran IA a papers, y hábito de estudio con libros y notas.

¿Te gustaría que profundicemos en atención, prompts o matemáticas aplicadas? Deja tus preguntas y casos de uso en los comentarios.