Los agentes de inteligencia artificial están cambiando la búsqueda en la web y en aplicaciones: pasamos de keywords y full text search a chatbots que responden en lenguaje natural, y de ahí a RAG y agentes capaces de recordar, decidir y actuar. Aquí verás qué es un agente basado en LLM, cuándo usar simple prompting, RAG o un agente completo, y qué implicaciones tienen en costo, latencia y determinismo, con el ejemplo del buscador en la knowledge base de MongoDB.

¿Qué es un agente de AI y por qué usarlo?

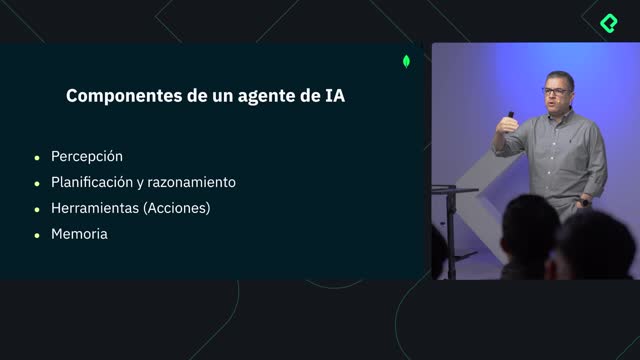

Un agente de inteligencia artificial es un sistema que usa un LLM para razonar, planificar y ejecutar pasos hasta resolver un problema. Itera sobre resultados, toma decisiones y puede incorporar memoria para personalización con el tiempo.

- Usa un LLM para crear un plan y descomponer tareas.

- Ejecuta acciones con herramientas externas como API, bases de datos u otros agentes.

- Itera sobre resultados para elegir el siguiente paso.

- Aprovecha historial y contexto para personalización sostenida.

¿Qué herramientas utiliza un agente?

Las herramientas son la conexión del modelo con el exterior. Permiten acceder y actuar sobre datos y servicios.

- API de servicios o aplicaciones.

- Bases de datos para consultar o actualizar información.

- Otros agentes que especializan subtareas.

¿Cómo toman decisiones los agentes?

El agente razona con la respuesta de cada herramienta y decide la próxima acción.

- Pedir más información si el contexto es insuficiente.

- Cambiar de herramienta para obtener datos distintos.

- Finalizar cuando ya hay una solución adecuada.

¿Cómo se comparan simple prompting, RAG y agentes?

Existen tres paradigmas para interactuar con modelos de lenguaje: simple prompting, RAG y agentes. Elegir bien depende de la complejidad de la tarea y de la necesidad de personalización o de acciones externas.

¿Qué implica simple prompting?

Es interactuar con el LLM con una pregunta directa usando solo su información paramétrica.

- Responde con el conocimiento del entrenamiento.

- Si falta información, puede incurrir en alucinaciones confiadas.

- No refina con sus propias salidas.

- Carece de personalización y de procesos de múltiples pasos.

¿Para qué sirve RAG?

La generación aumentada por recuperación combina el LLM con tu información propietaria para respuestas más precisas.

- Usa tu corpus para brindar precisión y contexto relevante.

- Permite cierta personalización al controlar las fuentes.

- Ideal para preguntas y respuestas en entornos corporativos.

- No ejecuta flujos complejos ni decide a partir de sus salidas.

Ejemplo aplicado: el buscador de la knowledge base de MongoDB funciona como una aplicación RAG que responde en lenguaje natural.

¿Cuándo dar el salto a agentes?

Cuando necesitas coordinación de varios pasos, decisiones dinámicas y acciones sobre sistemas externos.

- Consultas complejas que requieren múltiples herramientas.

- Interacciones con terceros o sistemas externos.

- Uso de memoria e historial para refinar y personalizar a lo largo del tiempo.

¿Qué limitaciones y consideraciones hay al implementar agentes?

Los agentes son flexibles y resolutivos, pero su arquitectura añade retos técnicos y operativos que debes anticipar.

- Mayor costo: múltiples llamadas, incluso a diferentes LLM.

- Mayor latencia: iteraciones y acceso a herramientas.

- Más complejidad: diseño, orquestación y mantenimiento.

- Resultados no determinísticos: con las mismas entradas no siempre obtendrás la misma respuesta por la naturaleza probabilística de los LLM.

- Requieren acceso a herramientas adecuadas para cubrir el alcance de las tareas.

¿En qué situaciones te planteas pasar de RAG a agentes con memoria y decisiones? Comparte tus ideas y preguntas en los comentarios.