Imagina pasar de respuestas básicas a decisiones útiles. Con agentes de AI que “piensan antes de actuar”, dejas atrás al chatbot que solo contesta y obtienes un sistema que razona, planifica y ejecuta tareas de múltiples pasos. Aquí verás cómo percepción, planificación con LLMs, herramientas, memoria y embeddings se combinan con MongoDB y LangGraph para crear experiencias realmente inteligentes.

¿Qué diferencia a un agente de AI de un chatbot?

Un chatbot tradicional responde con lo que ya tiene preentrenado. Un agente de AI va más allá: analiza contexto, propone cambios y actúa. Por ejemplo, no solo dice el clima: revisa tu calendario, sugiere ajustes y reserva si lloverá. La clave es que el agente razona, planifica y ejecuta con pasos encadenados.

- Respuesta simple vs. acción informada.

- Información estática vs. razonamiento dinámico.

- Interacción pasiva vs. orquestación de tareas.

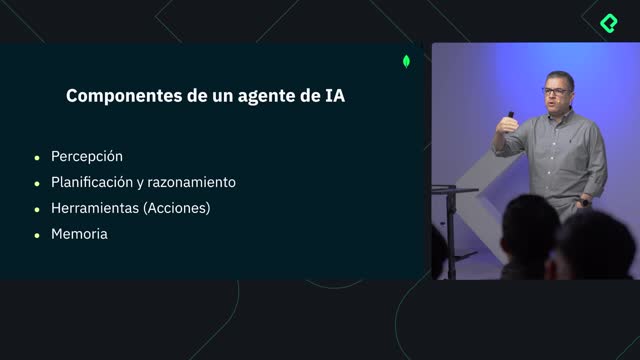

¿Cuáles son los componentes esenciales del agente?

Para operar de forma confiable, el agente combina cuatro piezas: percepción, planificación, herramientas y memoria. Juntas permiten capturar información, diseñar pasos, actuar en sistemas externos y aprender continuamente.

¿Qué papel cumplen percepción y planificación con LLMs?

La percepción toma señales del entorno: texto, calendarios o consultas. La planificación usa LLMs como “cerebro central” para decidir qué hacer primero, después y cómo manejar excepciones. Así, el sistema transforma intención en secuencias de acciones.

- Percepción: captura y estructura entradas relevantes.

- Planificación con LLMs: descompone problemas y prioriza pasos.

- Ejecución: coordina llamadas a herramientas según el plan.

¿Cómo funcionan los embeddings y el espacio vectorial?

Los embeddings convierten palabras en números que capturan significado. Así, “automóvil” y “carro” quedan cerca en el espacio vectorial porque significan lo mismo, aunque se escriban diferente. Esto permite búsquedas por intención, no solo por coincidencia exacta.

- Representación semántica con vectores.

- Cercanía = similitud de significado.

- Consultas que entienden sinónimos y contexto.

¿Cómo se orquesta con LangGraph y se potencia con MongoDB?

Para coordinar todo, usamos LangGraph como mapa mental que organiza percepción, herramientas y memoria. Y con MongoDB, los embeddings se integran directamente en documentos, habilitando consultas semánticas eficientes.

¿Qué aporta MongoDB con consultas semánticas?

Mientras otros motores buscan coincidencias exactas, con MongoDB consultas por intención y significado devuelven resultados más útiles. Al almacenar embeddings en los documentos, el agente recupera contexto que se alinea con lo que el usuario realmente quiso decir.

- Embeddings persistidos junto a los datos.

- Búsqueda semántica unificada con el contenido.

- Resultados relevantes sin depender de palabras exactas.

¿Cómo coordina LangGraph la ejecución?

LangGraph orquesta el flujo como un cerebro operativo: decide cuándo percibir, qué herramienta invocar y qué memoria consultar o actualizar. El resultado es un agente que entiende lenguaje natural, busca información, razona sobre el problema y mejora con cada interacción.

- Orquestación de pasos y manejo de estado.

- Integración de herramientas externas de acción.

- Memoria que aprende y se actualiza en cada ciclo.

¿Qué obtendrás al finalizar?

Tendrás un sistema con estas capacidades clave:

- Comprensión de lenguaje natural para interpretar intención.

- Búsqueda automática de información relevante.

- Razonamiento y planificación de múltiples pasos con LLMs.

- Ejecución con herramientas y memoria que aprende.

- Consultas semánticas sobre datos en MongoDB.

¿Te gustaría aplicar esto a un caso real de tu negocio o proyecto? Comparte tu objetivo en los comentarios y cuéntanos qué agente te gustaría construir.