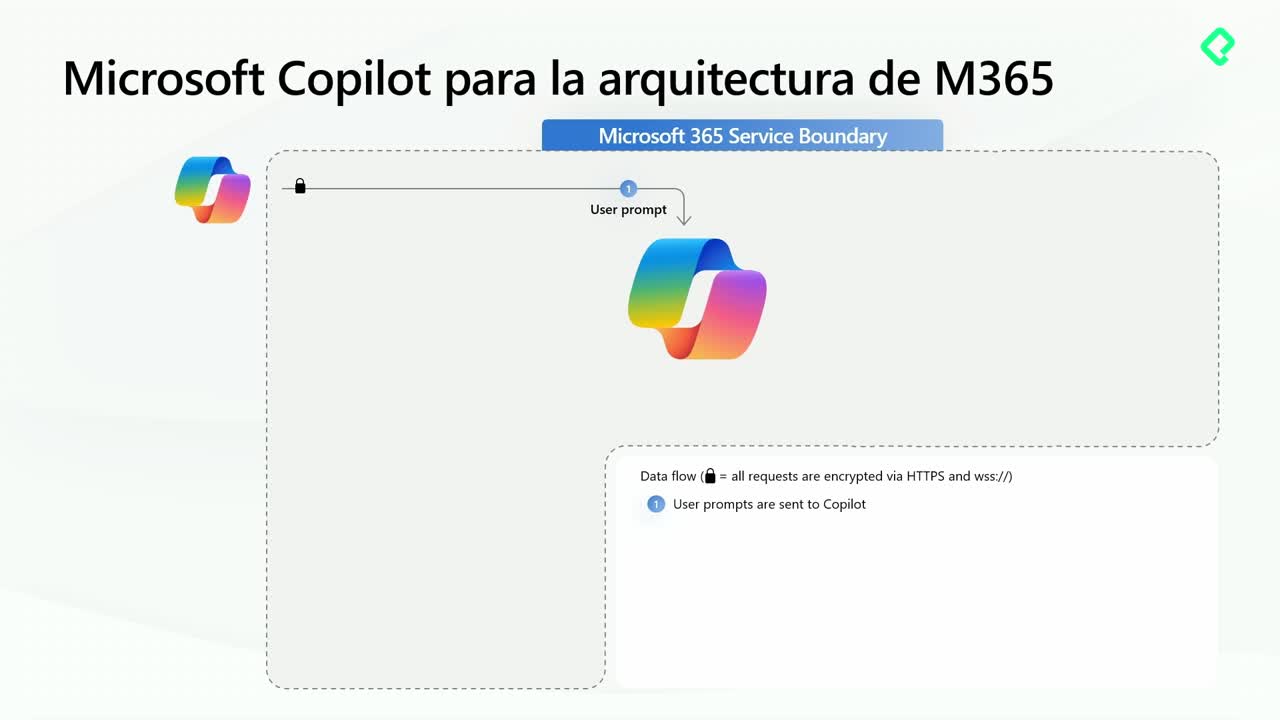

La seguridad de la IA empieza por los datos. Bajo un enfoque Zero Trust, el acceso se verifica en cada paso y se limita al mínimo necesario. Así, un agente solo “ve” lo que tu identidad y tus permisos permiten. Si no abres la puerta, la IA no entra. Este marco, sumado a inteligencia artificial responsable, reduce riesgos como fuga de datos, intercambio excesivo y uso fuera de cumplimiento.

¿Cómo aplica Zero Trust a la IA y a tus datos?

El modelo Zero Trust sostiene tres pilares que definen quién accede, desde qué dispositivo y en qué condiciones. La IA actúa como tu “gafete”: consulta solo fuentes a las que ya tienes permiso.

¿Cuáles son los pilares zero trust?

- Verificación explícita: identidad, dispositivo y aplicaciones se validan en cada solicitud.

- Menor privilegio: se otorgan solo los permisos estrictamente necesarios.

- Asumir brecha: se monitorea y se está listo para responder ante incidentes.

¿Qué compromisos hace Microsoft con tus datos?

- Tus datos son tuyos: Microsoft no toma posesión ni los usa para entrenar modelos.

- Privacidad y seguridad: empleados no acceden a datos del cliente; se respetan controles de cumplimiento existentes.

- IA responsable: equidad, confiabilidad, seguridad, privacidad, inclusión, transparencia y accountability contractual.

¿Cómo funciona el acceso condicional?

- Riesgo por contexto: ubicación, dispositivo y patrones de inicio de sesión determinan acceso.

- Protección en la nube: un proxy inspecciona cargas y descargas en aplicaciones SaaS.

- Cobertura híbrida: controles para Azure y entornos on‑premises con correlación de señales de seguridad.

¿Qué riesgos de seguridad y cumplimiento enfrentan los agentes de IA?

Los agentes heredan riesgos clásicos y abren nuevas superficies de ataque. El primer paso siempre es asegurar las fuentes de datos antes de activar agentes.

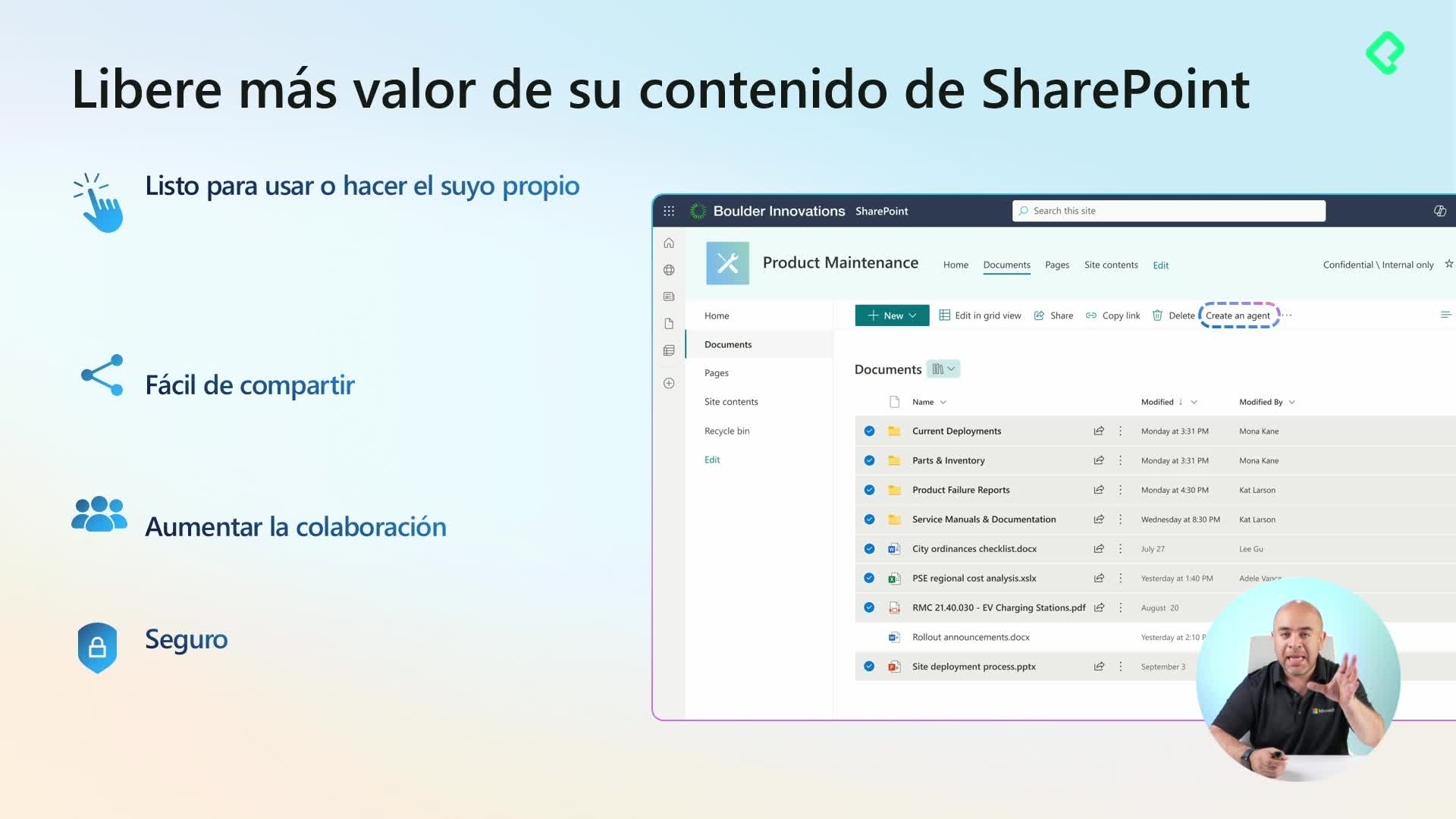

¿Por qué ocurre el intercambio excesivo en SharePoint?

- Privacidad del sitio: etiquetas y configuración impactan cómo se comparte el contenido.

- Permisos predeterminados: una administración laxa amplía accesos innecesarios.

- Dominio “todos, excepto externos”: atajos para compartir terminan exponiendo datos.

- Falta de etiquetado y cifrado: documentos sensibles sin protección adecuada.

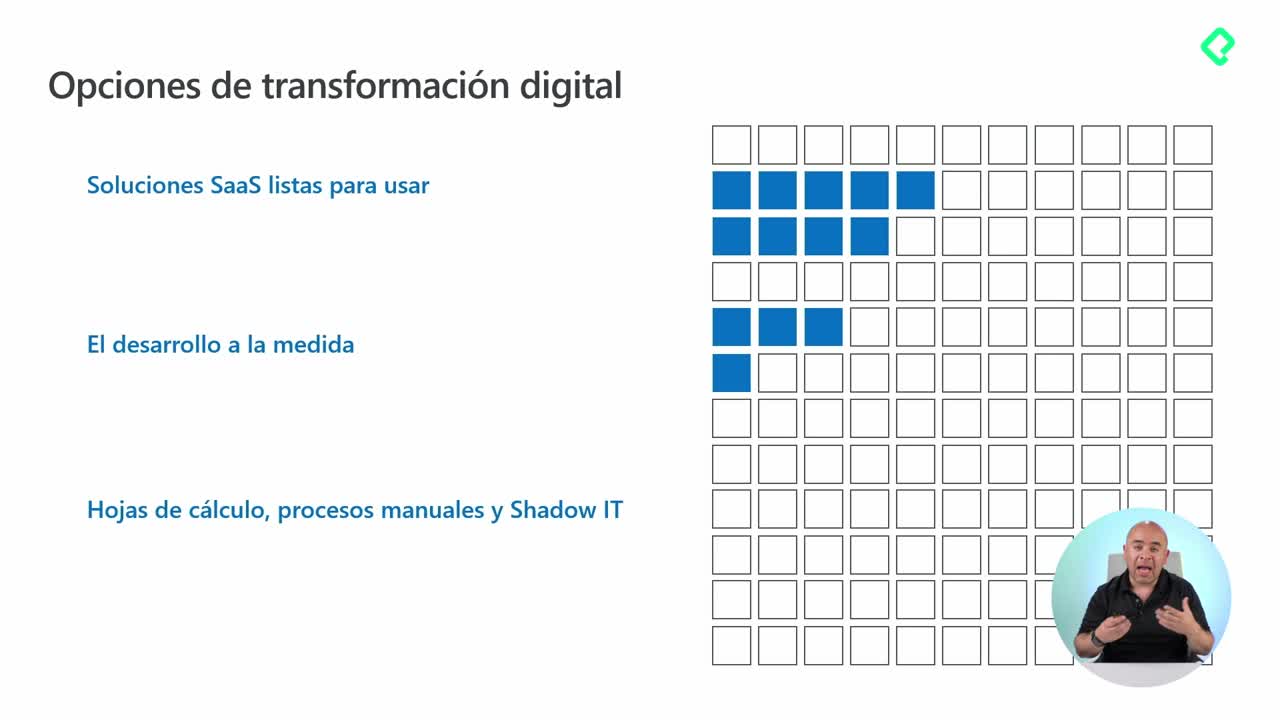

¿Qué es Shadow IT y por qué importa?

- Apps no autorizadas: uso de herramientas fuera del catálogo corporativo.

- Repositorios paralelos: archivos en USB o servicios personales que disparan fuga de datos.

- Riesgo de cumplimiento: datos sensibles procesados en entornos sin controles.

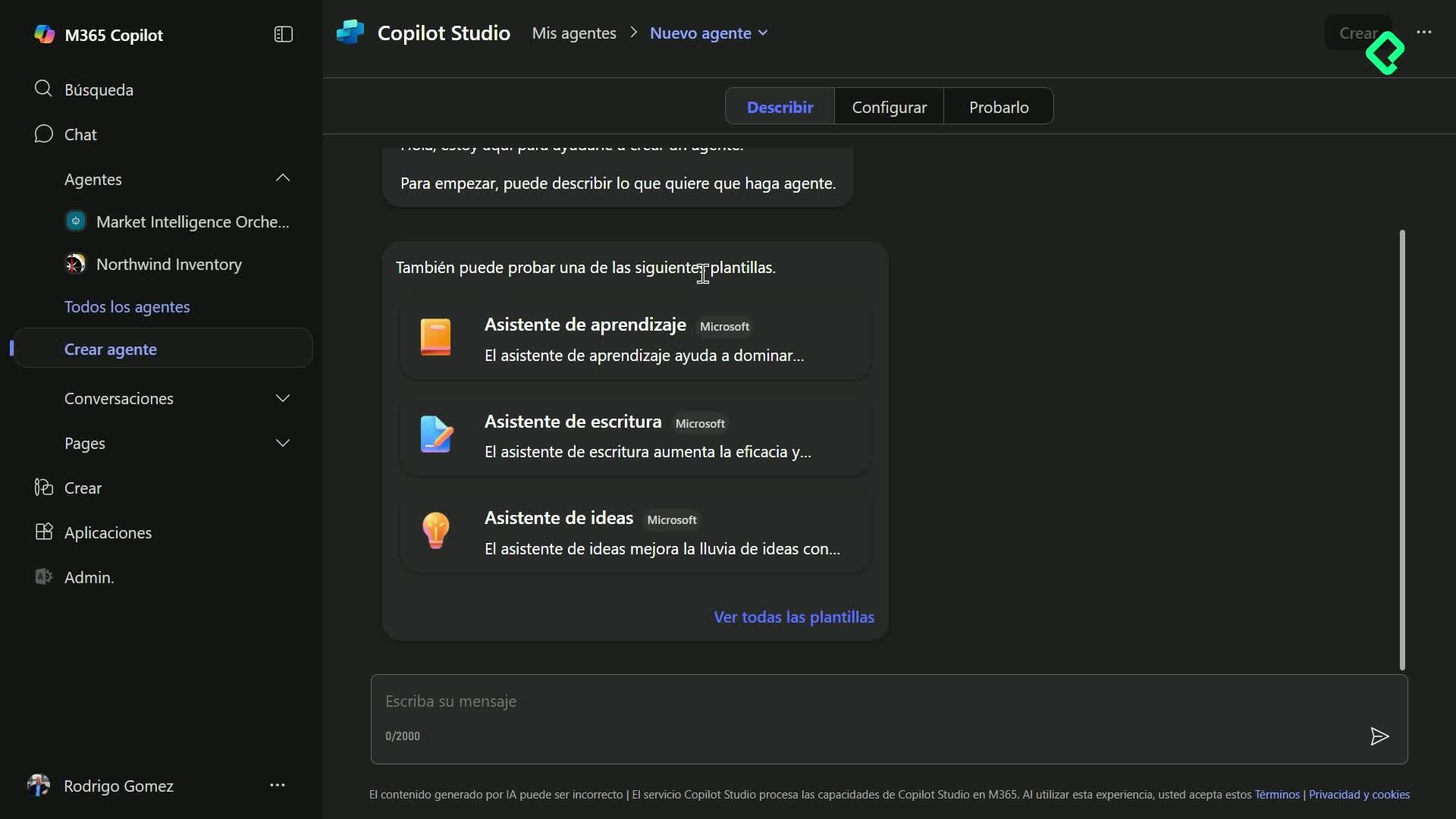

¿Qué controles protegen datos y agentes en Microsoft 365 y fuera?

La protección abarca el tenant de Microsoft 365 y también las interacciones externas, incluidas búsquedas web y servicios de terceros como ServiceNow, con compromisos contractuales y políticas alineadas.

¿Qué prácticas elevan la protección de datos?

- Etiquetado de sensibilidad: aplica políticas y cifrado según la etiqueta del contenido.

- Auditoría en Microsoft 365: registra acciones como abrir, guardar y compartir archivos.

- Permisos adecuados: evita que la IA responda consultas sin autorización (por ejemplo, salarios).

- Prevención de pérdida de datos (DLP): automatiza etiquetado y bloqueos sin frenar la productividad.

¿Cómo se protege el acceso y el uso de agentes?

- Acceso condicional: acceso dinámico según riesgo y contexto.

- Controles adicionales: solicita doble factor de autenticación cuando aplique.

- Gobierno de agentes: monitorea agentes inactivos, usos indebidos e incidencias; retira lo que no se use o sea inapropiado.

¿Cuáles son las nuevas superficies de ataque en IA generativa?

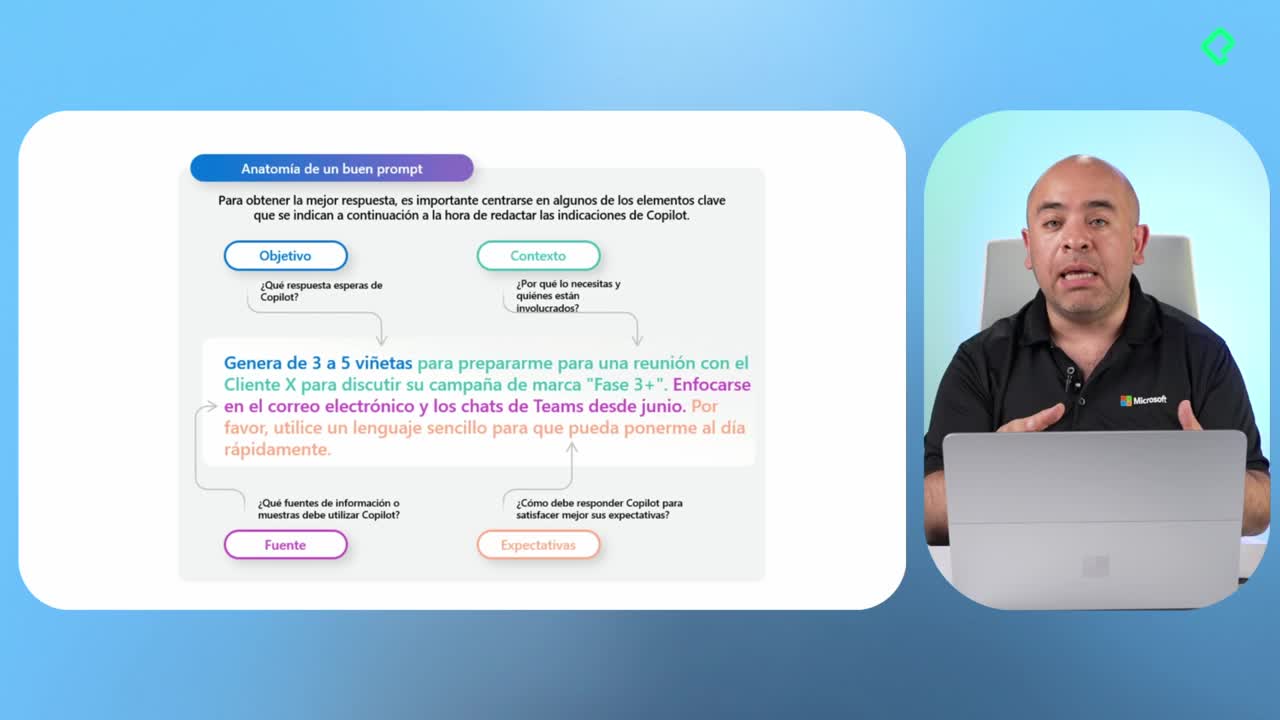

- Indicaciones y respuestas: manipulación de prompts o salidas para extraer información.

- Orquestación comprometida: instrucciones maliciosas que ejecutan acciones no deseadas.

- Entrenamiento: sesgos o vulnerabilidades según los datos usados.

- Datos RAG: contaminación de fuentes que complementan respuestas.

- Modelos y plugins/habilidades: exposición en la interacción con servicios externos.

Consecuencias típicas: fuga de datos, jailbreak o inyección rápida indirecta, vulnerabilidades del modelo y alucinaciones. Mitigaciones como buen diseño de prompting, uso de RAG y ajuste fino (fine‑tuning) ayudan a reducir estos efectos.

¿Quieres profundizar en etiquetado, DLP o gobierno de agentes en tu entorno? Cuéntame tu caso y vemos los siguientes pasos.