Tokenización avanzada con Hugging Face y Transformers

Clase 10 de 16 • Curso de NLP con Python

Contenido del curso

Técnicas Tradicionales de NLP para Documentos Empresariales

- 4

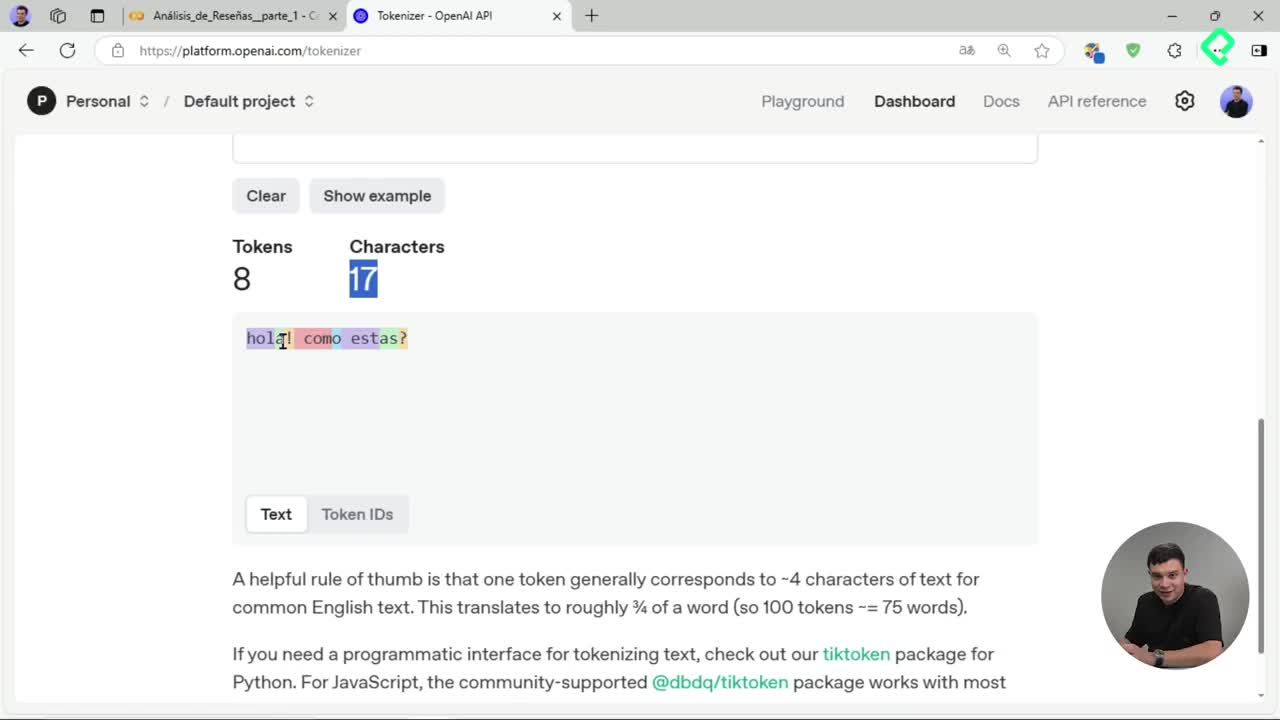

Tokenización de texto: división en unidades procesables para IA

06:52 min - 5

Creación de nubes de palabras con stemming y lematización

05:08 min - 6

Bag of Words y TF-IDF para representación vectorial de texto

05:32 min - 7

Análisis LDA para detectar temas ocultos en reseñas de texto

03:08 min - 8

Entrenamiento de clasificador Naive Bayes para reseñas de productos

07:42 min

Introducción y Profundización en Transformers para Aplicaciones Empresariales

- 9

Arquitectura Transformers en procesamiento de lenguaje natural

07:16 min - 10

Tokenización avanzada con Hugging Face y Transformers

Viendo ahora - 11

Análisis de sentimiento con modelos preentrenados de Hugging Face

04:00 min - 12

Reconocimiento de entidades con BERT y Transformers en español

05:46 min - 13

Fine tuning de modelos Transformer para análisis de sentimientos

10:18 min

Proyecto Final y Estrategia Comercial B2B

La tokenización de texto ha evolucionado significativamente gracias al surgimiento de modelos preentrenados como los que ofrece la librería Transformer de Hugging Face. Anteriormente, los métodos tradicionales —como Bag of Words, TF y DF— se encargaban de limpiar documentos para luego tokenizarlos; sin embargo, ahora se dispone de métodos avanzados que entienden mejor el contexto actual, incluyendo caracteres especiales y emojis.

¿Por qué usar la GPU es esencial en tokenización con Transformers?

El uso de una GPU resulta esencial cuando trabajamos con la librería Transformer debido a su alta demanda de recursos computacionales. Por lo tanto, es recomendable verificar la conexión GPU en un notebook para asegurar una rápida ejecución y suficiente memoria:

- Dirígete a editar en el notebook.

- Selecciona configuración del cuaderno.

- Verifica que estés conectado a la GPU.

¿Qué beneficios ofrecen los tokenizadores modernos frente a los tradicionales?

El empleo de Hugging Face y Transformer para la tokenización presenta importantes ventajas:

- Comprensión mejorada del contexto: caracteres especiales y emojis.

- División de palabras en unidades más pequeñas llamadas subword units.

- Captura de morfología, facilitando la recombinación de palabras.

- Manejo de vocabularios amplios y palabras poco frecuentes.

¿Qué técnicas específicas de tokenización tiene Hugging Face?

Existen dos técnicas predominantes de tokenización en Hugging Face:

- BPE (Byte-Pair Encoding)

- Wordpiece

Estas técnicas brindan la capacidad de segmentar palabras en subunidades, facilitando así la cobertura del vocabulario actual y proporcionando mejor desempeño con palabras poco frecuentes y especializadas.

¿Cómo seleccionar el tokenizer adecuado según idioma y contexto?

La elección del tokenizer depende del idioma del texto y del sector específico al que pertenece:

- Selecciona un tokenizer preentrenado según el idioma (p.ej., español).

- Considera el enfoque (datos financieros, marketing, etc.).

- Usa la plataforma Hugging Face para identificar tokens preentrenados, donde encontrarás modelos específicos, como el basado en BERT desarrollado por la Universidad de Chile.

¿Qué pasos seguir para una tokenización efectiva con Transformers?

Los pasos principales son:

- Importa el tokenizer usando auto tokenizer desde la librería Transformer.

- Descarga y utiliza modelos preentrenados.

- Utiliza una GPU para evitar limitaciones de memoria.

Al aplicar estos pasos, notarás una latencia muy baja debido al poder computacional de la GPU, permitiendo obtener tokens específicos rápidamente.

Te animo a compartir en los comentarios cualquier experiencia o duda acerca del uso de tokenizers en Hugging Face.