En los oscuros días de internet de los noventa, antes de que existiera google, encontrar paginas web con contenido de valor era un autentico ejercicio de frustación, era la epoca de la carrera de los navegadores, internet apenas nacía en su forma moderna, y las paginas que valían la pena eran sepultadas en un cúmulo de paginas y páginas web de contenido irrelevante. Los ingenieros y programadores de la época se enfrentaban a un problema de definición de contenidos, ¿Como encontrar en internet paginas que sean buenas? o en un sentido mas profundo ¿que es lo que hace que una pagina sea buena?

Una dificultad de partida es, que era imposible que una persona se sentara a leer todas las paginas, y mas teniendo en cuenta que en los noventa y comienzos de los dos mil empezaron a nacer miles y miles de sitios web. De modo que, la respuesta a que es lo que hace que una pagina sea buena es aparentemente sencilla pero de una profundidad enorme: una pagina buena es la que enlaza a otras paginas buenas.

En concreto, la idea fundamental era que la red definiera la calidad de las paginas en función de sus enlaces, una buena página contiene un ranking por la referenciación que tiene de otras paginas, esta fue la idea en la cual se basaron Larry Page y Sergei Frinn, los fundadores de Google, para formular el algoritmo de pagerank, con el cual en gran medida le dieron forma a internet, tal y como lo conocemos hoy.

Los algoritmos basados en enlaces corresponden a un conjunto de interrelaciones que corresponden al algebra lineal, el area de las matematicas que estudia los vectores, las matrices, y por sobre todo, la resolución de muchas ecuaciones de forma simultanea. Es el fundamento de lo actualmente reconocemos como machine learning, los sistemas de reconocimiento facial, o el sistema de recomendación de películas de netflix. Pero, para poder entender como funciona el algebra lineal, imaginemos una red de internet muy elemental.

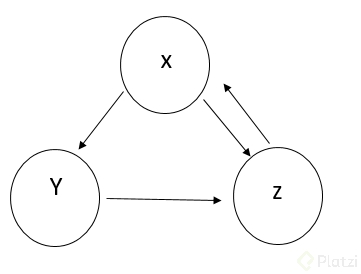

Sin embargo, observese como ocurren los enlaces. la pagina x tiene un enlace en y, a su ves, la pagina y tiene un enlace a z;ademas x tiene en enlace adicional a x, x y y enlaza a z, y z le devuelve el enlace a y, esto hace que el ranking se modifique así:

x = 1/3

y = 1/2x = 1/6

z = 1/2 x + y = 1/6 + 1/3 = 1/2

Aqui tenemos un ciclo, en el cual, si los ranking de las paginas iteran su tasa de ingreso 10 veces, se va a obtener algo como

o en otras palabras x = 2y = z o 2/5 = 1/5 * 2 = 2/5

Ecuaciones como esta son comunes en el mundo del algebra lineal, y permitieron resolver el problema de la clasificación de las paginas web en función de su cantidad de enlaces, como se puede ver, un avance matematico de la edad media que se convirtió en un algoritmo a finales del siglo XX, generando millones y millones de dolares

Nota, el presente texto fue basado en el libro “El placer de la x” de Steven Stroagratz

Fundamentos de Ingeniería de Software

COMPARTE ESTE ARTÍCULO Y MUESTRA LO QUE APRENDISTE