Hoy en día, utilizar Inteligencia Artificial como herramienta para crear código es algo común y normal en el flujo de trabajo. Desde GitHub Copilot, que está integrado de forma nativa en VSCode, hasta extensiones que permiten agregar soporte a múltiples LLMs, estas herramientas hacen que el proceso de desarrollo sea mucho más fácil.

Gracias a Ollama y la extensión Continue.dev, ahora puedes ejecutar modelos de IA localmente en Visual Studio Code y obtener asistencia inteligente sin costo alguno.

A continuación, te explico cómo instalar y configurar DeepSeek-R1 para que puedas integrarlo en tu flujo de trabajo.

Cómo instalar y ejecutar DeepSeek-R1 de manera local

Lo primero que debes hacer es seguir los pasos necesarios para instalar y ejecutar DeepSeek-R1 en tu computadora. No es necesario completar todos los pasos de configuración avanzada; basta con que logres que el modelo funcione correctamente desde la terminal.

Validar la instalación de DeepSeek-R1 en local

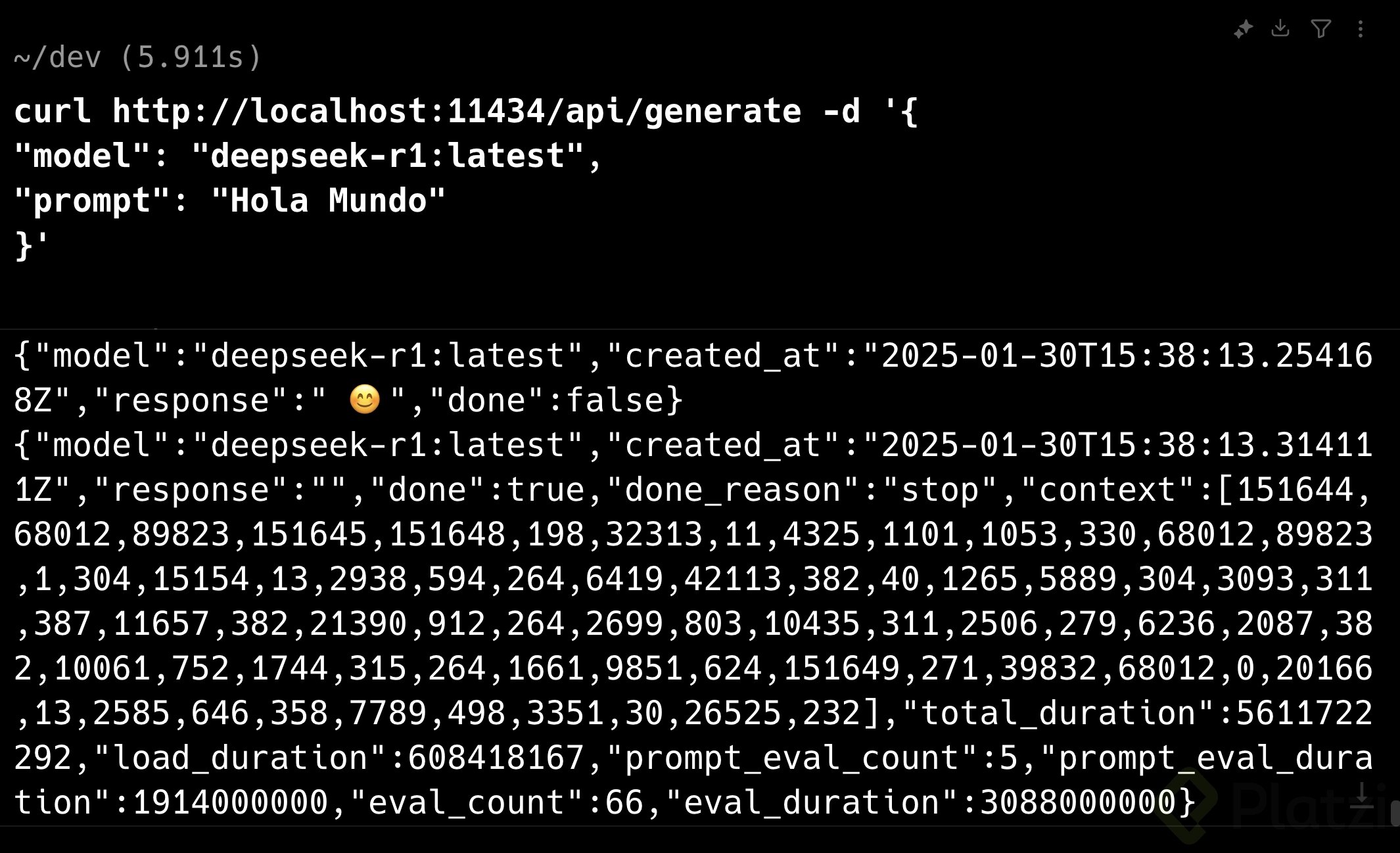

Una vez que Ollama esté en funcionamiento, vamos a comprobar que podemos comunicarnos con DeepSeek-R1 y verificar que el modelo responde correctamente. Para ello, ejecuta el siguiente comando en tu terminal:

curl http://localhost:11434/api/generate -d'{

"model": "deepseek-r1:latest",

"prompt": "Hola Mundo"

}'

Si todo está configurado correctamente, verás una respuesta en bloques de tiempo donde el modelo DeepSeek-R1 responde. Esto indica que está listo para ser integrado en tu entorno de desarrollo en VSCode.

Configuración de la extensión Continue.dev

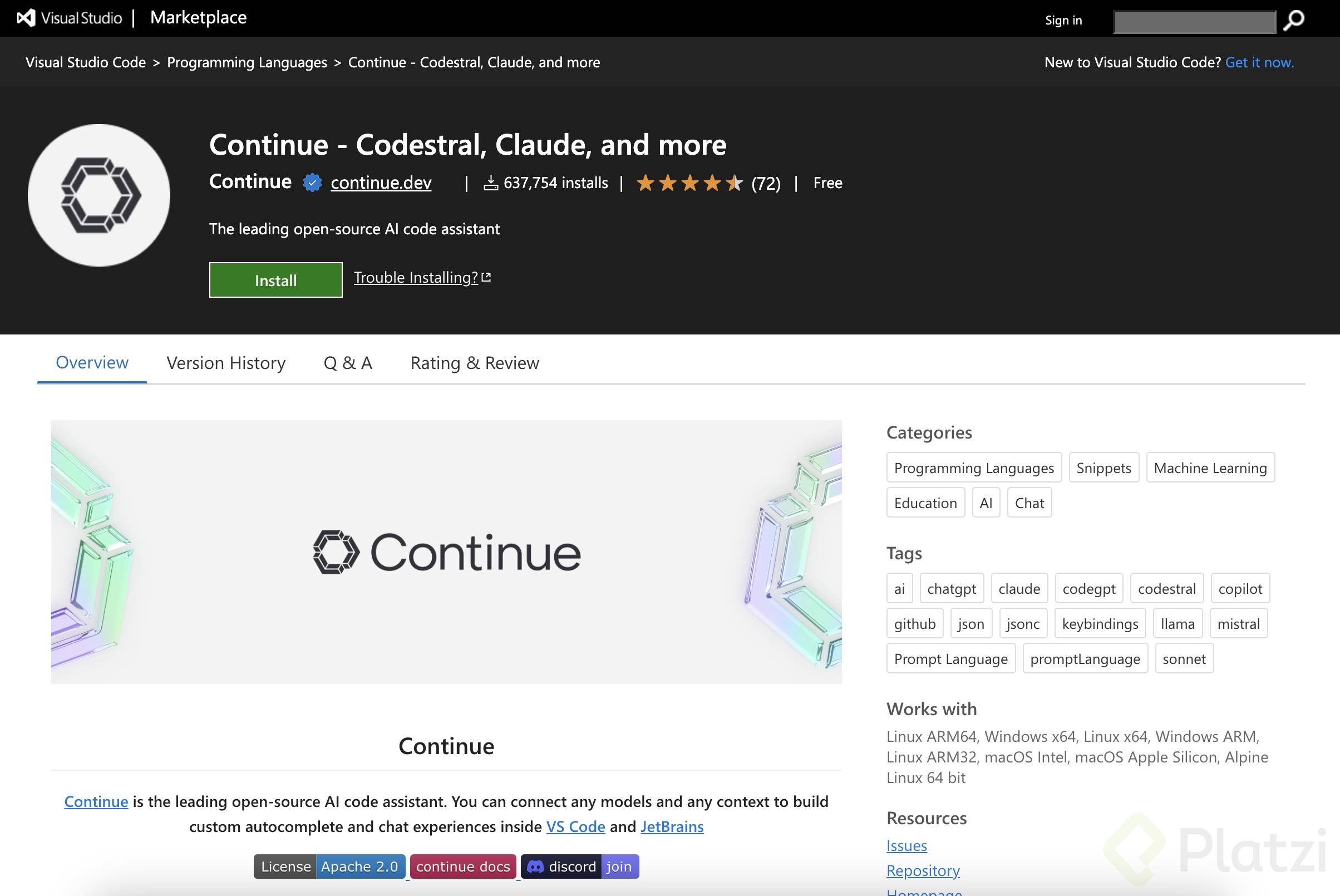

Para trabajar con DeepSeek-R1 en tu entorno de desarrollo en VSCode, es necesario instalar una extensión que permita la comunicación con Ollama y DeepSeek-R1. Esta extensión, llamada Continue.dev, te permitirá autocompletar código, iniciar chats y mejorar tu flujo de desarrollo, de forma similar a GitHub Copilot, pero completamente gratis y desde tu entorno local.

Pasos para instalar Continue.dev:

- Asegúrate de tener instalado Visual Studio Code.

- Dirígete al Marketplace de extensiones de VSCode.

- Busca e instala la extensión Continue.dev.

Esta herramienta te permitirá integrar modelos de IA y convertirlos en tu copiloto de desarrollo.

Configuración de DeepSeek-R1 en VSCode

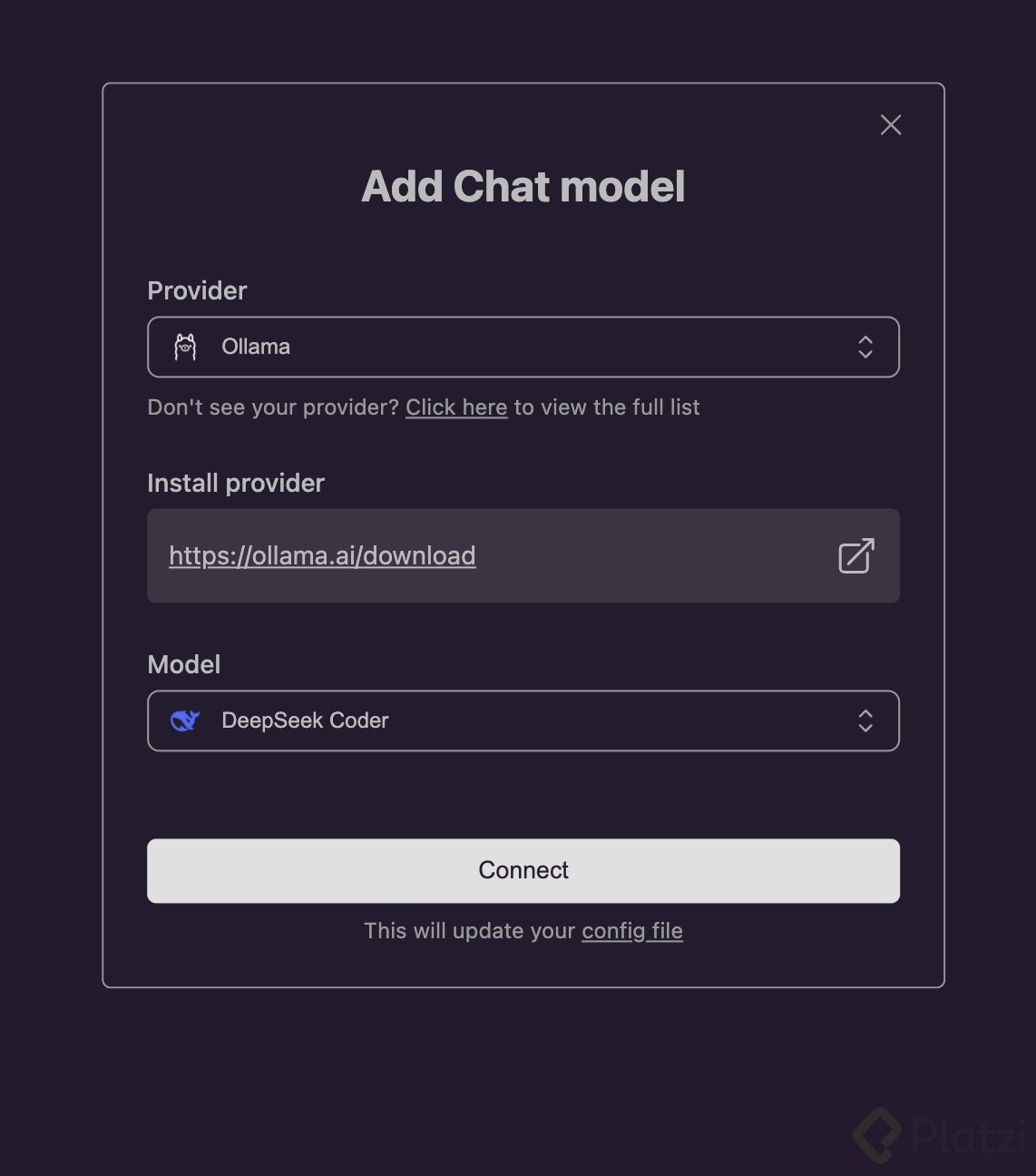

Con la extensión instalada y la comunicación con DeepSeek-R1 validada, es momento de configurarlo en VSCode:

- Abre VSCode en cualquier proyecto que tengas.

- En el menú lateral, encontrarás un nuevo ícono de Continue.dev.

- Haz clic en él y procede a agregar un nuevo modelo de chat.

- Configura DeepSeek-R1 como tu modelo principal.

Ejecutar DeepSeek-R1 en VSCode

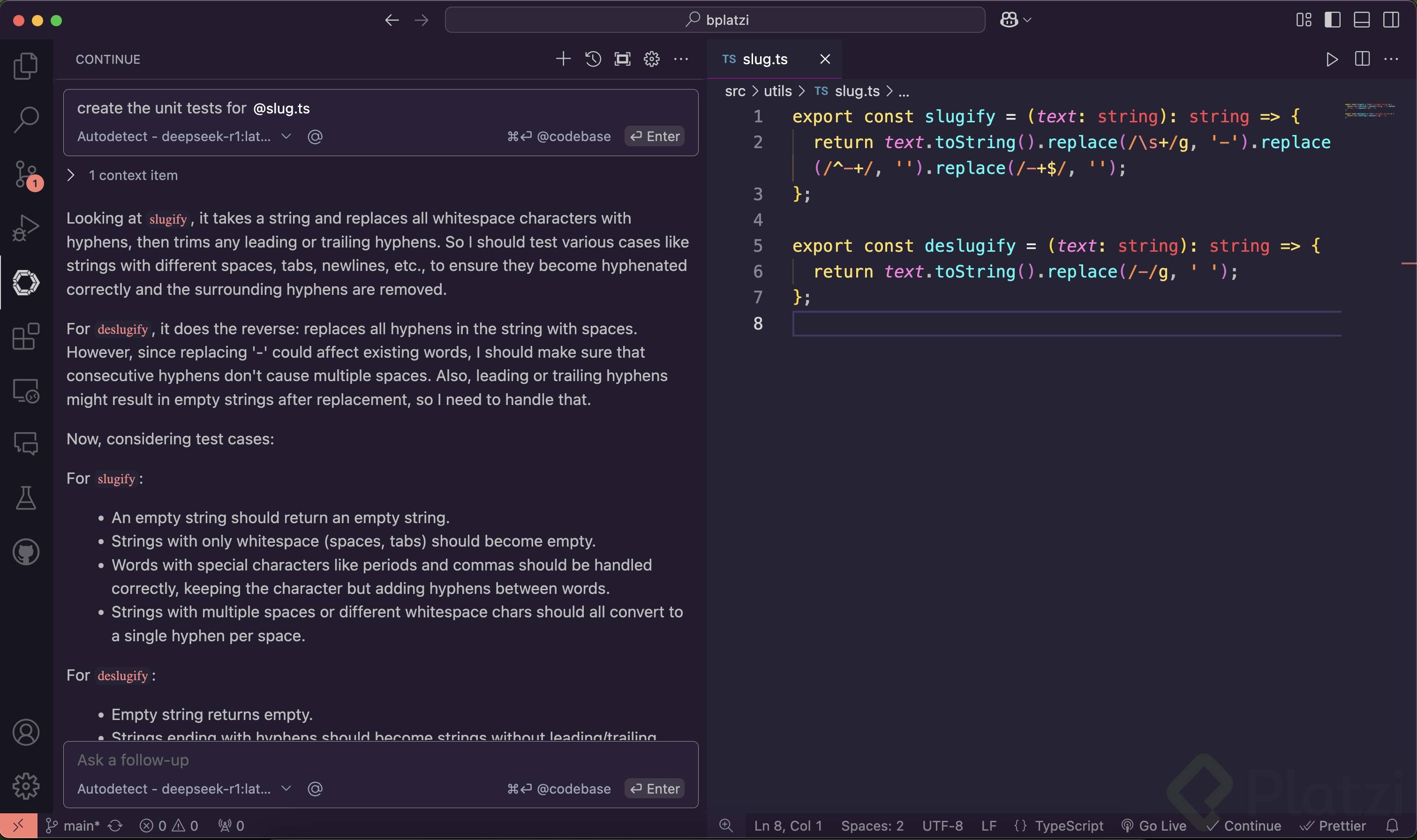

Con toda la configuración previa completada, ya puedes utilizar Continue.dev para autocompletar código o realizar solicitudes directamente desde su interfaz de chat.

Por ejemplo, en un proyecto personal con dos funciones utilitarias para trabajar con slugs, le pedí a DeepSeek-R1 que generara pruebas unitarias para garantizar que estas funciones cumplieran con su objetivo. El modelo respondió correctamente, explicando y generando el código solicitado.

Si llegas a este punto y obtienes resultados satisfactorios, significa que DeepSeek-R1 está funcionando correctamente en tu entorno local. Ahora puedes usarlo para trabajar en tus proyectos sin necesidad de pagar por servicios en la nube o depender de una IA externa.

¿Por qué aprovechar DeepSeek-R1 dentro de VSCode?

- Ofrece propuestas de autocompletado más precisas.

- Aporta refactorización de código inmediata.

- Resuelve dudas sobre snippets de forma clara y eficiente.

- Asegura procesamiento local y rápido, reforzando la privacidad y el control sobre tus datos.

Con esta configuración, tendrás una herramienta poderosa y gratuita para mejorar tu flujo de trabajo en desarrollo de software. ¡Aprovecha al máximo DeepSeek-R1 y Continue.dev!

Si quieres aprender más sobre DeepSeek y liderar la revolución en inteligencia artificial, te recomiendo separar tu cupo para la charla privada sobre AI con Freddy Vega.

Si quieres aprender más sobre DeepSeek y liderar la revolución en inteligencia artificial, te recomiendo separar tu cupo para la charla privada sobre AI con Freddy Vega.

Curso de Fundamentos de Matemáticas