Configuración de LLM en Azure AI Foundry para MCP Server

Clase 15 de 22 • Curso de MCP con Microsoft Azure

Contenido del curso

Conceptos basicos de MCP

- 5

Configuración de ambientes virtuales con UV en Python

05:48 min - 6

Creación de cliente Python para comunicación con servidor

07:19 min - 7

Integración de LLM con cliente MCP usando GitHub tokens

11:38 min - 8

Conexiones SSE en Fast MCP para streaming eficiente

05:45 min - 9

Integración de LLM con servidores MCP usando AI Toolkit

11:15 min - 10

Uso de servidor MCP por línea de comandos

08:54 min - 11

Despliegue de servidores MCP en Azure Container Apps

09:39 min - 12

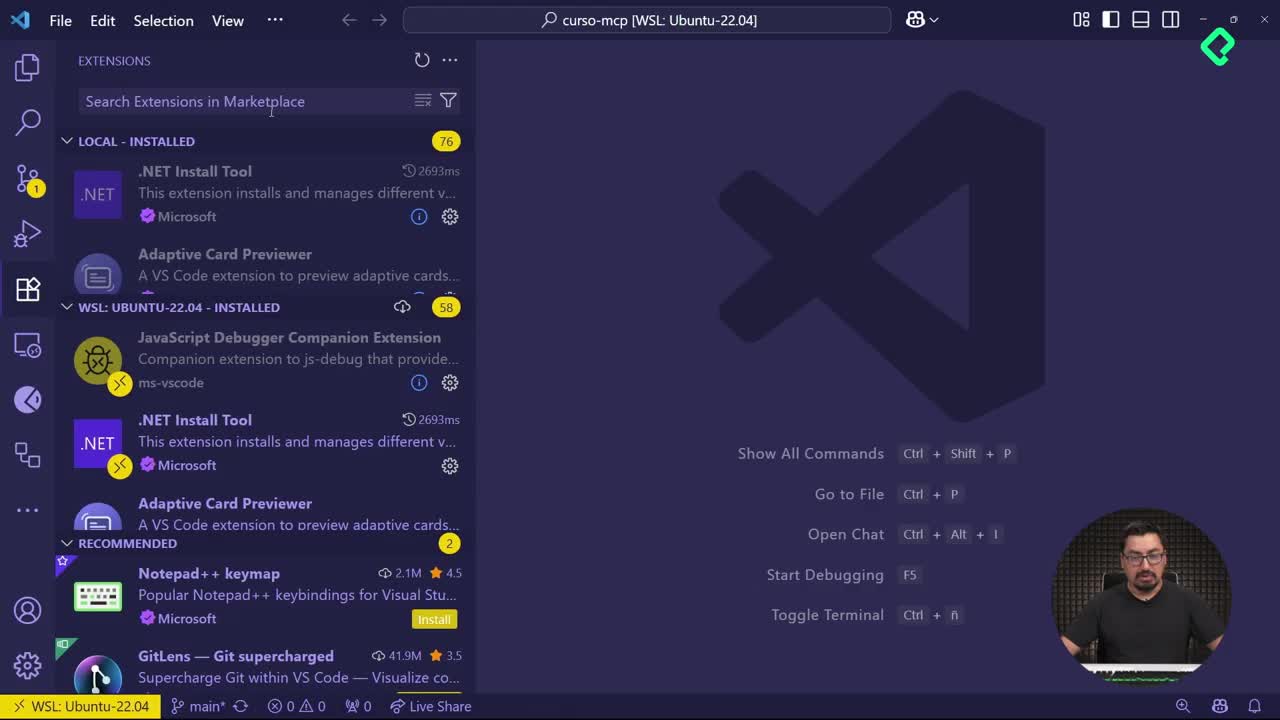

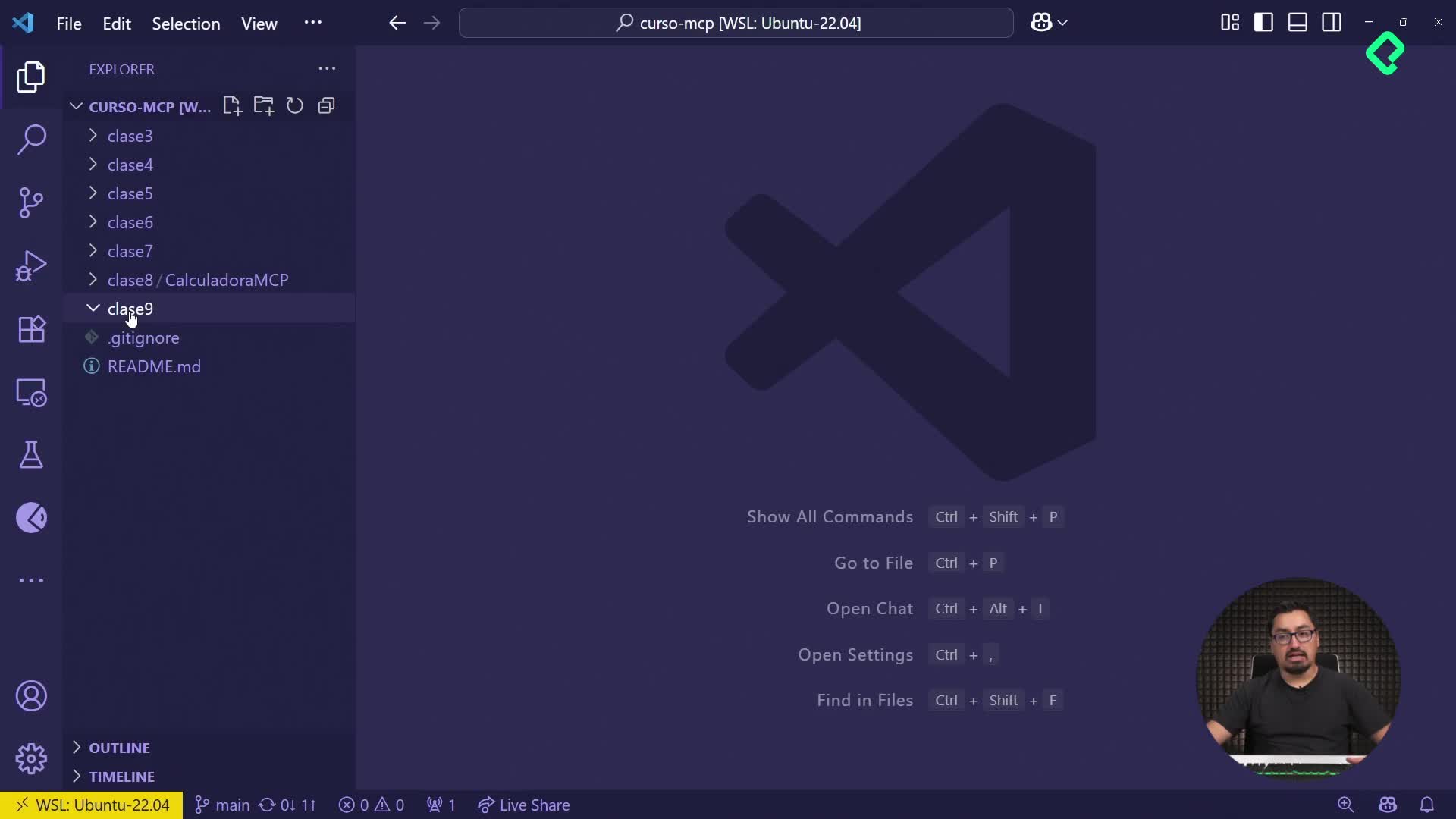

Configuración de servidores MCP en Visual Studio Code con Copilot

09:53 min

MCP avanzado

- 13

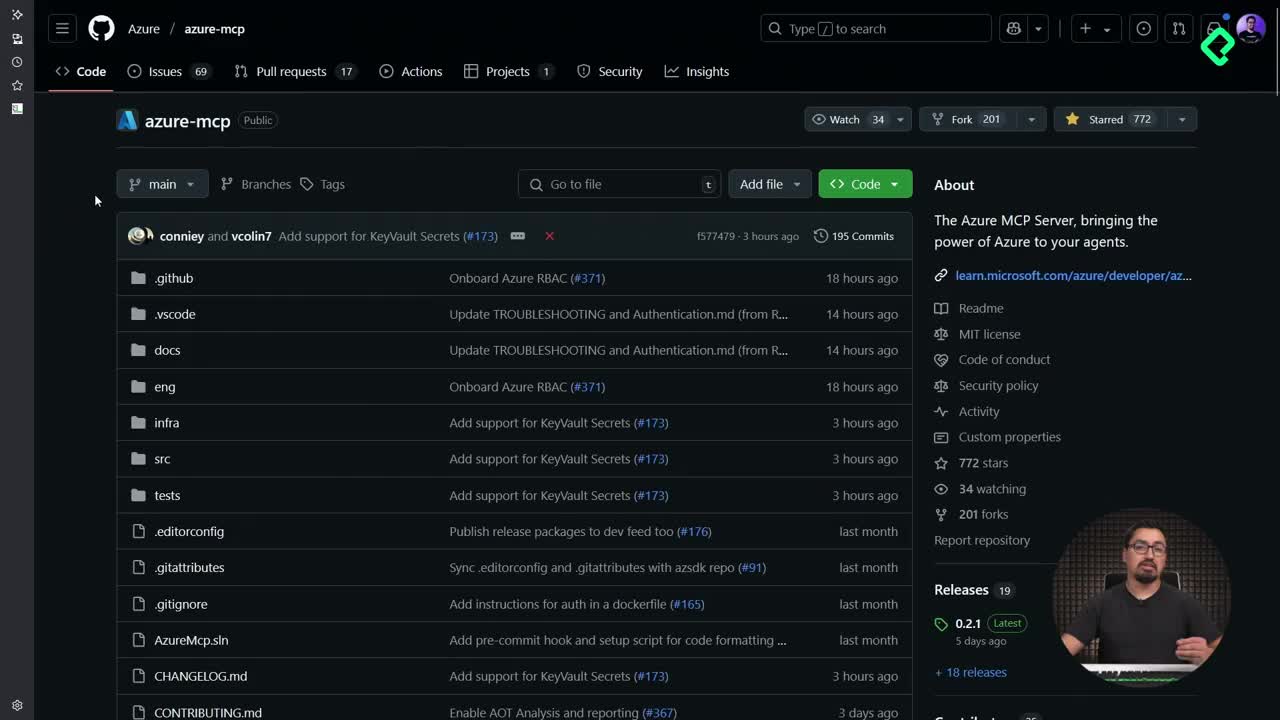

Configuración de Azure MCP Server en VS Code para consultas directas

06:46 min - 14

Herramientas avanzadas de MCP para optimizar servidores y seguridad

03:54 min - 15

Configuración de LLM en Azure AI Foundry para MCP Server

Viendo ahora - 16

Procesamiento multimodal de imágenes en servidores MCP con NumPy

09:48 min - 17

Gestión de contexto dinámico en agentes de IA con MCP y Python

05:02 min - 18

Enrutamiento de herramientas con MCP Server

09:20 min

Integrando tu MCP con un agente

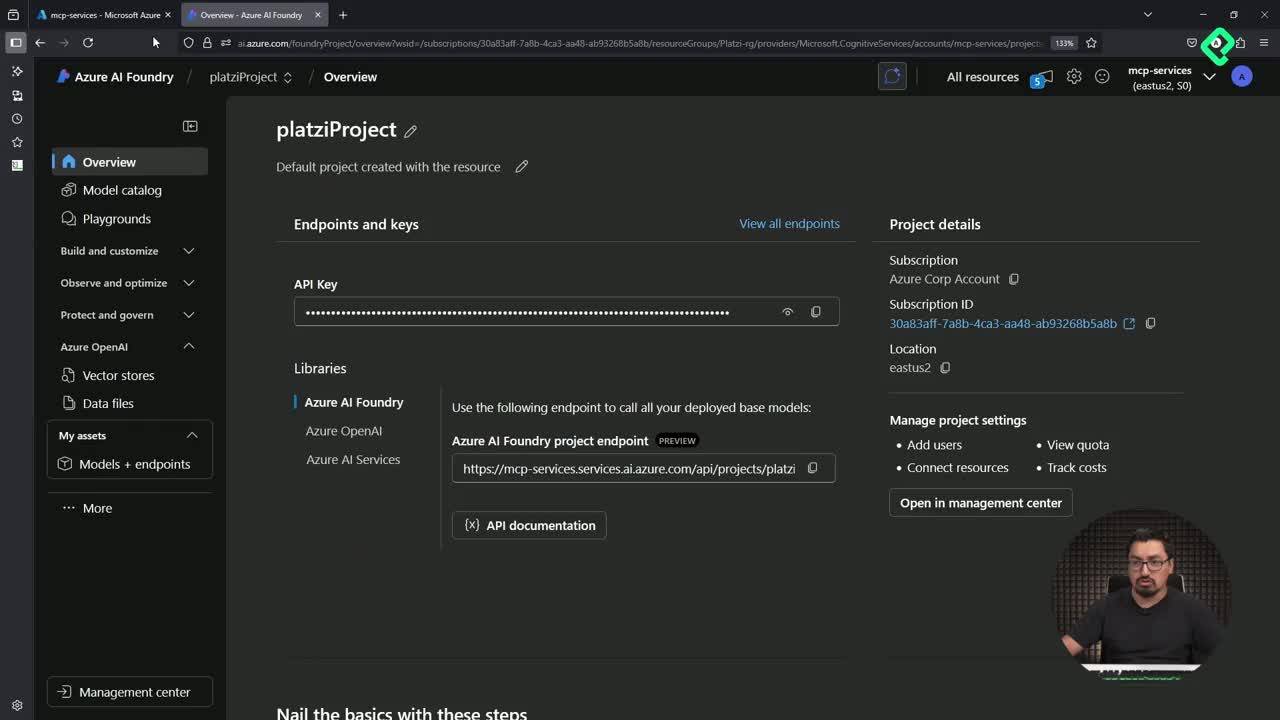

Crear un Large Language Model (LLM) usando la plataforma Azure AI Foundry facilita integrar inteligencia artificial a proyectos como MCP Server. Al desplegar este modelo en Azure, evitarás utilizar el crédito dado aprovechando las capas gratuitas disponibles, garantizando eficiencia en costos y agilidad en implementación.

¿Qué necesitas para desplegar tu modelo en Azure AI Foundry?

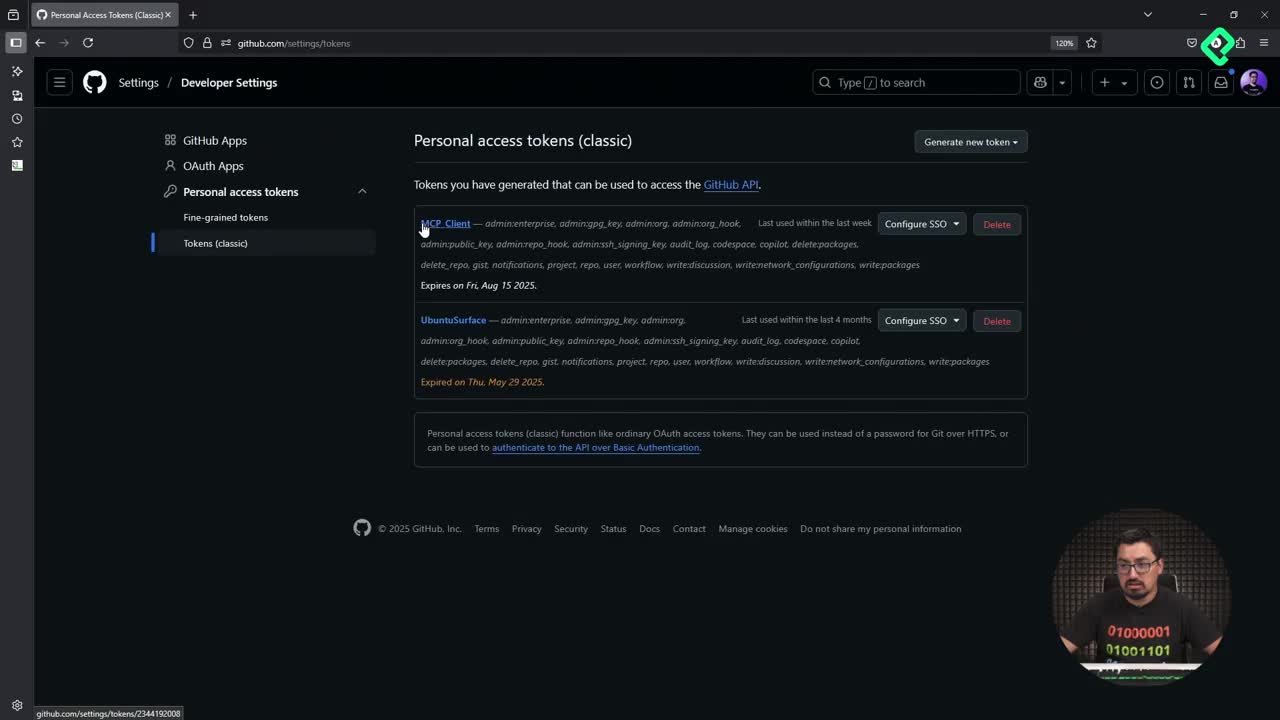

Para desplegar efectivamente un LLM con Azure Foundry, debes tener previamente:

- Una suscripción activa en Azure.

- Un grupo de recursos configurado (por ejemplo, Platzi RG).

Dentro del portal de Azure AI Foundry, es clave guardar estos datos esenciales:

- API version.

- Endpoint.

- Llave de acceso (key).

Estos datos serán necesarios al configurar posteriormente tu entorno local.

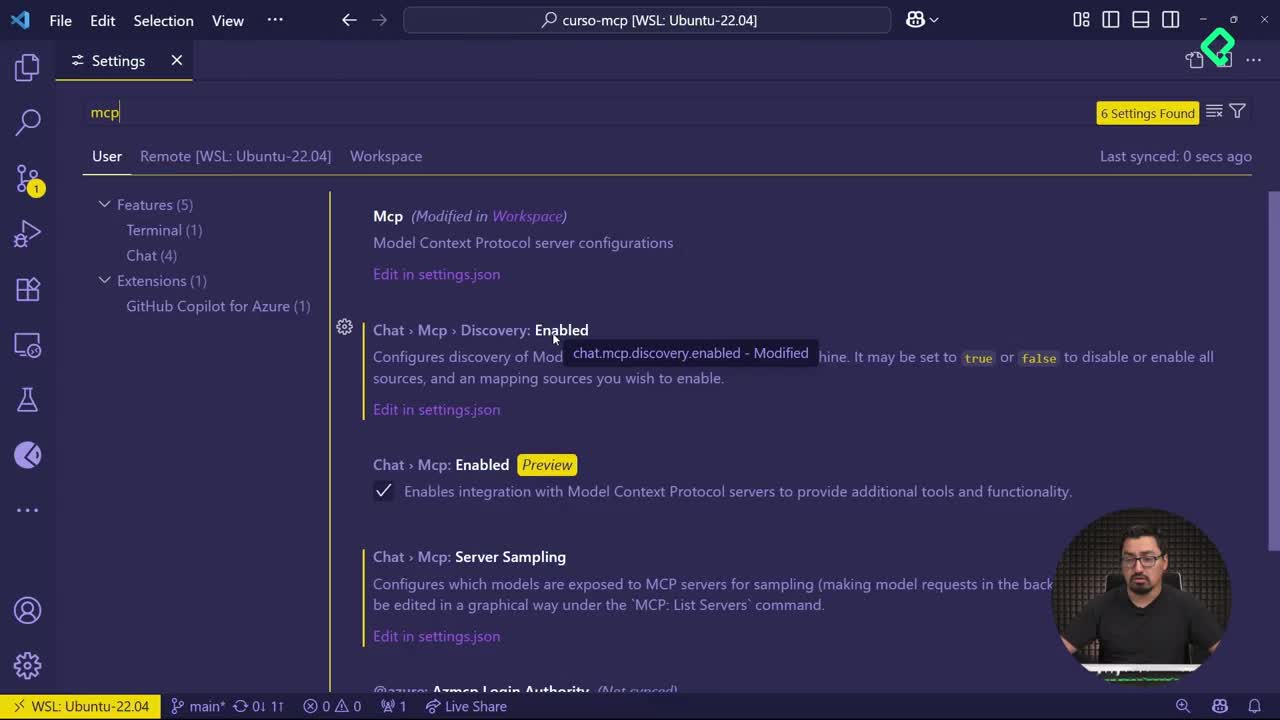

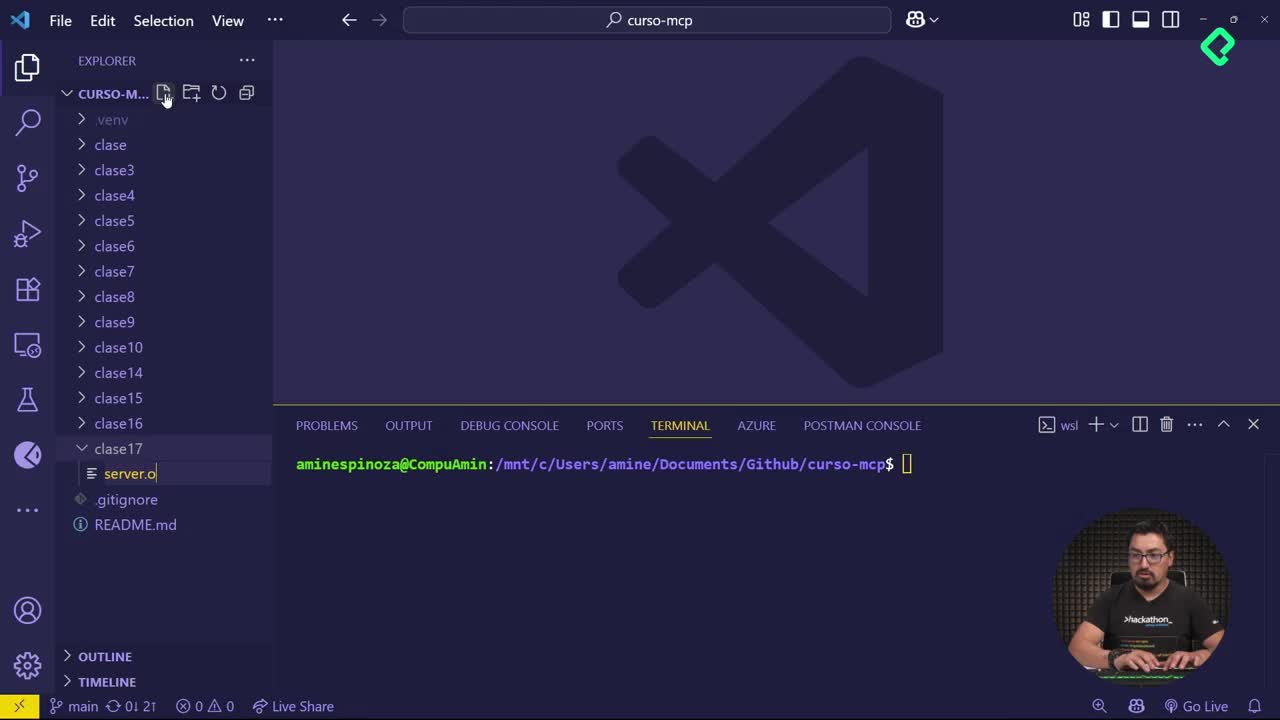

¿Cómo configurar el archivo ENV para usar tu modelo en BSCode?

El archivo de configuración en BSCode esencial para comunicar tu entorno local con Azure AI Foundry es el archivo .env. Para prepararlo, sigue este procedimiento:

- Renombra el archivo proporcionado como

env-sample, quitando "sample" para dejarlo como.env. - Añade los tres datos guardados del portal Azure AI Foundry: versión del API, endpoint, y llave de acceso.

- Verifica que el modelo a utilizar también se encuentre definido en este archivo, evitando configuraciones adicionales.

¿Cuáles son las consideraciones claves en tu código Python?

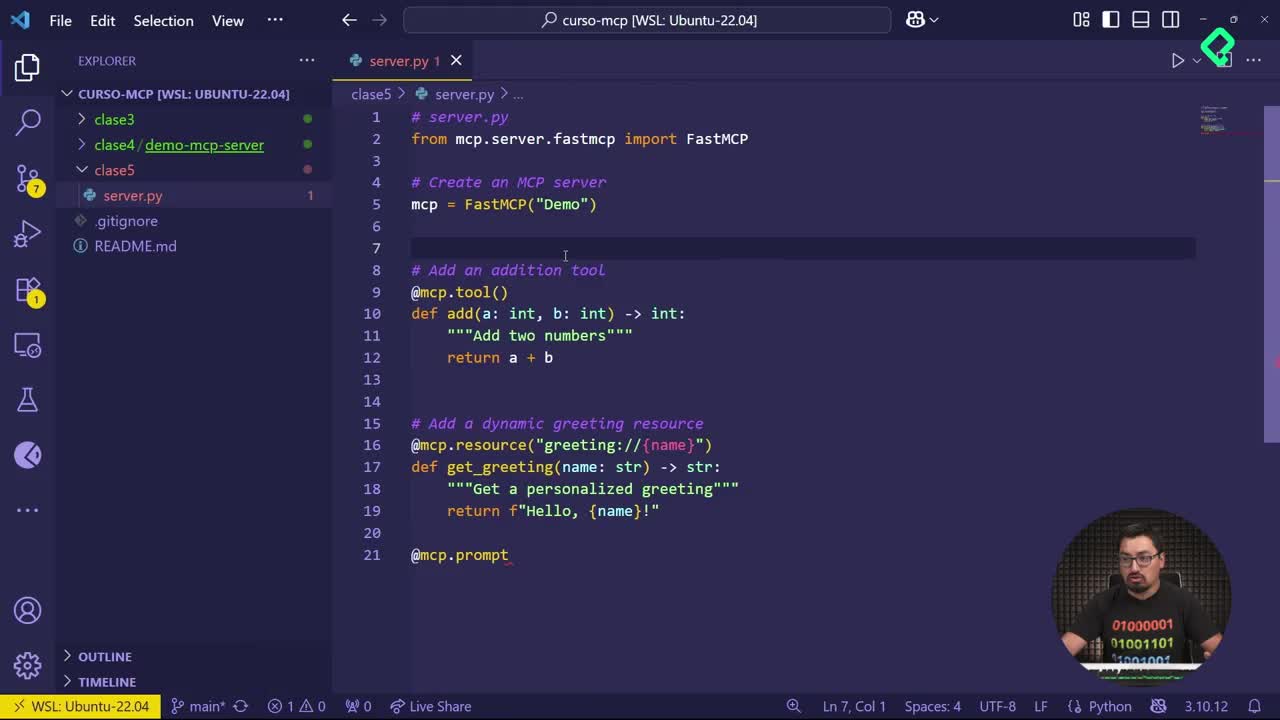

En el archivo Python principal del proyecto, debes importar paquetes esenciales como async IO, os y bibliotecas como agents.mcp. Asegúrate de:

- Definir claramente la función para obtener clientes de Azure OpenAI con tus credenciales.

- Crear una función de ejecución que combine servidor y cliente MCP.

- Establecer claramente los prompts que enviarán consultas específicas al LLM.

¿Cómo generar y personalizar los prompts para mejores resultados?

El ejemplo sugiere prompts como:

- "Lee los archivos en la carpeta sample files y enlista los nombres de los archivos."

- "¿Cuál es mi libro favorito? Mira el archivo favorite_books.txt."

Optimiza estos mensajes ajustándolos claramente a consultas precisas para mejores resultados. Experimenta utilizando ciclos o listas de mensajes diferentes.

¿Cómo preparar y ejecutar correctamente el entorno local?

Para asegurarte que tu aplicación local funciona correctamente, sigue estas pautas:

- Usa un entorno virtual (virtual environment) en Python.

- Instala todas las dependencias de forma adecuada con

pip install -r requirements.txt. - Ejecuta tu archivo principal con el entorno virtual activo mediante comandos claros y concisos.

Esto confirmará rápidamente la comunicación efectiva entre tu aplicación local y Azure AI Foundry.

Te invito a explorar más incorporando tus propios archivos y ajustando los comandos para personalizar los resultados entregados por tu MCP Server y el LLM en Azure.