Fragmentación de documentos en bases de datos vectoriales

Clase 4 de 22 • Curso de RAG con Microsoft Azure

Contenido del curso

Etapas de RAG

- 5

Embeddings y bases de datos vectoriales para documentos digitales

03:35 min - 6

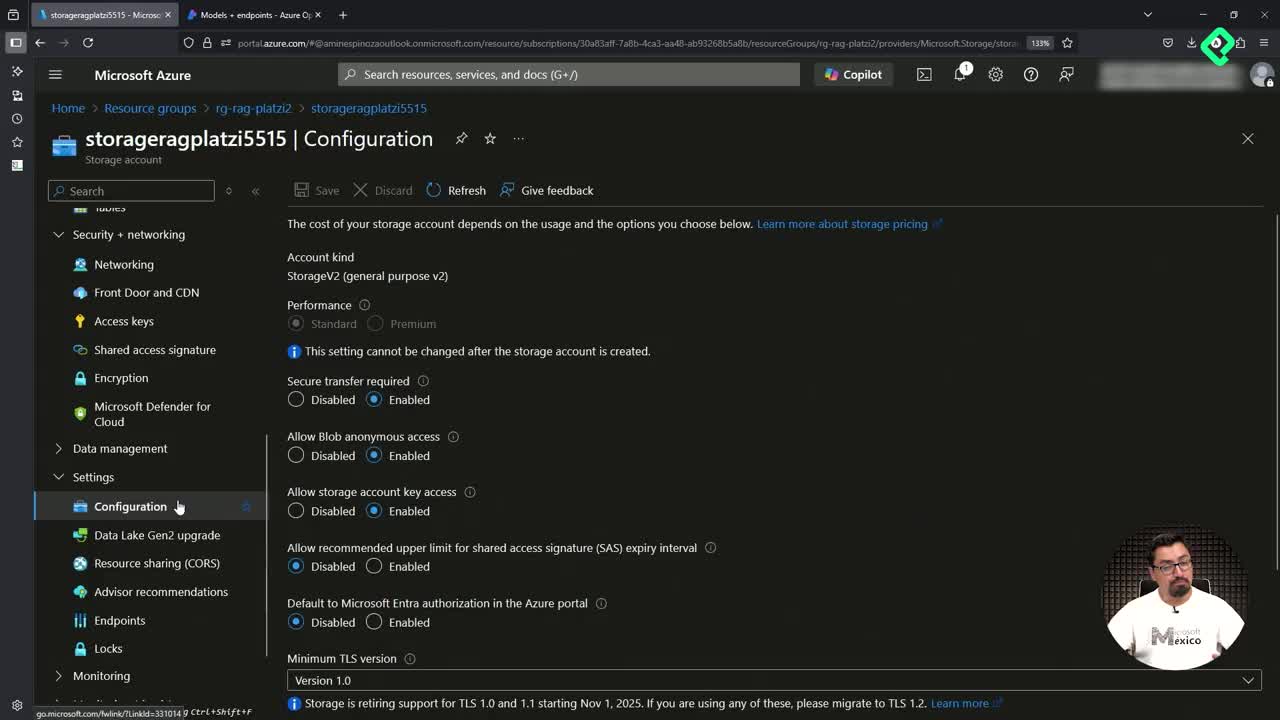

Configuración de Azure para RAG: preparativos y gestión de costos

03:51 min - 7

Qué son las bases de datos vectoriales y sus aplicaciones

04:50 min - 8

Despliegue de recursos de IA en Azure con scripts de Bash

05:15 min - 9

Despliegue de modelos GPT-4 y embeddings en Azure OpenAI

03:01 min - 10

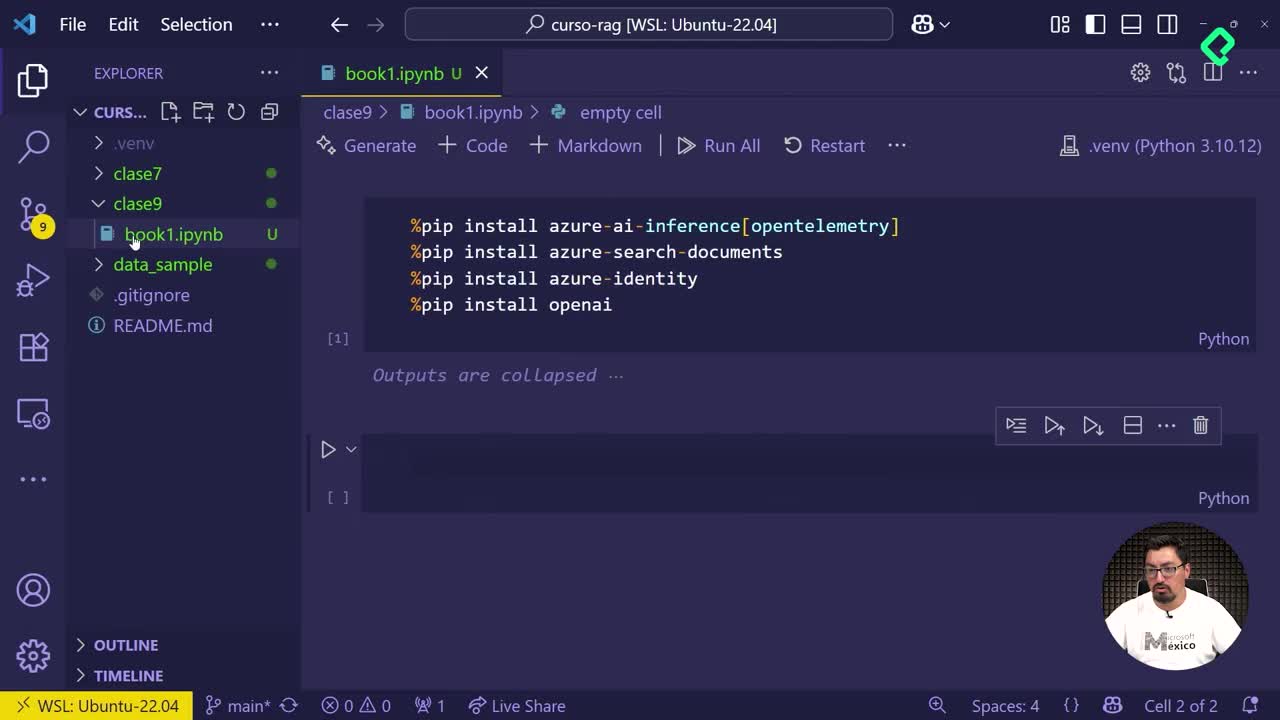

Configuración de Jupyter Notebook y ambientes virtuales en Python

03:37 min

Tecnicas de RAG

- 11

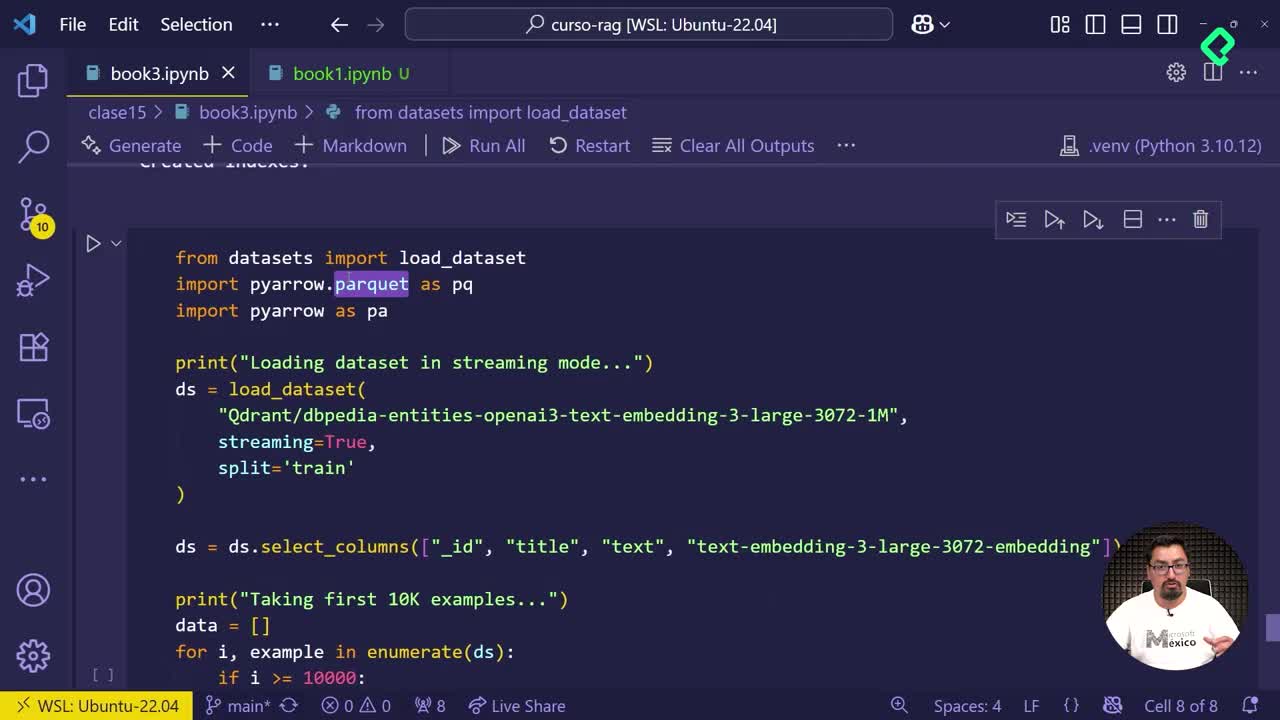

Vectorización de documentos con Azure Search y OpenAI

06:15 min - 12

Configuración de Azure OpenAI y AI Search en Jupyter Notebook

06:56 min - 13

Integración de LLM para optimizar respuestas en Jupyter Notebook

03:09 min - 14

Actualización manual de índices con nuevos documentos PDF

03:17 min - 15

Búsqueda tradicional, vectorial e híbrida en Azure AI Search

06:05 min

RAG avanzado

- 16

Creación de múltiples índices en Azure AI Search con Jupyter

09:40 min - 17

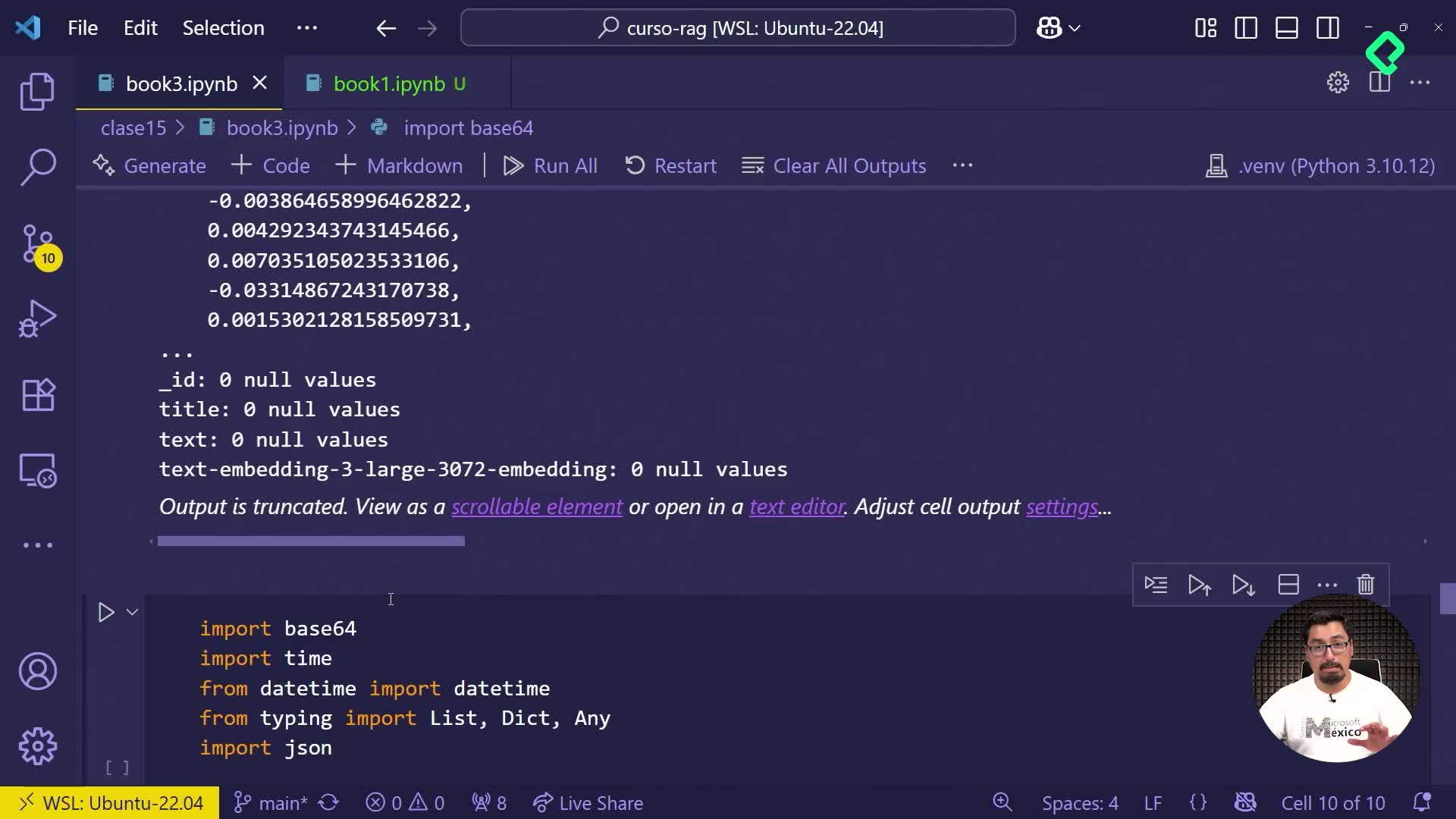

Generación de información ficticia con archivos Parquet

03:14 min - 18

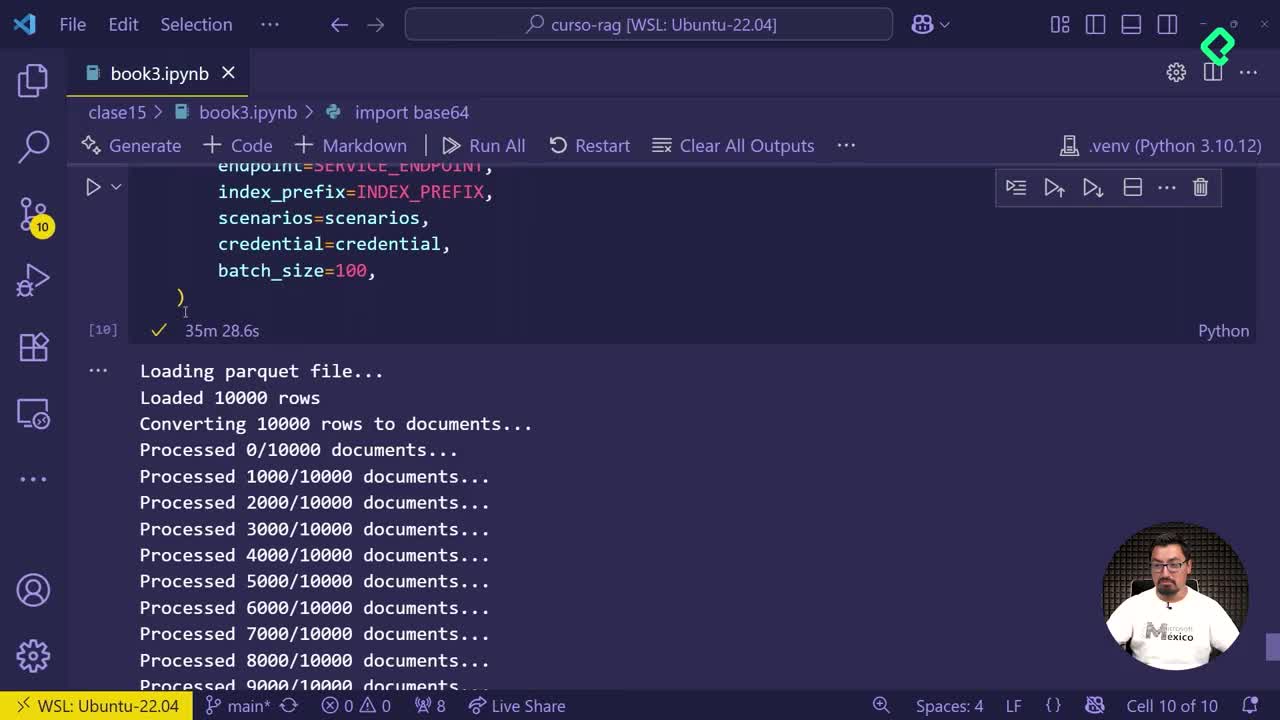

Subida automática de documentos fragmentados a Azure AI Search

02:53 min - 19

Comparación de índices en Azure para optimizar almacenamiento

03:59 min - 20

Creación de aplicación demo con Azure Search Service

03:39 min

Fusionando RAG con un agente

¿Qué diferencia el manejo de información en sistemas web y aplicaciones distribuidas?

Cuando subes documentos completos, como PDF o Word, a un sistema web tradicional, estos se almacenan y descargan de manera íntegra. Sin embargo, en sistemas avanzados como los utilizados por RAG, ocurre un cambio radical en cómo se procesa y almacena esta información.

¿En qué consiste la fragmentación o rebanado de documentos?

El rebanado o fragmentación implica dividir cada archivo, sea texto, PDF o imagen, en pequeños segmentos llamados chunks. Esta división ocurre sin un patrón específico; un solo término podría partirse en diferentes fragmentos sin afectar esencialmente el almacenamiento.

La ventaja radica en que estos chunks permiten almacenar los documentos de manera eficiente en bases de datos especializadas, conocidas como bases de datos vectoriales.

¿Qué son los embeddings y cómo funcionan en bases de datos vectoriales?

Los embeddings representan la manera concreta en que los fragmentos almacenados están organizados dentro de una base de datos vectorial. Estos permiten realizar consultas precisas, recuperando el fragmento exacto de información que mejor responda a una pregunta del usuario.

¿Cómo interactúan las consultas con la base de datos y los LLM?

Al realizar preguntas a la base de datos, esta recupera el fragmento más acorde a la consulta mediante los embeddings ya almacenados. Luego, esos fragmentos escogidos formarán un prompt para que un modelo de lenguaje large (LLM por sus siglas en inglés) presente una respuesta clara y directa al usuario.

Es importante reconocer que esta metodología permite a los LLM ofrecer respuestas comprensibles, incluso si la información inicial está fragmentada o incompleta, gracias a su capacidad de análisis.

¿Qué rol juega la indexación de datos?

Otro aspecto fundamental, mencionado brevemente en la clase, es la indexación de datos. Aunque este tema se explorará más profundamente en clases futuras, es crucial para optimizar la recuperación de fragmentos correctos durante una búsqueda en tales bases vectoriales.

Invito tu participación y comentarios sobre este tema para continuar profundizando juntos en el manejo avanzado de datos.